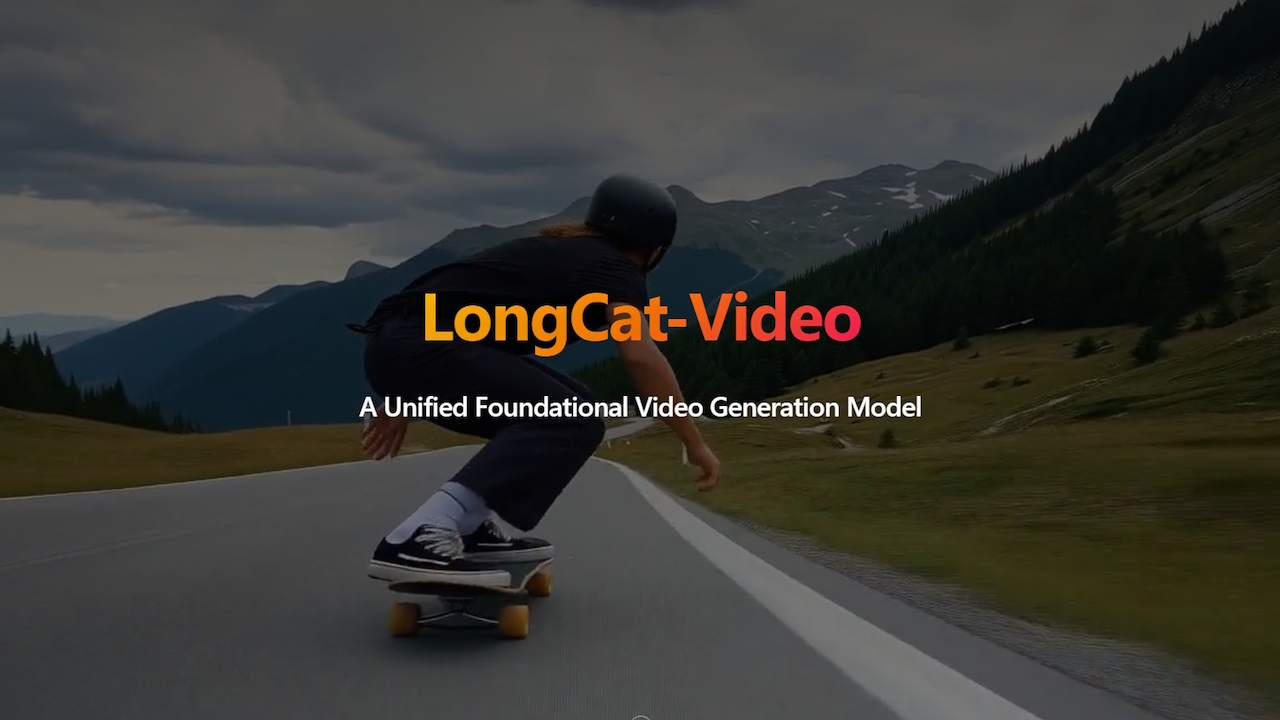

La société technologique chinoise Meituan a publié lundi un nouveau modèle vidéo d’IA, LongCat-Video, le rendant disponible gratuitement en tant que logiciel open source.

Son puissant modèle de 13,6 milliards de paramètres génère des vidéos de haute qualité d’une durée de quelques minutes à partir de texte ou d’images, un progrès significatif pour la technologie open source. Lancé sur des plateformes comme GitHub, LongCat-Video remet directement en question les modèles propriétaires d’OpenAI et de Google.

Meituan positionne cette version comme une étape clé vers le développement de « modèles mondiaux » plus avancés en résolvant des problèmes courants tels que la perte de qualité dans les vidéos IA de longue durée. La décision de Meituan rend les outils créatifs sophistiqués plus accessibles aux développeurs et aux chercheurs du monde entier.

Une architecture unifiée pour les vidéos longue durée

Dans un étape importante pour la communauté open source, Meituan a publié son générateur vidéo d’IA avancé, LongCat-Video, sous une licence permissive du MIT. Construit sur une puissante architecture de transformateur de diffusion (DiT), le modèle de paramètres 13.6B adapte la technologie de transformateur qui a révolutionné les modèles de langage pour la tâche complexe de génération vidéo. Son architecture offre un cadre polyvalent et unifié aux créateurs.

La conception de base de Meituan LongCat gère efficacement les tâches de conversion texte-vidéo, image-vidéo et de continuation vidéo au sein d’un seul système. Pour les utilisateurs, cela signifie un processus créatif plus fluide et intégré.

Un créateur peut commencer par une invite de texte pour générer une scène initiale, utiliser une image de référence pour animer un personnage spécifique dans cette scène, puis utiliser la suite vidéo pour prolonger l’action, le tout sans basculer entre différents outils.

🤯 Licence MIT + Cohérence de 5 minutes + Boost de vitesse 10x. Meituan vient d’ouvrir LongCat-Video (13,6B), un modèle de base vidéo SOTA qui est un concurrent sérieux pour la course World Model.

🎥 The Breakthrough : génère nativement jusqu’à 5 minutes de vidéos continues par pré-entraînement sur… pic.twitter.com/WuYPA9kuFV

— ModelScope (@ModelScope2022) 27 octobre 2025

En distinguant les tâches en fonction du nombre d’images initiales fournies, l’approche intégrée du modèle permet une transition transparente entre les différents modes de création, rationalisant ainsi le flux de production.

Résoudre le problème d’endurance : une vidéo d’une durée de quelques minutes sans dégradation

Pendant que Les systèmes propriétaires comme Sora 2 d’OpenAI ont récemment fait la une des journaux, l’approche de Meituan se concentre sur la résolution de l’un des défis les plus persistants de la vidéo IA : la durée.

De nombreux modèles souffrent d’une dégradation rapide de la qualité, où la cohérence temporelle est perdue et les artefacts visuels s’accumulent en quelques secondes seulement. La fonctionnalité remarquable de LongCat-Video est sa capacité à générer des vidéos stables d’une durée de quelques minutes avec une résolution fluide de 720p et 30 images par seconde.

Ses créateurs attribuent cette avancée au pré-entraînement du modèle spécifiquement sur les tâches de continuation vidéo, ce qui lui apprend à maintenir la cohérence au fil du temps. Selon l’équipe,”LongCat-Video est nativement pré-entraîné sur les tâches de continuation vidéo, ce qui lui permet de produire des vidéos d’une minute sans dérive de couleur ni dégradation de la qualité.”

En se concentrant sur la continuation, le modèle combat directement la dérive de couleur et la dégradation de l’image qui affectent souvent les vidéos d’IA, garantissant que les récits plus longs restent visuellement cohérents du début à la fin.

Pour y parvenir. Processus à forte intensité de calcul pratique, le modèle emploie plusieurs techniques axées sur l’efficacité. Comme l’explique Meituan,”LongCat-Video génère des vidéos 720p, 30 ips en quelques minutes en employant une stratégie de génération grossière à fine le long des axes temporel et spatial.”

Sa stratégie grossière à fine (C2F) est un processus en deux étapes : elle génère d’abord un”ébauche”de résolution inférieure de la vidéo, puis l’affine et la met à l’échelle intelligemment, en ajoutant des détails et texture.

C’est souvent plus rapide et donne de meilleurs résultats que de tenter de générer une vidéo haute résolution en une seule fois. De plus, LongCat-Video utilise Block Sparse Attention, une optimisation intelligente qui permet au modèle de concentrer sa puissance de calcul sur les parties les plus pertinentes de la séquence vidéo au lieu de traiter chaque relation de pixel, réduisant ainsi considérablement la charge de traitement.

Un concurrent Open Source dans la course à la vidéo AI

La sortie de Meituan le 27 octobre fait de LongCat-Video un concurrent immédiat et formidable concurrent open source dans un domaine dominé par les systèmes fermés.

Ses capacités le placent en concurrence directe avec le modèle Veo 3.1 récemment mis à jour de Google et Sora 2 d’OpenAI. Le lancement de Sora 2, bien que techniquement impressionnant, a également déclenché un débat généralisé sur les deepfakes et la sécurité de l’IA, créant une ouverture pour une alternative plus transparente et axée sur les développeurs.

Mesures de performance issues des techniques du modèle. le rapport montre qu’il tient le coup. Sur le benchmark VBench 2.0, LongCat-Video a obtenu un score total de 62,11 %. Il a notamment surpassé tous les concurrents testés dans la dimension « Commonsense » avec un score de 70,94 %, ce qui suggère une solide compréhension du réalisme physique et des mouvements plausibles.

La société présente le projet comme une évolution stratégique vers des objectifs plus ambitieux.”La génération vidéo est une voie essentielle vers des modèles mondiaux, avec une inférence vidéo longue et efficace comme capacité clé”, a noté l’équipe Meituan LongCat.

La vision de Meituan s’oriente vers le développement de « modèles mondiaux » : des systèmes d’IA dotés d’une compréhension fondamentale de la physique, des causes et effets et de la permanence des objets qui peuvent simuler la réalité. LongCat-Video représente une étape critique dans l’expression visuelle de ces connaissances simulées.

Outre ses puissantes capacités, la grande taille du modèle constitue un obstacle matériel important pour les chercheurs individuels et les amateurs. Des questions persistantes subsistent quant à la provenance du vaste ensemble de données vidéo utilisé pour la formation, un sujet sensible dans l’industrie de l’IA générative.

La décision de Meituan stimulera probablement l’innovation dans la communauté open source et augmentera la pression sur les développeurs propriétaires pour qu’ils proposent des solutions plus accessibles.

Alors que les développeurs commencent à intégrer LongCat-Video dans leurs flux de travail, son impact réel sur les industries créatives et ses La capacité à repousser les limites de la narration basée sur l’IA deviendra plus claire.