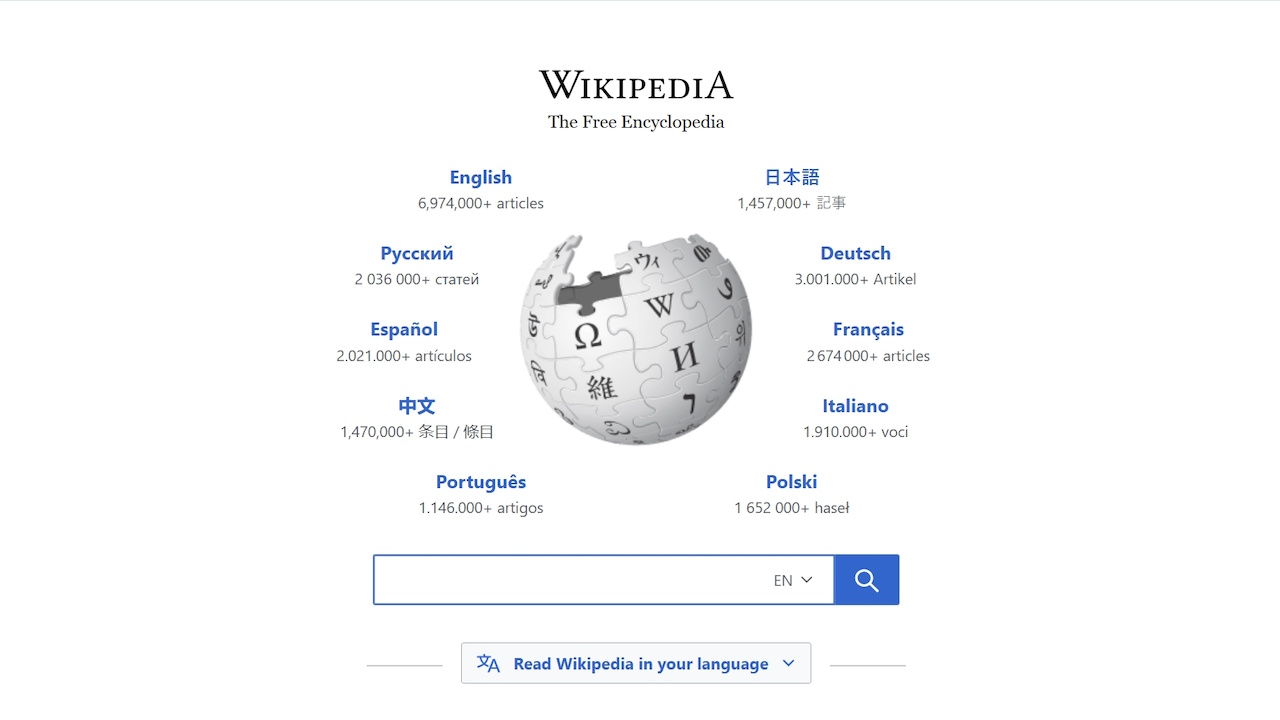

La Fondation Wikimedia a tiré la sonnette d’alarme face à une baisse significative du nombre de visiteurs humains sur Wikipédia. Dans un communiqué du 17 octobre, l’organisation à but non lucratif a révélé une baisse de 8 % des pages vues au cours des derniers mois par rapport à la même période en 2024.

L’organisation pointe directement du doigt le secteur en plein essor. industrie de l’IA générative. Les moteurs de recherche et les chatbots IA exploitent et résument de plus en plus le vaste référentiel de connaissances de Wikipédia, fournissant ainsi des réponses directes aux utilisateurs. Cette commodité a un coût, car elle détourne le trafic de la source.

Cette tendance menace les fondements mêmes de l’encyclopédie participative. La fondation prévient que ce déclin n’est pas seulement un indicateur de vanité ; cela représente un risque critique pour la durabilité à long terme de la plateforme.

« Avec moins de visites sur Wikipédia, moins de bénévoles peuvent développer et enrichir le contenu, et moins de donateurs individuels peuvent soutenir ce travail », a déclaré Marshall Miller, Directeur principal des produits de Wikimedia.

Une relation symbiotique devient parasitaire

La découverte de cette tendance troublante a commencé par une anomalie statistique. Selon la Fondation Wikimedia, ses analystes ont remarqué pour la première fois des quantités inhabituellement élevées de trafic apparemment humain à partir de mai 2025 environ, dont une grande partie provenait du Brésil.

Ce pic a déclenché une enquête plus approfondie sur les données de trafic du site et sur les systèmes de détection des robots, qui sont constamment mis à jour pour contrer les agents automatisés de plus en plus sophistiqués.

Cette enquête a révélé ce que Wikimedia a décrit comme un « nouveau modèle de comportement des robots, conçu pour paraître humain ». Après avoir repensé leurs systèmes pour filtrer ces robots furtifs et reclassé les données de trafic de mars à août, la véritable image est apparue : un déclin significatif et soutenu des pages vues humaines réelles.

Le pic de trafic initial n’était pas un signe de croissance, mais un masque cachant un problème plus grave.

Cette dynamique met en évidence une relation croissante, et potentiellement parasitaire, au sein de l’écosystème numérique. Alors que presque tous les grands modèles linguistiques (LLM) dépendent fortement des vastes ensembles de données de Wikipédia pour leur formation, les plates-formes qui les déploient ne leur rendent pas la pareille.

Au lieu de cela, les moteurs de recherche et les chatbots IA fournissent des réponses résumées directement aux utilisateurs, éliminant ainsi le besoin de cliquer sur l’article source.

Ce n’est pas seulement anecdotique ; il s’agit d’un changement mesurable à l’échelle de l’industrie. Des recherches menées par des organismes externes ont confirmé comment l’IA cannibalise directement le lectorat de Wikipédia, et de nombreux autres éditeurs en ligne signalent des baisses de trafic similaires.

Un rapport de recherche de 2025 de la Columbia Business School explicitement a signalé que ChatGPT « semble cannibaliser l’attention de Wikipédia sur certains sujets ». L’étude a examiné les requêtes d’information qui se chevauchent et a constaté que lorsque les utilisateurs se tournaient vers ChatGPT pour obtenir des réponses factuelles, les pages Wikipédia consultées sur ces sujets diminuaient.

Le problème central est l’érosion du principe fondamental du Web ouvert de citation et d’engagement direct avec le matériel source.

Pour Wikipédia, qui est soutenu par des donateurs plutôt que par des revenus publicitaires, la menace est existentielle. Le problème est la dégradation de sa boucle de rétroaction humaine. Moins de visiteurs signifie un bassin plus restreint à partir duquel recruter de nouveaux rédacteurs bénévoles, vérificateurs de faits et modérateurs de communauté.

Cela risque de créer un cercle vicieux dans lequel moins de surveillance humaine pourrait conduire à une baisse de la qualité, érodant encore davantage la confiance du public qui fait de Wikipédia une pierre angulaire d’Internet.

La stratégie multi-faces de Wikipédia : conservation, données sanctionnées et Evolution

En interne, Wikipédia mène déjà une guerre sur un autre front : la « slop de l’IA ». L’afflux de contenus de mauvaise qualité et non révisés générés par les LLM a été décrit par un volontaire comme une « menace existentielle ». Ce déluge menace de submerger les processus de modération humaine du site.

En réponse directe, la communauté des bénévoles a adopté une politique de « suppression rapide » en août 2025. Connue sous le nom de G15, elle permet aux administrateurs de supprimer rapidement les articles présentant des indices évidents de génération d’IA, comme des citations fabriquées ou des artefacts conversationnels.

La stratégie de la fondation n’est pas purement défensive. Il a adopté une approche centrée sur l’humain pour son propre développement d’IA, en se concentrant sur des outils qui aident les éditeurs plutôt que de les remplacer. Comme l’a déclaré Chris Albon, directeur du Machine Learning, « nous pensons que nos futurs travaux avec l’IA seront couronnés de succès non seulement grâce à ce que nous faisons, mais aussi à la manière dont nous le faisons. »

Wikimedia Enterprise propose également une alternative approuvée au grattage chaotique des données. En publiant des ensembles de données structurés sur des plates-formes telles que Kaggle de Google, elle offre aux développeurs un moyen propre et efficace d’accéder au contenu, allégeant potentiellement la pression sur ses serveurs.

Pour rester pertinente, la fondation explore également de nouvelles façons d’atteindre le public. Les initiatives incluent des équipes dédiées axées sur la croissance des lecteurs, un accent sur l’édition mobile, et le projet « Future Audiences » pour impliquer les jeunes utilisateurs sur des plateformes comme TikTok et YouTube.

Pressions externes Monter au milieu d’une crise d’identité

Ce défi existentiel survient alors que Wikipédia résiste aux critiques provenant de plusieurs directions. Le magnat de la technologie Elon Musk a annoncé en septembre 2025 son intention de créer une encyclopédie rivale appelée « Grokipedia ». Il a présenté l’alternative basée sur l’IA comme un moyen de contrer les préjugés perçus sur la plate-forme.

Musc envisage que Grok « réécrive la page pour corriger, supprimer les mensonges, corriger les demi-vérités et ajouter le contexte manquant », un défi direct au modèle éditorial dirigé par l’homme de Wikipédia.

Nous construisons Grokipedia @xAI.

Ce sera une amélioration considérable par rapport à Wikipédia.

Franchement, c’est une étape nécessaire vers l’objectif de xAI de comprendre l’Univers. https://t.co/xvSeWkpALy

— Elon Musk (@elonmusk) 30 septembre 2025

Pourtant, les critiques notent que le contenu généré par l’IA peut comporter ses propres biais importants, et que Grok lui-même a eu des problèmes d’exactitude.

La plateforme a également fait l’objet d’un examen minutieux de la part des autorités américaines en raison de son statut d’organisation à but non lucratif et de son influence étrangère présumée, notamment en ce qui concerne les modifications sur des sujets politiquement sensibles. Ces pressions aggravent le défi de maintenir une source d’information neutre et fiable dans un monde polarisé.

En fin de compte, Wikimedia plaide en faveur d’un écosystème Internet plus sain. Miller a exhorté les plateformes utilisant ses données à fournir une attribution claire et à encourager les utilisateurs à visiter la source. Pour les utilisateurs quotidiens, le conseil était simple :”Lorsque vous recherchez des informations en ligne, recherchez des citations et cliquez sur la source originale.”