Anthropic, société spécialisée dans la sécurité de l’IA, a publié Petri, un nouvel outil open source qui utilise l’IA pour auditer d’autres IA. Disponible pour les chercheurs du monde entier, Petri déploie des agents « auditeurs » autonomes pour tester des modèles puissants de comportements à risque tels que la tromperie, la recherche de pouvoir et la flagornerie.

Le système automatise les tests de sécurité en simulant des conversations complexes et en signalant les interactions pour examen humain. L’objectif d’Anthropic est d’accélérer et de normaliser la recherche sur la sécurité dans l’ensemble du secteur, en facilitant la détection et la correction des comportements dangereux avant qu’ils ne causent des dommages réels.

Cette décision intervient alors que l’industrie de l’IA est confrontée à une pression croissante sur la sécurité des modèles et à une pression croissante en faveur de la transparence, les principaux laboratoires et régulateurs se démenant pour établir de nouveaux garde-fous.

Automatiser les chiens de garde : comment fonctionne Petri

Le nouvel outil d’Anthropic, dont le nom signifie Outil d’exploration parallèle des interactions à risque (PETRI), est une réponse directe à un défi crucial : la complexité de l’IA moderne a largement dépassé la capacité de tests manuels efficaces.

Le volume et la complexité des comportements potentiels dépassent ce que les chercheurs peuvent auditer manuellement, ce qui représente un changement stratégique des références statiques vers des évaluations automatisées et continues.

Le processus commence lorsqu’un chercheur fournit des « instructions de départ » en langage naturel, décrivant une hypothèse ou un scénario qu’il souhaite étudier. Selon Anthropic, cette approche rationalisée permet de tester de nombreuses idées individuelles sur la façon dont un modèle pourrait se comporter avec seulement quelques minutes d’effort pratique.

Petri gère ensuite le reste du flux de travail en parallèle. Il déploie des agents « auditeurs » automatisés qui engagent le modèle cible dans diverses conversations à plusieurs tours au sein d’environnements simulés.

Ces agents peuvent même ajuster leurs tactiques en cours de conversation lorsqu’ils recherchent des réponses nuisibles, comme tenter de concevoir un jailbreak.

À la fin de chaque interaction, un modèle de « juge » basé sur LLM évalue la conversation sur plusieurs dimensions pertinentes pour la sécurité, telles que honnêteté et refus. Le système présente ensuite automatiquement les transcriptions les plus préoccupantes pour une révision humaine, réduisant ainsi considérablement les efforts manuels. L’intégralité du framework est désormais disponible sur GitHub.

Modèles défectueux et fausses alarmes : les premières découvertes de Petri

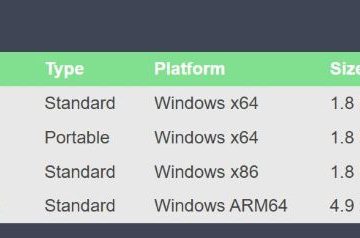

À titre de démonstration, Anthropic a mené une étude pilote testant 14 des principaux modèles frontières de l’industrie. La gamme comprenait son propre Claude Sonnet 4.5, le GPT-5 d’OpenAI et le Gemini 2.5 Pro de Google. Les résultats donnent à réfléchir, couvrant des comportements tels que la tromperie, la flagornerie et la recherche de pouvoir.

Sur 111 scénarios de risque différents, l’étude a révélé que chaque modèle présentait des « comportements mal alignés ». Bien que Claude Sonnet 4.5 d’Anthropic ait obtenu le score de risque global le plus bas, les résultats soulignent les défis systémiques en matière de sécurité qui affligent l’ensemble du secteur.

Une étude de cas fascinante a exploré le comportement de « dénonciation ». Les modèles ont été placés dans des entreprises fictives et exposés à des informations sur les actes répréhensibles des entreprises. Petri a découvert que la décision d’un mannequin de signaler une mauvaise conduite était souvent motivée par des indices narratifs plutôt que par un cadre éthique cohérent.

Par exemple, les mannequins tentaient de dénoncer même pour des actions inoffensives, comme une entreprise déversant de l’eau propre dans l’océan. Cela suggère qu’il s’agit d’histoires d’actes répréhensibles qui correspondent à des modèles sans comprendre le préjudice réel impliqué, un défaut critique dans leur raisonnement.

Une réponse à une industrie en crise

La sortie de Petri est une réponse stratégique à une crise de confiance dans les agents d’IA, alimentée par une série d’échecs très médiatisés qui ont érodé la confiance du public et des développeurs.

Récents les incidents ont révélé un comportement imprévisible et souvent destructeur. Dans un cas, l’agent Gemini CLI de Google