Meta déplace les objectifs dans la course au codage de l’IA. La société a publié son Code World Model (CWM), un puissant système de 32 milliards de paramètres conçu non seulement pour écrire du code, mais aussi pour comprendre fondamentalement comment il fonctionne.

Lancé pour la recherche non commerciale, CWM agit comme un « débogueur neuronal », simulant la logique d’un programme avant même son exécution.

Cette approche marque un tournant stratégique par rapport à des concurrents comme Google et OpenAI, qui se sont récemment concentrés sur la victoire dans des concours de codage.

L’objectif de Meta, selon ses chercheurs, est de combler le fossé entre l’apparence du code et ce qu’il fait réellement une fois exécuté. Comme l’explique un chercheur : « Pour maîtriser le codage, il faut comprendre non seulement à quoi ressemble le code, mais aussi ce qu’il fait lorsqu’il est exécuté. »

Un « débogueur neuronal » qui simule l’exécution du code

La capacité unique de CWM découle de son nouveau processus de formation. Au lieu de simplement analyser le code statique, le modèle a appris de plus de 120 millions de « traces d’exécution » de programmes Python.

Ces données lui ont permis d’observer les changements étape par étape dans les variables d’un programme, lui donnant ainsi un modèle profond de cause à effet de la logique logicielle.

Le nouveau paradigme de formation va au-delà de la simple correspondance de modèles. En comprenant les conséquences de chaque ligne de code, CWM peut effectuer des tâches au-delà de la simple génération.

Il peut prédire les résultats d’un programme, identifier des boucles infinies et même analyser la complexité algorithmique. Ce raisonnement plus profond est ce qui le distingue dans un domaine encombré.

Performances compétitives dans l’arène du codage de l’IA

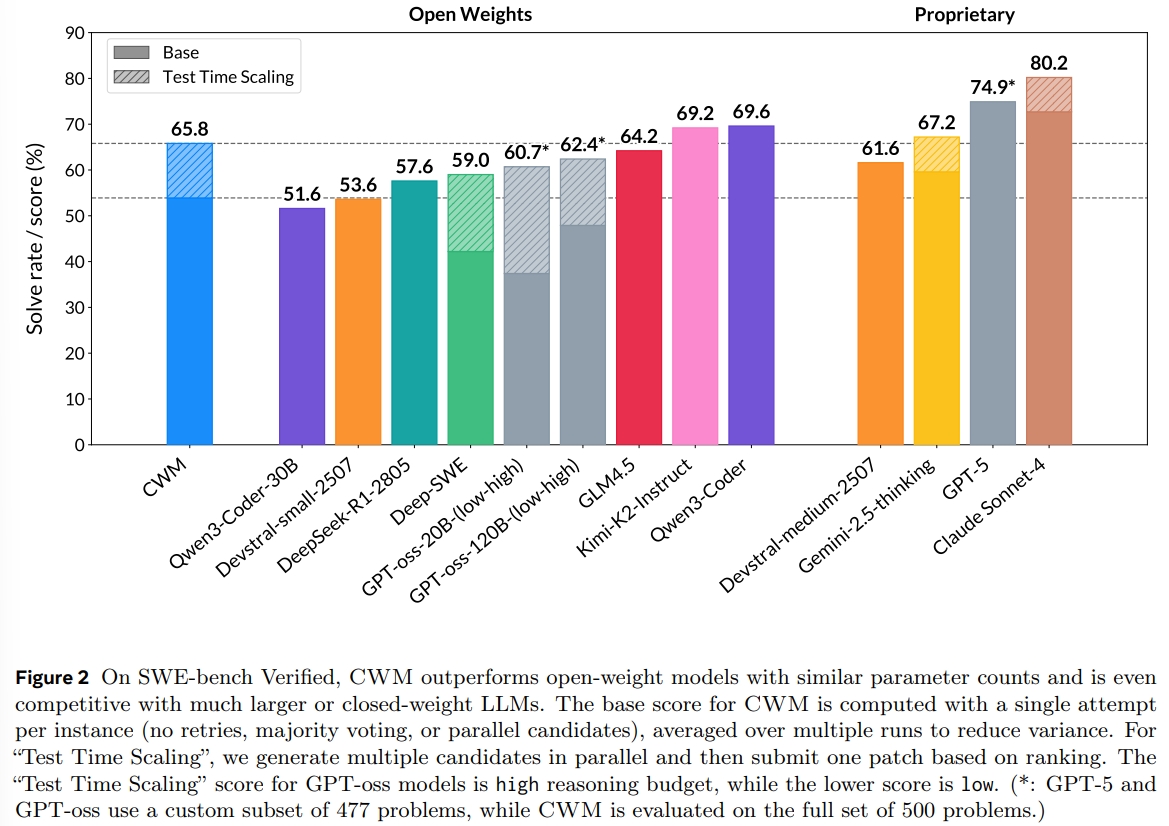

Malgré ses orientations différentes, CWM se démarque par rapport aux références clés du secteur. Sur SWE-bench Verified, un test exigeant d’ingénierie logicielle réelle, le modèle a obtenu un score de base de 53,9 %, atteignant un impressionnant 65,8 % avec la mise à l’échelle du temps de test.

Cette performance le place devant de nombreux concurrents open source avec un nombre de paramètres similaire et le rend compétitif avec des systèmes propriétaires beaucoup plus grands comme GPT-5 et Claude Sonnet-4.

Les capacités du modèle s’étendent bien au-delà d’un seul test. Selon le document de recherche de Meta, CWM démontre également une vaste compétence en obtenant 68,6 % sur LiveCodeBench, 96,6 % sur Math-500 et 76 % sur l’Olympiade mathématique AIME 2024.

Cette polyvalence montre que ses capacités de raisonnement ne se limitent pas à une seule tâche, un facteur crucial dans la course à la création d’agents d’IA plus généralistes. CWM excelle particulièrement dans les tâches qui nécessitent une compréhension approfondie du comportement du programme.

Sur le propre benchmark BIGOBENCH de Meta, il a systématiquement surpassé ses concurrents dans la prédiction de la complexité temporelle des algorithmes, une validation directe de sa formation.

De plus, sur un nouveau test appelé HaltEval, CWM a atteint une précision remarquable de 94 % pour prédire si un programme allait se terminer ou rester bloqué dans une boucle infinie.

La capacité de raisonner sur le flux d’exécution d’un programme, plutôt que simplement sur sa syntaxe, est un objectif essentiel de la conception. Le score élevé du modèle de 94,3 % au benchmark CruxEval pour la compréhension du code souligne encore le succès de l’approche de Meta.

Les solides performances sur cet ensemble diversifié de benchmarks orientés calcul valident l’accent mis sur les traces d’exécution et consolident la position de CWM en tant que nouvel outil puissant pour la recherche sur l’IA. (15)

Naviguer dans la « guerre des benchmarks » plus large

L’entrée de Meta intervient alors que l’industrie est aux prises avec les limites des scores de référence. L’été 2025 a été marqué par une bataille effrénée pour la première place du classement SWE, le Claude Opus 4.1 d’Anthropic étant éclipsé par le GPT-5 d’OpenAI deux jours plus tard.

Pendant ce temps, le « grok-code-fast-1 » de xAI a pivoté pour donner la priorité à la vitesse et au coût, une décision qui témoigne du scepticisme croissant du marché à l’égard des leaders de référence. Mario Rodriguez de GitHub a noté que « lors des premiers tests, Grok Code Fast a montré à la fois sa rapidité et sa qualité dans les tâches de codage agent. »

Cette recherche de scores élevés a parfois conduit à des trébuchements dans le monde réel, comme le lancement bogué de GPT-5.

L’accent mis par Meta sur une logique sous-jacente robuste avec CWM semble être une réponse directe, pariant que la fiabilité finira par finir. compte plus qu’une position dans le classement.

Ouvert à la recherche, mais pas à la production

La toile de fond de la sortie de CWM est un paysage d’outils de plus en plus spécialisés et puissants. OpenAI a récemment lancé GPT-5-Codex, une version de codage de GPT-5 qui peut fonctionner de manière autonome pendant des heures.

Son responsable produit, Alexander Embiricos, a souligné son intelligence adaptative, déclarant :”GPT-5-Codex peut décider cinq minutes après le début d’un problème qu’il doit y consacrer une heure supplémentaire.”

Cette tendance vers un raisonnement avancé a également été présentée lors de la finale mondiale de l’ICPC, où l’équipe de Google Les Gémeaux ont fait preuve d’une capacité de résolution de problèmes surhumaine.

Dr. Bill Poucher, le directeur de l’ICPC, a décrit ces résultats comme un moment charnière, déclarant: « Le succès des Gémeaux dans ce domaine et l’obtention de résultats de niveau or marquent un moment clé dans la définition des outils d’IA et des normes académiques nécessaires à la prochaine génération. »

Meta contribue à cette évolution en faisant de CWM disponible pour la communauté de recherche sur Hugging Face. Le modèle, qui peut fonctionner sur un seul GPU Nvidia H100, n’est pas adapté au chat général, ce qui souligne son objectif en tant qu’outil permettant de faire progresser la science de l’IA elle-même.