Google améliore son assistant Gemini AI avec une mémoire persistante et automatique, ce qui lui permet d’apprendre des conversations passées pour fournir des réponses plus personnalisées. La mise à jour vise à créer un assistant plus puissant et proactif qui comprend les préférences des utilisateurs sans avoir besoin de rappels constants.

Pour répondre aux problèmes de confidentialité, la société lance simultanément des «chats temporaires», une fonctionnalité pour les conversations qui ne sont pas enregistrées ou utilisées pour la personnalisation. Ce mouvement, qui permet la fonction de mémoire principale par défaut mais fournit des contrôles utilisateur clairs, dégénère la course aux armements AI.

Il place les Gemini en concurrence directe avec des fonctionnalités similaires basées sur la mémoire récemment déployées par des rivaux comme Openai, anthropic et Microsoft pour leurs chatbots AI respectifs.

gemini obtient une mémoire-et il est toujours sur

La dernière mise à jour de Google Modifie fondamentalement la façon dont Gemini interagit avec les utilisateurs, réalisant une vision décrite lors de sa conférence I/O pour créer un AI qui vous comprend vraiment. La nouvelle fonction de mémoire, qui est activée par défaut, permet à l’assistant de rappeler automatiquement les détails et les préférences clés des chats passés au fil du temps.

Cet apprentissage automatique s’étend considérablement sur la fonction de mémoire plus manuelle introduite en février 2025, ce qui obligeait les utilisateurs à gérer plus activement le processus de rappel. Maintenant, les Gémeaux sont conçus pour apprendre de manière organique, rendant les conversations plus naturelles et conscientes du contexte, comme si vous collaboriez avec un partenaire qui est déjà au courant.

dans la pratique, cela signifie que si vous avez déjà discuté d’une idée de la chaîne YouTube sur la culture japonaise, Gemini pourrait ensuite suggérer un thème vidéo sur l’essai d’essayer des aliments japonais. The goal, according to Michael Siliski, a Senior Director for the Gemini app, is to ensure “the Gemini app can now reference your past chats to learn your preferences, delivering more personalized responses the more you use it.”

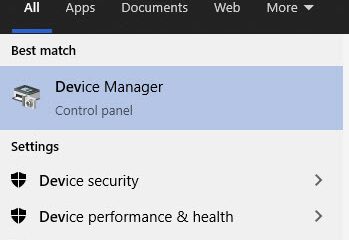

Google is rolling out the feature over the coming weeks, with it being initialement disponible pour le modèle 2.5 Pro dans certains pays Avant de se développer au modèle Flash 2.5. Les utilisateurs peuvent trouver le contrôle sous Paramètres dans le menu”Contexte personnel”.

Les nouveaux outils de confidentialité offrent une trappe d’évacuation

pour contrebalancer la nature”sur les nouveaux contrôles des utilisateurs conçus pour donner aux utilisateurs une trappe d’évasion pour leurs données. Le plus important d’entre eux est les «chats temporaires», un mode éphémère pour les requêtes sensibles ou ponctuelles . Cette fonctionnalité est idéale pour les moments où un utilisateur souhaite explorer des questions privées ou réfléchir à des idées en dehors de son style habituel sans cette conversation influençant les interactions futures.

Quand dans un Chat temporaire href=”https://support.google.com/gemini/answer/13666746″Target=”_ Blank”> Liste des chats récents ou leur GeminI Applay Activity . Surtout, Google confirme que ces données ne seront pas utilisées pour personnaliser l’expérience Gemini ou pour former ses modèles d’IA. Les chats sont conservés pendant un maximum de 72 heures, une fenêtre que Google dit est à des fins opérationnelles et pour traiter les commentaires de l’utilisateur, avant d’être supprimé.

De plus, Google renommage son réglage de”l’activité des applications Gemini”pour”maintenir l’activité”pour une plus grande transparence. Si un utilisateur permet cette option, Google utilisera un échantillon de ses futurs téléchargements de fichiers et de photos pour améliorer ses services, une modification qui s’appliquera au contenu téléchargé à partir du 2 septembre 2025. Ce paramètre est désactivé, et les utilisateurs qui ont précédemment désactivé l’activité des applications de Gémini trouveront le paramètre”Keep Activity”. Verge. Il a déclaré Les utilisateurs peuvent Désactiver la fonction de mémoire ou gérer les données stockées À tout moment via leurs paramètres et en savoir plus dans la Gemini Apps Confidential Hub .

La course à la dernière fois que le dernier AI

Une bataille escalaquante entre les géants de la technologie pour rendre leurs assistants IA indispensables, avec une mémoire persistante et consciente de son contexte comme le champ de bataille clé en 2025. La fonctionnalité est désormais une capacité de table, et l’approche toujours-on”de Google le place dans la concurrence directe avec des rivaux qui ont agressivement poursuivi un peu de fonctionnalité pour la loyalité. Chatgpt. Après avoir testé les capacités de mémoire au début de 2024, il a mis à niveau son système en avril 2025 pour référencer implicitement l’historique de chat d’un utilisateur. Il a en outre approfondi cette intégration en permettant à sa mémoire de personnaliser les requêtes de recherche Web du chatbot, créant un profil complet des préférences des utilisateurs au fil du temps.

Le reste de l’industrie a rapidement emboîté le pas. En avril 2025, Microsoft a intégré une fonction de mémoire dans son assistant Copilot dans le cadre d’une mise à niveau massive de plate-forme. Ce même mois, Xai d’Elon Musk a déployé une capacité similaire pour son chatbot Grok, soulignant dans son annonce que les utilisateurs pourraient voir exactement ce que l’AI sait et choisir ce qu’il devrait oublier.

Cependant, tous les joueurs ne suivent pas le même manuel”toujours”. Anthropic a récemment introduit une fonction de mémoire pour son chatbot Claude qui est en contraste. Selon le porte-parole Ryan Donegan,”Ce n’est pas encore une fonction de mémoire persistante comme le chatppt d’Openai. Claude ne fera que récupérer et référencer vos chats passés lorsque vous le demandez de…”Ce modèle initié par l’utilisateur, qui s’aligne sur le cadre de la sécurité publique de l’entreprise, positionne Claude comme un moyen de confidentialité de la confidentialité. Risques

La poussée pour la mémoire d’IA persistante introduit des défis de sécurité et éthiques importants. La possibilité de stocker et de rappeler les données des utilisateurs crée une cible précieuse pour les acteurs malveillants. Le chercheur de cybersécurité Johann Rehberger a démontré comment ces systèmes peuvent être exploités.

Il a constaté que la mémoire des Gémeaux pouvait être manipulée par «invocation retardée de l’outil», une technique qui incorpore les commandes dormantes dans des documents. Rehberger a expliqué le risque, déclarant: «Lorsque l’utilisateur dit plus tard \”x \”[pour la commande programmée], Gemini, pensant qu’il suit l’instruction directe de l’utilisateur, exécute l’outil”, qui pourrait corrompre la mémoire à long terme de l’AI avec de fausses informations.

Vulnérabilités similaires ont été trouvées dans la mémoire de Chatgpt, où des attaques insignifiantes rapides ont été utilisées pour exprimer des données exfulatrices. Ces incidents, ainsi que Rapports sur les comportements «illusionnels» des comportements de développement «illusional» avec un fonctionnement de la fonctionnalité dans le développement de l’AI: Balginf Sécurité.

Les défenseurs de la confidentialité ont également soulevé des alarmes. Some experts have criticized “on-by-default”memory settings, arguing they create persistent risks for users who may not be fully aware of how their data is being Utilisé .

Bien que Google insiste sur le fait que ses contrôles sont suffisants, la course à l’échelle de l’industrie pour l’IA plus intelligente garantit que le débat sur la confidentialité et la sécurité des données ne fera que s’intensifier. Trouver le bon équilibre sera essentiel pour maintenir la confiance des utilisateurs dans un monde numérique de plus en plus intelligent et autonome.