Anthropic is intensifying the AI context window race, upgrading its Claude Sonnet 4 model to handle 1 million tokens. Disponible maintenant en bêta publique , le déménagement met anthropic en concurrence directe avec l’Openai API GPT-5 et META a annoncé que les développeurs de 10 millions de personnes ont annoncé la plus grande capacité, la plus grande capacité. Analyser des bases de code entières ou de grands ensembles de documents à la fois. Cette poussée à l’échelle de l’industrie est tout comme des études récentes sur la «pourriture du contexte» suggèrent que les performances du modèle peuvent s’aggraver avec de longues entrées, soulevant des questions sur la stratégie.

Anthrope rejoint le club à million

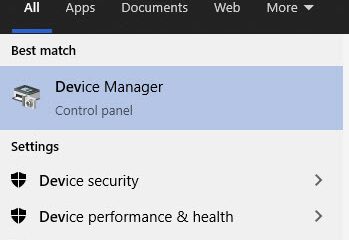

La mise à niveau de Claude Sonnet 4, représentant une augmentation de la capacité de cinq fois, est désormais accessible en bêta public par le bêta publique par le API anthropique officielle Et le substratum rocheux d’Amazon. La société a également confirmé que la fonctionnalité arrivera bientôt sur Google Cloud’s Vertex IA, élargissant sa disponibilité pour les développeurs d’entreprises. Anthropic is positioning this enhancement for a new class of complex, data-intensive applications that were previously impractical.

According to the company, the expanded context window enables more comprehensive use cases. For developers, this means the ability to perform large-scale code analysis by loading entire codebases, allowing the model to understand project architecture and identify cross-file dependencies. Pour les chercheurs et les analystes, il permet la synthèse de vastes ensembles de documents, tels que des contrats juridiques ou des spécifications techniques, tout en maintenant un contexte complet sur des centaines de sources. It also empowers the creation of more sophisticated, context-aware agents that can maintain coherence across hundreds of tool calls and multi-step workflows.

Early adopters have praised the new capability for its impact on real-world projects. Bolt.New, une entreprise qui intègre Claude dans sa plate-forme de développement basée sur un navigateur, a souligné la surperformance continue des concurrents du modèle. Eric Simons, PDG et co-fondateur de la société, a déclaré que «avec la fenêtre de contexte 1M, les développeurs peuvent désormais travailler sur des projets beaucoup plus importants tout en maintenant la haute précision dont nous avons besoin pour le codage du monde réel». Sean Ward, PDG et co-fondateur de IGent AI, a décrit la mise à jour comme un changement fondamental, notant qu’elle permet de «véritable ingénierie à l’échelle de la production-des sessions de la journée sur l’ingénierie logicielle agentique. Le paysage concurrentiel comprend déjà Minimax, basé à Singapour, qui a dévoilé un modèle de jeton de 4 millions en janvier, créant une barre haute pour l’industrie. Il comprend également Meta, dont le modèle LLAMA 4 Scout possède une capacité de jeton de 10 millions, repoussant les limites du traitement à long contexte.

Sous le capot: Claude Sonnet 4 contre GPT-5 API

anthropic La tarification de la nouvelle fonctionnalité est à plusieurs niveaux . Pour provoquer jusqu’à 200 000 jetons, le coût est de 3 $ par million de jetons d’entrée. Pour des invites plus importantes, le prix double à 6 $ par million de jetons d’entrée. Cette structure est conçue pour gérer la charge de calcul accrue de contextes plus longs.

Cela contraste avec l’approche d’OpenAI pour son GPT-5 récemment lancé. Bien que ses interfaces Web aient des limites plus petites, l’API GPT-5 propose une fenêtre de contexte maximale de 400 000 jetons. Ce niveau supérieur est réservé exclusivement aux utilisateurs d’API, ciblant les développeurs de création d’applications qui nécessitent une analyse de documents profonds. Gemini 2.5 Pro de Google prend en charge une fenêtre de contexte de jusqu’à 1 million de jetons.

Le problème de «pourriture du contexte»: est-il toujours plus grand?

Alors que l’industrie se dirige vers des fenêtres de contexte toujours plus grand, un ensemble croissant de recherches suggère que le simple fait d’augmenter la taille des entrées ne garantit pas de meilleures performances. Un rapport récent de Chroma Research a introduit le concept de «pourriture du contexte», contestant le récit «plus grand est un meilleur».

L’étude est passée au-delà des tests simples «aiguille dans une botte de foin», qui ne mesurent que la récupération des données. Au lieu de cela, il a testé 18 LLMS de premier plan sur leur capacité à faire des inférences à partir d’informations sémantiquement liées, une tâche beaucoup plus difficile. Les chercheurs ont noté: «Nous démontrons que même dans ces conditions minimales, les performances du modèle se dégradent à mesure que la longueur d’entrée augmente, souvent de manière surprenante et non uniforme.»

Par exemple, les modèles ont été invités à déduire l’emplacement d’un personnage à partir d’indices indirects, une tâche où les performances ont fortement chuté à mesure que plus de texte distrayant a été ajouté. L’étude a également révélé que les modèles GPT avaient tendance à halluciner de mauvaises réponses, tandis que les modèles de Claude refusaient souvent de répondre face à l’ambiguïté.

Étonnamment, l’étude de chroma a révélé que les modèles fonctionnaient mieux lorsque le texte a été mélangé au hasard, suggérant que la structure d’entrée influence fortement l’attention du modèle. These findings are not isolated. Une étude conjointe de Microsoft et Salesforce a signalé une baisse de performance de 39% dans les conversations longues et multiples.

Les modèles même avec d’énormes limites théoriques sont confrontés à des défis pratiques. Meta’s Llama 4, malgré sa fenêtre de jeton de 10 millions, aurait eu du mal sur des références à petit contexte. Cela a conduit certains, comme le chercheur d’IA, Gary Marcus, à remettre en question toute l’approche. Il a fait valoir: «Personne avec l’intégrité intellectuelle ne peut toujours croire que la mise à l’échelle pure nous amènera à AGI.»

Ces preuves suggèrent que «l’ingénierie contextuelle»-la conservation minutieuse des données pertinentes de haute qualité-peut être plus critique pour une IA fiable que l’expansion brute de la force brute des fenêtres de contexte. À mesure que les développeurs ont accès à ces nouveaux outils puissants, l’accent peut passer de la quantité de données qu’un modèle peut gérer à la façon dont ces données sont préparées.