Dans la course féroce pour la suprématie de l’IA, le XAI d’Elon Musk a visé directement son rival Anthropic. Un nouveau rapport montre que début juillet, Xai a embauché des entrepreneurs pour former son modèle Grok avec un objectif clair: battre le claude d’Anthropic sur un classement public codant.

Les documents internes ont déclaré aux travailleurs de la plate-forme AI à l’échelle pour aider Grok à gravir les rangs de l’influence WebDev Arena. Cette décision montre la pression intense sur les laboratoires AI pour les principaux benchmarks publics, qui agissent comme un tableau de bord clé pour attirer l’investissement et les clients.

liés: est-ce que Grok 4 est juste un gagnant de référence? Le modèle phare de Xai augmente les drapeaux rouges, semble fortement trop élevé pour bien marquer

Cet focus est mis en place alors que les performances du monde réel de Grok 4 sont confrontées à des questions difficiles des utilisateurs.

Une bataille combattu sur les classements publics

Selon à Business Insider, les instructions du projet étaient sans ambiguïté. Les entrepreneurs ont été chargés de «Hillclimb» le classement de Grok, avec un document d’intégration de l’IA à l’échelle indiquant: «Nous voulons faire du modèle en tâche le modèle n ° 1. L’objectif spécifique était «Sonnet 3.7 étendu» d’Anthropic, identifiant l’entreprise comme un rival clé dans l’espace de codage de l’IA.

Cette stratégie souligne l’immense influence des classements publics dans la formation du récit de l’IA. Pour des laboratoires comme Xai, Anthropic et Openai, une première place sur un graphique respecté comme Lmarena peut se traduire directement dans le buzz des médias, les contrats d’entreprise et une évaluation plus élevée.

Le choix de la cible est révélateur. Anthropic a systématiquement positionné ses modèles Claude en tant qu’assistants de codage de haut niveau, une réclamation soutenue par de solides performances de référence et l’adoption des développeurs. Cela en fait le rival de facto à battre.

Pratique standard ou jeu du système?

La pratique de former intensément un modèle sur des formats de test spécifiques soulève des questions. Est-ce une méthode légitime pour améliorer un modèle, ou est-ce simplement enseigné au test pour jouer le classement? La communauté de l’IA reste divisée sur la question.

Certains experts le voient comme une partie normale du cycle de développement. Le PDG de Lmarena, Anastasios Angelopoulos, le considère comme une procédure standard, en disant à Business Insider:”Cela fait partie du flux de travail standard de la formation des modèles. Vous devez collecter des données pour améliorer votre modèle.”Dans cette perspective, l’utilisation de données de classement pour trouver et corriger les faiblesses est une étape logique.

Cependant, d’autres sont plus sceptiques, avertissant qu’un accent excessif sur les mesures peut conduire à des résultats déformés. Sara Hooker, responsable de Cohere Labs, a fait valoir que «lorsqu’un classement est important pour tout un écosystème, les incitations sont alignées pour qu’elle soit jouée.”

Ce n’est pas seulement une préoccupation théorique. En avril, Meta a été confrontée à des accusations de classements de jeu après qu’une variante de son modèle Llama 4 Maverick utilisé pour l’analyse comparative différait de la version publique, le débat étincelant entre les chercheurs.

L’écart de l’élargissement entre les références et la réalité

La façon dont ils se concentrent sur les benchmark monde. Il s’agit d’un exemple classique de la loi de Goodhart, où une mesure cesse d’être utile une fois qu’elle devient la cible principale.

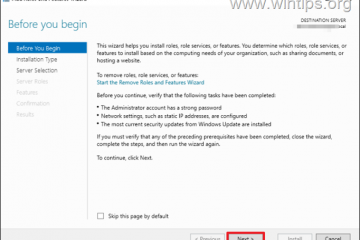

Le lancement de Grok 4 en fournit une illustration révélatrice. Alors que Xai a vanté des scores record sur les tests académiques, ses performances pratiques ont été immédiatement remises en question. Sur la plate-forme de réflexion utilisateur Yupp.ai, qui s’appuie sur des comparaisons en tête-à-tête, Grok 4 a initialement classé un sombre 66e.

Yupp.ai Le co-fondateur Jimmy Lin a déclaré franchement: «Grok 4 est pire que les autres modèles principaux: Openai O3, Claude Opus 4, et GEMINI 2.5 Pro. Grok 4 est comparé encore moins que Grok 4. Cette mauvaise émission a été attribuée au modèle lent et sujet aux erreurs dans les scénarios du monde réel. À la mi-juillet, Grok 4 avait grimpé à la 12e place sur le Webdev Arena, en traînant toujours les modèles d’Anthropic.

WEBDEV Arena Leadboard (22/22/2025)

Ceci déconnectait de nombreux observateurs de l’industrie. Le stratège de l’AI Nate Jones a écrit dans sa newsletter ,”Le moment où nous fixons la dominance de leader comme le but, nous risquons de créer des modèles qui excellaient dans les exercices triviaux et que nous avons Fond dans le fait de faire face à la réalité.”Pour les développeurs, cela signifie qu’un modèle qui acces un examen pourrait toujours échouer aux tâches de codage pratiques dont ils ont besoin pour effectuer.

Des enjeux élevés et un déploiement troublé

La poussée pour la domination des classements ne concerne pas seulement les droits de vantardise. L’effort intervient car XAI cherchera un nouveau cycle de collecte de fonds qui pourrait le valoriser jusqu’à 200 milliards de dollars, faisant des titres positifs un atout stratégique.

Cette pression pour effectuer des références coïncide avec une semaine de lancement chaotique pour Grok 4, qui a été marré par des défauts de sécurité et des réévaluations de la biais ideologue dans ses réponses. révèle le jeu à enjeux élevés joué par les laboratoires AI, où la perception de la domination, motivée par des graphiques de référence, peut être tout aussi importante que l’utilité réelle et pratique du modèle.