Un consortium de chercheurs d’université et d’Amazon a dévoilé une nouvelle architecture d’IA, The Energy Based Transformer (EBT). Il est conçu pour équiper des modèles avec plus de compétences analytiques de type humain. L’approche vise à inculquer la «pensée du système 2» dans l’IA, qui s’appuie souvent sur une reconnaissance rapide et intuitive de motifs.

Détaillé dans un Nouveau document de recherche , le modèle EBT traite la pensée comme un processus d’optimisation iTÉRATIVE. Il commence par une solution aléatoire et l’améliore progressivement pour minimiser un score «d’énergie» calculé. Alors que les premiers résultats suggèrent que les EBT pourraient être plus économes en matière de données, la méthode nécessite plus de calcul.

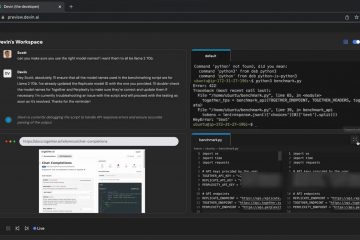

La question principale du projet, comme le pose les chercheurs, est:”Est-il possible de généraliser ces approches de réflexion du système 2 et de développer des modèles qui apprennent à penser uniquement à partir d’un apprentissage non surveillé?”Cela remet en question le paradigme actuel du développement de l’IA. Le travail est disponible sur un page de projet et github .

src=”data: image/svg + xml; nitro-empty-id=mty0mdoxmty4-1; base64, phn2zyb2awv3qm94psiwidagmti4mca0mj Eiihdpzhropsixmjgwiibozwlnahq9ijqymsigeg1sbnm9imh0dha6ly93d3cudzmub3jnlziwmdavc3znij48l3n2zz4=”>

de l’intuition à l’analyse: la quête de «Système 2» AI

L’architecture EBT représente un changement fondamental de la paradigme dominante de l’IA. La plupart des modèles actuels, y compris les transformateurs standard, excellent à ce que le Nobel Laureat Daniel Kahneman a qualifié de «réflexion système» qui permet de gérer le texte ou de reconnaître l’or ou le texte ou le texte de la pliance intutive, de modèle intuiti images presque instantanément.

Cependant, ces modèles vacillent souvent sur les tâches nécessitant une «réflexion du système 2»-le raisonnement plus lent, délibéré et analytique que les humains utilisent pour des problèmes complexes comme les mathématiques en plusieurs étapes ou les puzzles logiques. Le cadre EBT est une tentative directe de construire ce processus cognitif plus profond directement dans l’architecture du modèle.

En son cœur, l’EBT recadre la prédiction comme un puzzle d’optimisation. Un transformateur standard prend une entrée et génère une sortie dans un seul passage avant déterministe. En revanche, un EBT apprend un «paysage énergétique» complexe et haute dimension pour toutes les prédictions possibles liées à un contexte donné.

Au lieu de produire directement une réponse, le modèle commence par une supposition aléatoire et bruyante. Il utilise ensuite les principes de la descente de gradient pour affiner de manière itérative cette supposition, la «marcher» en descente sur le paysage de l’énergie savant jusqu’à ce qu’elle s’installe dans le point le plus bas possible, ou «Energy Valley».

Cet état d’énergie la plus basse représente la réponse la plus plausible et la plus cohérente contextuelle. Ce processus de raffinement itératif est au cœur du mécanisme de «pensée» de l’EBT. Il permet au modèle d’explorer un espace de solutions potentielles plutôt que d’être verrouillés dans un seul chemin.

Cette approche est conçue pour incarner trois facettes clés de la cognition souvent absentes dans des modèles standard. Le premier est l’allocation de calcul dynamique. Pour un problème simple, le modèle pourrait trouver l’énergie minimum en quelques étapes. Pour un complexe, cela peut prendre de nombreuses étapes, dépenser efficacement plus de «pensée» sur le problème.

La deuxième facette est la capacité de modéliser l’incertitude. Un paysage d’énergie lisse avec un minimum clair indique une certitude élevée. Un paysage accidenté avec de nombreuses vallées locales suggère que le modèle est incertain, car il existe plusieurs réponses plausibles. Cela fournit une compréhension plus nuancée de la propre confiance du modèle.

Troisièmement, l’architecture comprend un mécanisme intrinsèque pour la vérification de la prédiction. Le score d’énergie final d’une prédiction sert de contrôle de qualité intégré. Un score faible indique une réponse vérifiée de haute qualité, tandis qu’un score élevé signale un pauvre, le tout sans avoir besoin d’un modèle de vérificateur séparé.

En intégrant ces trois capacités, l’EBT vise à créer une forme de raisonnement plus robuste et généralisable. Il se déplace au-delà de la génération de modèles simples vers un processus de résolution de problèmes active et itérative, marquant une étape conceptuelle significative dans la quête d’une intelligence artificielle plus compétente.

Comment les transformateurs basés sur l’énergie «pensent»

Les chercheurs affirment que cette approche donne des avantages à l’échelle significative, en attribuant un principe de base: la vérification de la vérification d’une solution est souvent plus facile que de se produire. Alors qu’un transformateur standard doit apprendre le chemin direct vers une réponse, un EBT apprend à marquer la «correction» d’une réponse donnée-une tâche plus simple qui semble généraliser plus efficacement. Leur article rapporte que les EBT évoluent plus efficacement que la ligne de base Advanced Transformer ++, montrant jusqu’à un taux de mise à l’échelle de 35% plus élevé par rapport aux données.

L’efficacité améliorée des données est particulièrement remarquable. Cela suggère qu’à l’échelle, un EBT pourrait atteindre les mêmes performances qu’un transformateur standard tout en s’entraînant sur des données nettement moins. À une époque où l’industrie approche des limites des données de formation de haute qualité disponibles sur le Web, le développement de plus d’architectures économes en fonction des données est un objectif stratégique essentiel pour la progression continue de l’IA.

Une telle «pensée» se manifeste de deux manières clés pendant l’inférence. Premièrement, le modèle peut effectuer plus d’étapes de raffinement itérative sur une seule prédiction, ce qui consacre efficacement plus de calcul à un problème difficile. Deuxièmement, il peut générer plusieurs réponses candidates et utiliser sa fonction d’énergie interne pour s’auto-vérifier et sélectionner celle avec l’énergie la plus faible, indiquant la compatibilité la plus élevée. Cet boost de performance est le plus prononcé sur les tâches hors distribution (OOD)-des problèmes qui diffèrent des données de formation.

L’auteur principal Alexi Gladstone déclare que «les transformateurs à base d’énergie sont la première approche des transformateurs de l’alimentation hors de l’échelle à travers les modalités et en ce qui concerne plusieurs axes, notamment les données, la profondeur, les paramètres, les glissages, etc. En «pensant» plus longtemps à l’inférence, les EBT ont amélioré les performances des tâches linguistiques jusqu’à 29%. Cela suggère que le processus itératif leur permet de raisonner plus robustement dans de nouvelles situations où les modèles standard pourraient s’appuyer sur la correspondance des modèles erronés.

performances prometteuses, mais à un coût significatif

malgré les résultats prometteurs, l’architecture EBT fait face à un obstacle majeur: le coût de calcul. La formation de ces modèles nécessite actuellement entre 3,3 et 6,6 fois plus d’opérations à virgule flottante (flops) que les transformateurs standard. Cette surcharge substantielle n’est pas seulement une préoccupation théorique; Il représente un obstacle important à l’adoption, ce qui est potentiellement limitant la recherche et le développement EBT aux seuls laboratoires académiques et aux grandes sociétés technologiques les plus financées avec de vastes ressources informatiques.

Les besoins élevés du flop découlent directement du processus d’optimisation itératif au cœur de la conception de l’EBT. Contrairement à la réussite à avant d’un modèle standard, chaque étape de raffinement dans un EBT implique des calculs de gradient complexes pour déterminer la direction de la «pensée» suivante. Ce processus, qui nécessite du calcul des dérivés de second ordre (ou des approximations efficaces comme les produits de vecteur de Hesse), est fondamentalement plus intensive. L’équipe reconnaît qu’il s’agit d’un domaine clé pour les futurs travaux d’optimisation, car rendre ce processus de «pensée» moins cher est essentiel pour le déploiement pratique.

De plus, les expériences initiales ont été menées sur des modèles avec jusqu’à 800 millions de paramètres. Il s’agit d’une fraction de la taille des plus grands systèmes d’IA d’aujourd’hui, qui dépassent souvent des centaines de milliards de paramètres. La mise à l’échelle d’une architecture par ordres de grandeur est notoirement difficile, révélant souvent des défis imprévus comme la formation des instabilités ou des paysages énergétiques qui deviennent trop complexes pour naviguer efficacement. Par conséquent, il reste une question ouverte si les avantages de performance observés à cette petite échelle tiendront, voire amplifier, lorsqu’ils sont appliqués aux modèles frontaliers.

En fin de compte, l’EBT présente un compromis fondamental pour la communauté de l’IA: le potentiel d’un raisonnement plus robuste et humain d’une augmentation de plusieurs fois dans les coûts de formation et d’inférence? La réponse dépendra probablement de l’application. Pour les tâches scientifiques ou analytiques à enjeux élevés, le prix peut être justifié, mais pour une utilisation générale, l’analyse coûts-avantages reste un problème critique et non résolu.

La poussée plus large de l’industrie pour l’efficacité de l’IA

Le concept EBT arrive auprès d’une poussée plus large de l’industrie pour une plus grande efficacité de l’IA. Plusieurs entreprises relèvent ce défi sous différents angles, mettant en évidence le besoin critique de réduire les immenses coûts associés à une IA à grande échelle

Ces méthodes concurrentes s’attaquent à l’efficacité à différents stades. Compactifai de Multiverse comprime le modèle statique lui-même. Les NAMM de Sakana optimisent le cache KV dynamique pendant l’inférence. Le Bamba d’IBM utilise une architecture hybride pour accélérer le traitement des séquences.

En revanche, les EBT modifient fondamentalement le mécanisme de prédiction lui-même. Plutôt que d’optimiser simplement un modèle fini ou sa mémoire, les EBT intègrent un processus de «réflexion» directement dans la façon dont chaque prédiction est formée, visant une meilleure généralisation et un raisonnement à partir de zéro.

Par exemple, l’informatique multiples de startup espagnole se concentre sur la compression du modèle. Son PDG, Enrique Lizaso Olmos, a noté:”La sagesse dominante est que le rétrécissement des LLMS a un coût. Multiverse change cela.”Pendant ce temps, le modèle BAMBA d’IBM cible la vitesse d’inférence.

Le projet du projet d’IBM Raghu Ganti a expliqué la stratégie:”Tout revient à la réduction du cache KV… plus de débit, de latence plus faible, longueur de contexte plus longue.”D’autres innovations, comme le système d’optimisation de la mémoire de Sakana AI, visent également à rendre les transformateurs plus efficaces. Les chercheurs de Sakana ont constaté que «l’évolution surmonte intrinsèquement la non-différentivité de nos opérations de gestion de la mémoire, qui impliquent des résultats binaires« rappeler »ou« oublier ».»

Ces approches variées montrent un changement dans le développement de l’IA. À mesure que les modèles se développent, l’industrie se précipite pour trouver des moyens durables de les former et de les déployer. Les chercheurs de l’EBT croient que leur travail est un élément clé de cet avenir, concluant que «les EBT sont un nouveau paradigme prometteur pour étendre à la fois les capacités d’apprentissage et de réflexion des modèles».