Alors que les entreprises explorent des plans pour que les agents de l’IA prennent en charge des emplois complexes, visant même à automatiser des dizaines de milliers de rôles fédéraux, une dose de réalité provient des chercheurs de l’Université de Carnegie Mellon.

Leur référence détaillée, simulant une entreprise de logiciels entièrement dotée de l’AI, a constaté que les agents actuels luttent puissamment avec des tass professionnels réels. L’étude, surnommée “TheAgentCompany”, a trouvé que même le Top Performer a achevé moins d’un quart des tâches attribuées, des récits difficile suggérant que l’AI est sur la veille de l’automatisation de l’emploi. href=”https://arxiv.org/pdf/2412.14161″Target=”_ Blank”> Paper arxiv , placé des agents AI dans une simulation détaillée d’une petite entreprise de logiciels. Cet environnement comprenait des sites Web internes construits à l’aide de plates-formes open-source comme Gitlab (Hébergement de code), OwnCloud (bureau de bureau), l’avion (gestion de projet) et Rocketchat (communication interne), aux côtés d’un espace de travail local à sable avec un access terminal et codage. Target=”_ Blank”> OpenHands Framework d’agent (un système open source pour la construction d’agents qui peuvent faire fonctionner des applications informatiques), ont reçu 175 tâches couvrant l’ingénierie logicielle, la finance, les RH, la gestion de projet et les tâches administratives. Ces tâches ont été conçues sur la base des descriptions de travaux réelles de sources comme le o * Net Database Et l’expérience de l’autorité.

Évaluation des vérifications automatisées contre les points de contrôle pré-définis, le Crédit partiel attribuant, le Crédit partiel Award pour un intermédiaire, Parfois des vérifications automatisées pré-définies, Évaluation basée sur LLM pour des contrôles plus subjectifs. L’environnement a également présenté des collègues simulés-PNJ alimentés par le sonnet Claude 3.5 d’Anthropic via le Sotopia plateforme (un cadre pour créer des environnements sociaux simulés)-pour tester les capabilités d’interaction. Tromble sur les tâches de tous les jours

Les résultats peignent une image de capacité naissante, souvent maladroite. Le sonnet Claude 3.5 d’Anthropic a mené le pack mais n’a obtenu qu’un taux d’achèvement de la tâche complet de 24,0% (score partiel de 34,4%). Cette performance a eu lieu à des dépenses opérationnelles considérables, avec une moyenne de plus de 6 $ et près de 30 étapes d’interaction par tâche. Le flash Gemini 2.0 de Google était notamment moins cher (0,79 $/tâche) mais beaucoup plus lent (près de 40 étapes) et moins réussi (11,4%). Le GPT-4O d’OpenAI a enregistré un succès de 8,6% (1,29 $/tâche), tandis que Meta’s Open-Weight Llama 3.1 405B a atteint 7,4% (3,21 $/tâche). D’autres modèles, dont Nova Pro V1 d’Amazon (1,7%), ont traîné plus loin derrière. Ces faibles taux de réussite découlent d’une gamme de problèmes observés.

où les agents restent

L’analyse des échecs a souligné les limitations fondamentales des capacités des agents. Le bon sens de base semblait souvent absent; Les agents peuvent traiter un fichier «.docx» comme du texte brut ou, comme indiqué dans une source, s’avérer incapable de rejeter un «pop-up inoffensif» bloquant les fichiers nécessaires. Les compétences sociales étaient également faibles, les agents utilisant le système Rocketchat simulé mal interprétent mal les conversations ou ne faisant pas de suivi de manière appropriée.

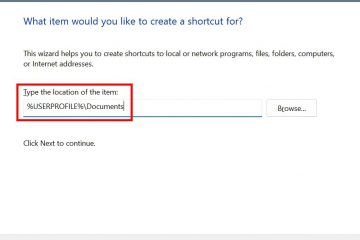

Les chercheurs ont documenté un cas où un agent, incapable de trouver le bon contact dans le système de chat, «décide de créer une solution de raccourci en renommant un autre utilisateur au nom de l’utilisateur prévu. La navigation sur les UIS Web complexes s’est avérée particulièrement difficile, en particulier dans l’environnement OwnCloud Office Suite. Les chercheurs ont largement identifié des points d’échec communs comme un manque de bon sens, de mauvaises compétences sociales et une incompétence dans la navigation sur le Web.

Les progrès inégaux entre les différents types de travail

Les performances n’étaient pas uniformes dans les catégories de tâches. Les agents se sont généralement mieux comportés avec les tâches d’ingénierie de développement logiciel (SDE) par rapport aux rôles dans l’administration, la finance ou la science des données, où les taux de réussite étaient souvent proches de zéro. Les chercheurs ont l’hypothèse que cette disparité pourrait découler de la grande quantité de code public disponible pour les modèles de formation sur les tâches SDE, tandis que les flux de travail pour les emplois administratifs ou financiers sont souvent propriétaires et moins représentés dans les données de formation.

La capacité d’interagir avec différentes plates-formes variait également. Les agents ont montré des difficultés particulières aux tâches impliquant la plate-forme de communication Rocketchat et la suite Office Office Owncloud, suggérant que le raisonnement social et la navigation sur l’interface utilisateur complexe restent des obstacles majeurs. Les performances sur les tâches impliquant le gitlab (hébergement de code) et le plan (gestion de projet) étaient relativement meilleures, bien que loin d’être fiables.

Une vérification de la réalité pour les ambitions d’automatisation

Ces résultats de référence donnent un contraste frappant aux attentes élevées et aux efforts de développement continu au sein de l’industrie technologique. Microsoft a commencé à prévisualiser les agents «d’utilisation de l’ordinateur» dans Copilot Studio en avril 2025, visant à automatiser les interactions de l’interface graphique. OpenAI explorera les agents de recherche de «doctorat» élevés pour l’automatisation des entreprises plus tôt en mars 2025.

Peut-être le plus étonnant, les plans liés à l’initiative Doge d’Elon Musk ont fait surface fin avril, impliquant le recrutement pour un projet visant à déploier des agents de l’IA capables de remplacer le travail équivalent de «au moins 70k ftes» dans une année. Cette proposition a été rencontrée avec un scepticisme interne au sein d’un réseau d’anciens élèves de Palantir, avec un critique rétorquant:”Vous êtes complice de licencier 70 000 employés fédéraux et de les remplacer par une correction automatique de merde.”Les résultats de la composition de TheAegenPany soulignent les questions de faisabilité entourant de tels plans d’automatisation à grande échelle.

Les luttes des agents dans la référence s’alignent avec les faiblesses connues inhérentes aux modèles actuels d’IA. Le directeur de la sécurité de l’information d’Anthropic a averti en avril 2025 que l’industrie n’est pas préparée aux défis de sécurité et de gestion posés par des «employés virtuels» autonomes, mettant en évidence des problèmes connus comme l’hallucination et la vulnérabilité de l’injection Politique d’entreprise inexistante fin avril 2025. Les chercheurs de Carnegie Mellon ont conclu que si les agents pouvaient accélérer des parties du travail humain, ils ne sont «probablement pas un remplacement pour toutes les tâches en ce moment.»

Ils ont fait des parallèles sur le marché des traductions humaines. Les entreprises expérimentant actuellement des agents, comme Johnson & Johnson, mettent l’accent sur le fait de garder les humains impliqués, considérant l’IA comme un outil de collaboration plutôt que de remplacer dans un avenir prévisible.