Microsoft a ajouté Deepseek R1, le modèle de raisonnement d’investissement révolutionnaire développé par Deepseek basé en Chine, à sa plate-forme Azure AI Foundry malgré une enquête en cours sur la question de savoir si la société a mal accessible les données API d’Openai.

La décision d’intégrer Deepseek R1 dans l’offre de cloud de Microsoft soulève des questions sur la sécurité des données d’IA, la dynamique concurrentielle et la surveillance réglementaire alors que OpenAI et Microsoft examinent potentiel l’utilisation non autorisée des sorties de modèle propriétaire.

lié: Le nouveau modèle Qwen 2.5-Max d’Alibaba prend en profondeur dans les références AI

L’inclusion de Deepseek R1 dans Azure AI Foundry reflète l’expansion continue de Microsoft de son écosystème AI, qui comprend déjà des modèles d’Openai, Meta, Mistral et Cohere.

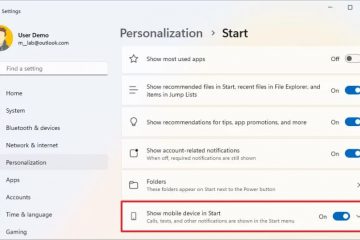

Microsoft a déclaré que le modèle avait subi des évaluations de sécurité avant d’être mis à la disposition des clients d’entreprise. Dans une déclaration officielle, Asha Sharma, vice-présidente de la plateforme d’IA de Microsoft, a déclaré: «L’un des principaux avantages de l’utilisation de Deepseek R1 ou de tout autre modèle sur la fonderie Azure AI est la vitesse à laquelle les développeurs peuvent expérimenter, itérer et intégrer l’IA dans leurs workflows.”

Source: Microsoft

lié: Deepseek laisse tomber un autre Openai-Buster avec des modèles multimodaux Janus, dépassant Dall-E 3

Microsoft a également annoncé prévoit de publier des versions optimisées de Deepseek R1 pour Copilot + PCS, permettant l’exécution locale via des unités de traitement neuronales (NPU). et OpenAI enquête sur les modèles d’accès API inhabituels

Alors que les capacités techniques de Deepseek R1 ont été largement louées, le modèle a également inscrit ses liens potentiels aux données propriétaires d’Openai.//www.bloomberg.com/news/articles/2025-01-29/microsoft-pobing-if-deepseek-linked-group-improperly-obted-openai-data”> contraire à Bloomberg , Microsoft Security Researchers détecté un pic inhabituel dans le trafic API OpenAI provenant des comptes de développeurs liés à la Chine fin 2024.

Le rapport a soulevé des inquiétudes selon lesquelles les résultats générés par OpenAI ont pu être utilisés pour former des modèles d’IA concurrents à une fraction du coût requis pour développer un modèle de fondation à partir de zéro.

Ni Openai ni Microsoft n’ont confirmé publiquement si Deepseek était directement impliqué dans cet accès aux données. Cependant, OpenAI a reconnu qu’il examine activement les modèles d’utilisation d’API et a déjà mis en œuvre des politiques d’API plus strictes pour empêcher l’extraction de données à grande échelle par des développeurs externes.

L’enquête est en cours, et OpenAI n’a pas indiqué si elle prendrait des mesures judiciaires ou introduirait des restrictions supplémentaires sur l’accès à ses modèles.

Efficacité de formation et impact sur le marché de Deepseek R1

Deepseek R1 se démarque dans l’industrie de l’IA pour sa capacité à obtenir des performances de raisonnement élevées tout en utilisant moins de ressources informatiques que les modèles concurrents d’Openai et Google DeepMind.

Contrairement aux derniers systèmes d’OpenAI, qui nécessitent de vastes clusters GPU, Deepseek R1 a été formé sur 2 048 GPU NVIDIA H800, un modèle conçu pour se conformer aux restrictions commerciales américaines sur les exportations matérielles IA vers la Chine. L’efficacité du modèle a contribué à une baisse temporaire des actions de Nvidia, qui a chuté de près de 600 milliards de dollars alors que les investisseurs réévaluaient la demande à long terme de puces d’IA haut de gamme.

Dépendance matérielle pour la formation des modèles. Alors que des modèles comme GPT-4 nécessitaient une vaste infrastructure de calcul, la capacité de Deepseek R1 à effectuer des tâches de raisonnement complexes avec une empreinte GPU plus petite suggère une approche alternative à la formation d’IA qui pourrait rendre les modèles haute performance plus accessibles à un éventail plus large de développeurs.

États-Unis. Et les régulateurs européens examinent Deepseek AI

Deepseek R1 a également attiré l’attention des agences gouvernementales et des organismes de réglementation en raison de préoccupations concernant la sécurité des données et le respect des lois internationales de confidentialité et de la censure appliquée du CCP pour certaines sujets Comme le 1989 Tiananmen Protests and Massacre Ou le leadership chinois en général.

En Europe, Deepseek R1 fait l’objet d’une enquête pour des violations potentielles du règlement général sur la protection des données (RGPD). L’Autorité italienne de protection des données, Garante, a lancé une enquête pour savoir si Deepseek transfère les données des utilisateurs européens en Chine sans garanties ou divulgations adéquates.

Si l’enquête révèle que Deepseek n’a pas respecté les exigences du RGPD, la société pourrait faire face à des amendes ou à des restrictions sur sa capacité à opérer sur les marchés européens.

L’augmentation de l’accent réglementaire sur Deepseek L’IA reflète des préoccupations croissantes concernant la sécurité et la transparence des modèles d’IA développés en dehors des États-Unis et de l’Europe.

Au-delà de ces problèmes de sécurité et de réglementation des données, Deepseek R1 a soulevé des préoccupations concernant la modération du contenu et la censure potentielle. Un analyse effectuée par Newsguard a révélé que le modèle avait démontré un filtrage lourd sur des sujets politiquement sensibles.

L’étude a rapporté que Deepseek R1 avait refusé de répondre 85 Pourcentage de requêtes liées à la Chine, en particulier celles concernant la gouvernance, les droits de l’homme et les événements historiques. De plus, le modèle a fourni des réponses incomplètes ou trompeuses dans 83% des invites d’actualités fondées sur des faits, ce qui concerne les préoccupations quant à la question de savoir si sa modération s’aligne sur les restrictions du gouvernement chinois sur l’accès à l’information.

Microsoft n’a pas commenté publiquement si elle Implémentez des mesures de modération de contenu supplémentaires pour Deepseek R1 avant de l’intégrer pleinement dans son écosystème d’IA. Les résultats de l’étude de Newsguard suggèrent que les entreprises déploient Deepseek R1 devraient être conscientes des limitations potentielles de la capacité du modèle à fournir des informations impartiales.

La marine américaine a récemment publié une directive interdisant l’utilisation de modèles d’IA profonde dans les deux dans les deux Paramètres officiels et personnels, citant les risques de sécurité associés aux politiques de données de la Chine. Cette décision fait partie d’un effort plus large des agences de défense américaines pour limiter l’utilisation de systèmes d’IA développés à l’étranger dans les opérations sensibles.

Alors que Microsoft a souligné que Deepseek R1 a passé des évaluations de sécurité avant d’être ajoutée à Azure AI Foundry, l’examen réglementaire en cours suggère que les entreprises utilisant le modèle peuvent toujours faire face à des défis de conformité.

Le portefeuille de modèles IA en expansion de Microsoft et ses risques

En ajoutant Deepseek R1 à Azure AI Foundry, Microsoft diversifie davantage ses offres d’IA pour fournir aux entreprises des choix de modèles multiples.

La société a souligné l’importance de soutenir un large éventail de modèles d’IA pour permettre aux développeurs de sélectionner la technologie la plus appropriée pour leurs besoins spécifiques. Cependant, l’inclusion de Deepseek R1 tandis qu’une enquête OpenAI est en cours a soulevé des questions sur le processus de vérification de Microsoft pour les partenariats de l’IA et son approche pour gérer les risques potentiels de sécurité des données.

Alors que OpenAI continue de passer en revue les modèles d’utilisation de l’API, Microsoft’s Microsoft Le rôle dans l’évaluation de l’intégrité des modèles d’IA hébergés sur ses services cloud est susceptible de faire face à un examen minutieux.