Des chercheurs de Google ont introduit un nouveau framework appelé Chain-of-Agents (CoA), conçu pour répondre à l’une des limitations les plus persistantes des grands modèles de langage (LLM) : la gestion des tâches à contexte long.

CoA utilise un modèle de collaboration multi-agents pour améliorer considérablement l’efficacité et la précision du raisonnement dans des tâches telles que la synthèse, la réponse aux questions et la complétion du code.

En divisant les entrées longues en entrées plus petites et gérables. morceaux et en les attribuant à des agents spécialisés, le cadre fournit de meilleurs résultats que les approches traditionnelles telles que la génération de récupération augmentée (RAG) et les modèles à contexte complet.

Connexe : Google dévoile Agentspace pour défier l’écosystème croissant de l’IA de Microsoft

Le Le cadre CoA offre un changement de paradigme pour l’IA, en particulier dans sa capacité à traiter des entrées étendues qui autrement dépasseraient les limites des LLM. Google a souligné la simplicité et l’efficacité de l’approche, la décrivant comme « sans formation, indépendante de la tâche et de la durée, interprétable et rentable ».

Les défis des tâches d’IA à contexte long

L’un des principaux obstacles à l’avancement des capacités de l’IA réside dans la gestion des entrées à contexte long. La plupart des LLM fonctionnent avec une fenêtre de contexte fixe qui limite leur capacité à traiter de grands ensembles de données sans troncature.

Les méthodes de réduction des entrées, telles que RAG, tentent de surmonter ce problème en récupérant uniquement les parties les plus pertinentes de l’entrée. Cependant, cette approche souffre souvent d’une faible précision de récupération, ce qui conduit à des informations incomplètes. strong>Connexe : NVIDIA fait progresser l’IA agentique avec les modèles Llama et Cosmos Nemotron

D’un autre côté, les modèles à contexte complet étendent leur capacité de traitement mais sont confrontés à des inefficacités de calcul, en particulier en ce qui concerne les entrées. la longueur augmente. Ces modèles rencontrent souvent le problème de la « perte au milieu », où les informations critiques au milieu de l’ensemble de données sont dépriorisées.

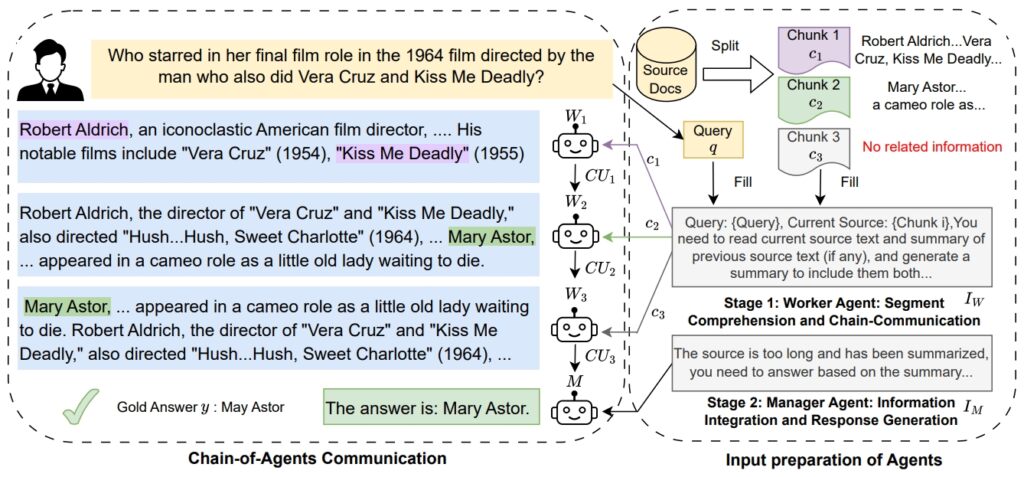

Le cadre CoA de Google résout ces problèmes en tirant parti d’un système collaboratif dans lequel les agents de travail traitent des segments spécifiques de l’entrée de manière séquentielle. Chaque agent travailleur affine et transfère ses découvertes au suivant, garantissant qu’aucun contexte n’est perdu.

Un agent gestionnaire synthétise ensuite toutes les informations recueillies pour produire une réponse finale. Cette approche par étapes imite la résolution humaine de problèmes, où les tâches sont divisées en parties plus petites pour une meilleure concentration et précision.

Image : Google

Image : Google

Les chercheurs de Google ont souligné la motivation derrière le cadre, déclarant: « Lorsque la fenêtre devient plus longue que leurs capacités de saisie étendues, ces LLM ont toujours du mal à se concentrer sur les informations nécessaires pour résoudre la tâche et souffrent d’une utilisation inefficace du contexte telle que le problème de la « perte au milieu ».”

Comment fonctionne la chaîne d’agents

Le cadre de chaîne d’agents fonctionne en deux étapes distinctes. Dans la première étape, les agents de travail traitent des morceaux d’entrée attribués, effectuant des tâches telles que l’extraction

Cette chaîne de communication garantit que chaque travailleur s’appuie sur les informations du précédent. Dans la deuxième étape, l’agent gestionnaire regroupe toutes les preuves collectées et génère un résultat final cohérent.. Cette structure hiérarchique améliore non seulement la précision du raisonnement, mais réduit également les coûts de calcul.

Connexe : Salesforce dévoile Agentforce 2.0, étendant les agents IA au-delà du CRM

Google a expliqué le La conception du framework consiste à « entrelacer la lecture et le raisonnement, en attribuant à chaque agent un contexte court. » Cette approche permet à CoA de gérer des contextes longs sans exiger que les LLM traitent tous les jetons simultanément.

Par réduisant la complexité de calcul, CoA offre une solution plus efficace et évolutive pour les tâches à contexte long.

Performances supérieures selon les benchmarks

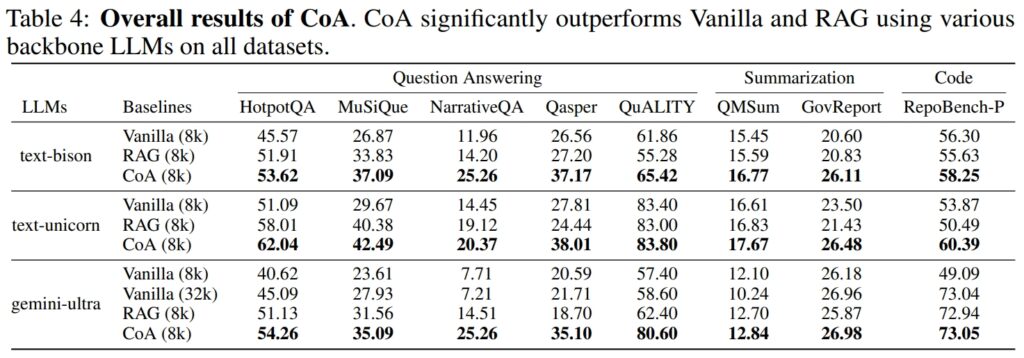

Google a mené des expériences approfondies sur neuf ensembles de données pour évaluer les performances de CoA. Ces ensembles de données couvraient divers domaines, notamment la réponse aux questions (par exemple, HotpotQA, MuSiQue), la synthèse (par exemple, QMSum, GovReport) et complétion de code (par exemple, RepoBench-P

CoA a systématiquement surpassé les modèles RAG et Full-Context en termes de précision et d’efficacité.

Source : Google

Source : Google

Par exemple, sur l’ensemble de données HotpotQA, CoA excellait dans le raisonnement multi-sauts, une tâche qui nécessite de synthétiser des informations provenant de plusieurs sources pour arriver à une réponse précise.

Alors que RAG ne parvenait souvent pas à relier des informations sémantiquement disjointes mais contextuellement pertinentes, CoA a systématiquement rassemblé les informations de chaque bloc d’entrée. Google a noté :”Nos résultats montrent que sur les neuf ensembles de données, CoA obtient une amélioration par rapport à toutes les lignes de base jusqu’à 10 %.”

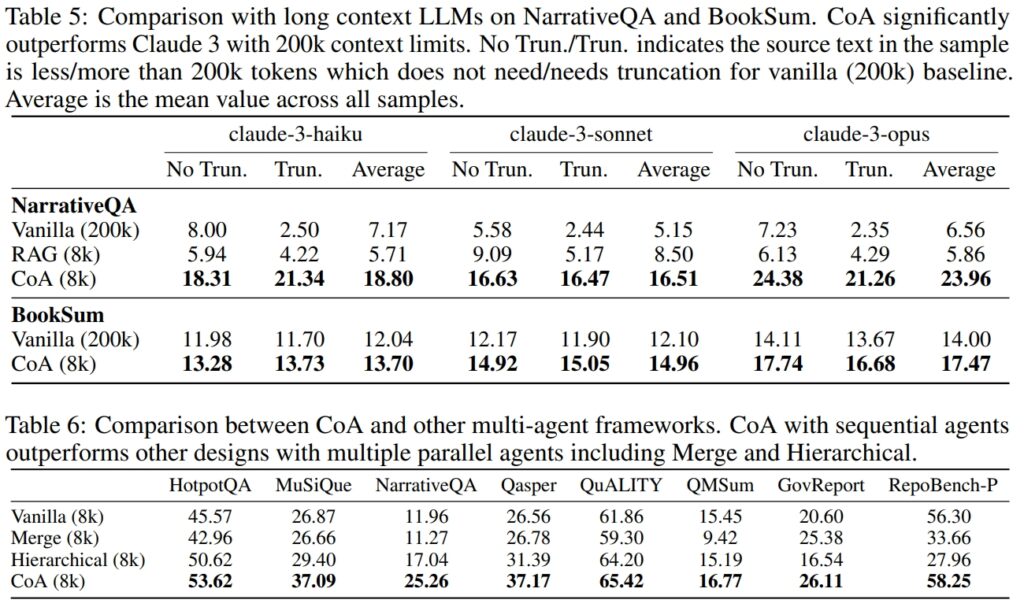

Sur l’ensemble de données NarrativeQA, CoA a démontré sa capacité à surpasser les modèles à contexte complet, même ceux capables de gérer 200 000 jetons. En limitant la fenêtre contextuelle à 8 000 jetons et en utilisant son approche multi-agents, CoA a maintenu des performances élevées tout en réduisant considérablement les coûts de calcul.

Source : Google

Source : Google

Applications dans des scénarios réels

Les Les applications de CoA s’étendent à plusieurs secteurs. Dans l’analyse juridique, CoA peut traiter de nombreux documents juridiques et identifier des informations critiques sans manquer de détails clés. Dans le domaine des soins de santé, le cadre pourrait regrouper les dossiers des patients provenant de diverses sources pour fournir des informations diagnostiques complètes.

Les institutions universitaires et gouvernementales pourraient utiliser CoA pour résumer la recherche, en synthétisant les résultats de grands ensembles de données.

La capacité de CoA à gérer les tâches de complétion de code met également en évidence son potentiel dans le développement de logiciels. En analysant de grandes bases de code et en identifiant les dépendances, le framework peut optimiser les flux de travail pour les développeurs travaillant avec des systèmes complexes.

Connexe : Cognition.ai déploie son ingénieur logiciel Devin AI pour 500 $/mois.

Comparaisons avec les concurrents du secteur

L’introduction de CoA par Google reflète l’accent croissant mis sur les agents d’IA uniques et les cadres d’agents d’IA collaboratifs au sein de l’industrie technologique. OpenAI vient de lancer Operator, un agent d’IA basé sur un navigateur conçu pour l’automatisation des tâches, tandis que Microsoft a dévoilé AutoGen v0.4 avec le framework Magentic-One pour les flux de travail multi-agents.

Le CoA de Google se distingue en se concentrant spécifiquement sur le raisonnement à contexte long et le traitement des tâches.

Selon les chercheurs de Google, les LLM reçoivent souvent un contexte incomplet en raison des limitations des méthodes traditionnelles, mais le CoA résout ce problème en traitant l’intégralité des entrées de manière collaborative via plusieurs agents.

Cette concentration sur les tâches à contexte long donne à CoA un avantage unique dans les domaines nécessitant une synthèse d’informations approfondie.

Un aperçu Vers l’avenir de l’IA

L’introduction de CoA met en évidence une tendance plus large dans le développement de l’IA vers des systèmes modulaires et collaboratifs. En permettant à des agents spécialisés de travailler ensemble, CoA démontre comment la division des tâches peut améliorer la précision et l’évolutivité.

Ce cadre pourrait ouvrir la voie aux progrès de l’intelligence artificielle générale (AGI), où les systèmes sont capables de raisonner et de résoudre des problèmes au niveau humain.

Les efforts de Google soulignent également l’importance de solutions rentables et interprétables pour l’IA d’entreprise.