Microsoft a intenté une action en justice fédérale contre un groupe non identifié de cybercriminels accusés d’avoir utilisé des clés API volées pour contourner les protocoles de sécurité de son service Azure OpenAI.

Selon la plainte déposé auprès du tribunal de district américain du district oriental de Virginie, le groupe, appelé Does 1-10, aurait développé et distribué des outils pour exploiter Les systèmes de Microsoft et génèrent du contenu préjudiciable en violation de ses politiques.

Les réclamations légales incluent des violations de la fraude et abus informatiques. (CFAA), la Digital Millennium Copyright Act (DMCA) et la Loi sur les organisations influencées par les racketteurs et corrompues (RICO).

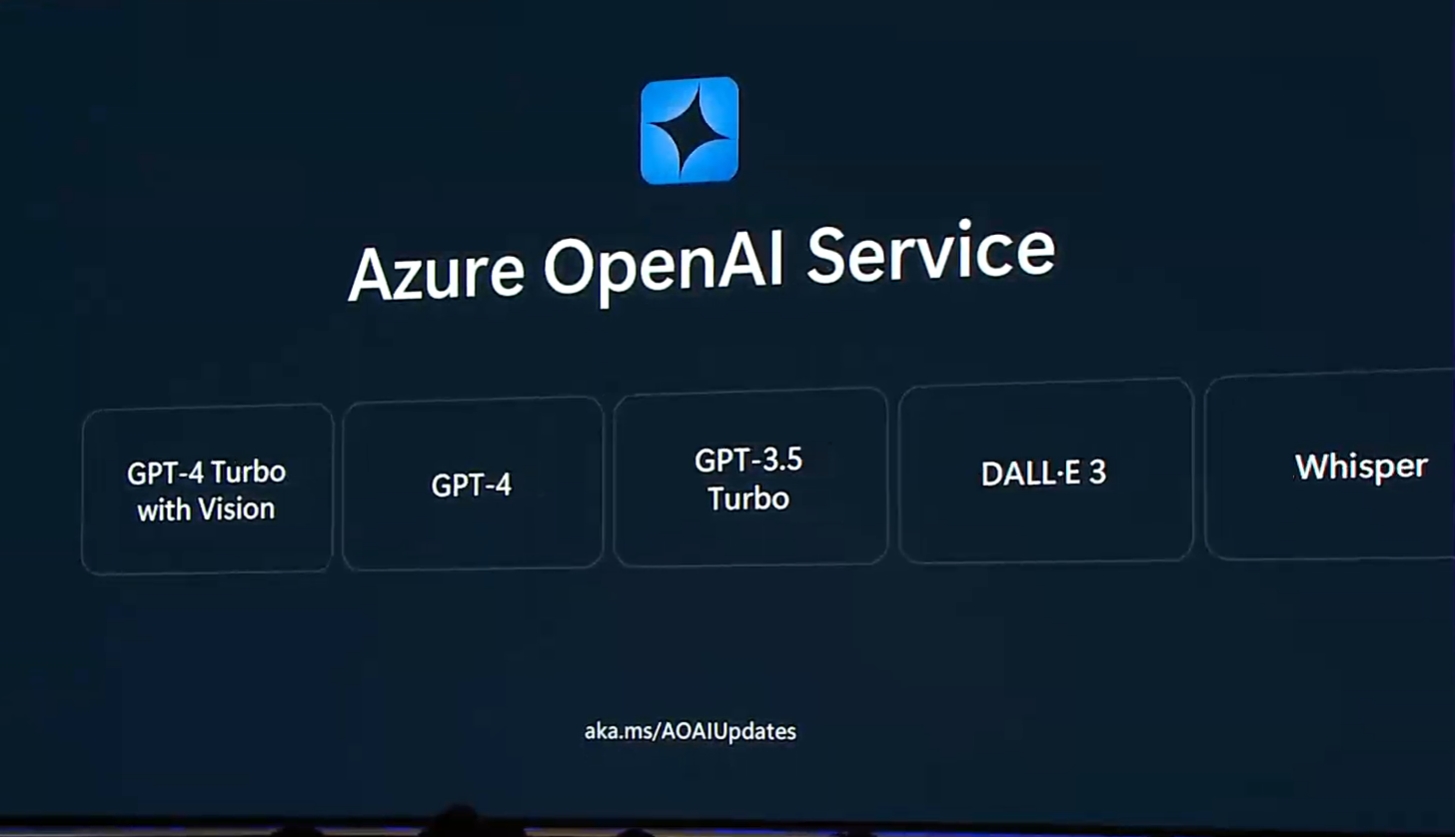

Le géant de la technologie allègue que le groupe a exploité un système de piratage sophistiqué, monétiser les accès non autorisés à Azure OpenAI Service en distribuant des logiciels personnalisés, notamment une application côté client connue sous le nom de « de3u » et un système de proxy inverse nommé « oai reverse proxy ».

Ces outils ont permis aux utilisateurs d’exploiter les informations d’identification volées et de contourner les mesures de sécurité avancées de Microsoft.

Connexe : Microsoft coupe l’accès à Azure OpenAI pour les développeurs chinois

L’enquête de Microsoft a débuté en juillet 2024 lorsqu’elle a découvert que des clés API (des identifiants uniques authentifiant les demandes des utilisateurs) émises aux clients légitimes d’Azure OpenAI étaient utilisées pour accéder à ses systèmes sans autorisation.

La société a attribué l’activité à une opération coordonnée ciblant plusieurs clients, dont plusieurs sociétés basées aux États-Unis.

“La manière précise dont les accusés ont obtenu toutes les clés API utilisées pour transporter”L’inconduite décrite dans cette plainte est inconnue”, a déclaré Microsoft dans son dossier,”mais il semble que les défendeurs se soient livrés à un vol systématique de clés API qui leur a permis de voler les clés API Microsoft de plusieurs clients Microsoft.”

Connexe : Les cyberattaques basées sur l’IA atteignent plus de 600 millions d’incidents quotidiens

Outils utilisés dans le cadre de ce programme

Le les accusés auraient créé le logiciel de3u pour faciliter l’utilisation non autorisée d’Azure OpenAI Service. Cet outil a fourni une interface conviviale pour générer des images via le modèle DALL-E d’OpenAI.

Il communiquait avec les systèmes Azure en imitant les requêtes API légitimes, en exploitant les informations d’identification volées pour contourner les protections intégrées. Le système de proxy inverse a en outre permis cet abus en redirigeant le trafic non autorisé via les tunnels Cloudflare, ce qui a masqué les activités et les a rendues plus difficiles à détecter.

La plainte de Microsoft décrit les outils en détail :”L’application de3u des accusés communique avec Azure des ordinateurs utilisant des API réseau Microsoft non documentées pour envoyer des requêtes conçues pour imiter les requêtes légitimes de l’API Azure OpenAI Service. Le système de proxy inverse oai a permis aux utilisateurs d’acheminer les communications via les tunnels Cloudflare vers les systèmes Azure et de recevoir des sorties contournant les restrictions de sécurité.”

Les outils comprenaient également des fonctionnalités permettant de supprimer les métadonnées du contenu généré par l’IA, empêchant ainsi l’identification des ses origines et permettant ainsi une utilisation abusive

Suite à la découverte de Microsoft, les accusés auraient tenté de supprimer des infrastructures clés, notamment les pages Rentry.org, le référentiel GitHub pour de3u et des éléments du proxy inverse. système.

Contexte plus large et implications à l’échelle de l’industrie

Le procès intervient à un moment où les technologies d’IA générative font l’objet d’une surveillance accrue en raison de leur utilisation abusive potentielle. comme DALL-E et ChatGPT d’OpenAI ont transformé la création de contenu, mais ont également été exploités à des fins de désinformation, de développement de logiciels malveillants et d’images nuisibles.

L’action en justice de Microsoft souligne les défis actuels auxquels sont confrontés les fournisseurs d’IA. dans la protection de leurs systèmes.

Microsoft a souligné que les mesures de sécurité intégrées dans Azure OpenAI Service sont robustes, utilisant des modèles de classification neuronale multi-classes et des protections de métadonnées. Ces systèmes sont conçus pour bloquer les contenus nuisibles et retracer les résultats générés par l’IA jusqu’à leurs sources.

Cependant, comme le démontre cette affaire, même les garanties les plus avancées peuvent être contournées par des acteurs déterminés.”Malgré les diverses mesures de sécurité prises par Microsoft et OpenAI, des acteurs malveillants sophistiqués ont conçu des moyens d’obtenir un accès illégal aux systèmes de Microsoft”, note la plainte.

Le groupe ciblé par Microsoft n’est peut-être pas isolé dans ses activités. L’entreprise allègue que les mêmes acteurs ont probablement exploité d’autres fournisseurs de services d’IA, ce qui reflète une tendance plus large aux abus dans le domaine de l’IA. Cela met en évidence les vulnérabilités systémiques des technologies d’IA générative et la nécessité d’une collaboration à l’échelle de l’industrie pour y remédier. menaces.

Actions juridiques et contre-mesures

Pour lutter contre l’exploitation, Microsoft a invalidé toutes les informations d’identification volées et mis en œuvre des mesures de sécurité supplémentaires pour empêcher des violations similaires. a également obtenu une ordonnance du tribunal pour saisir les domaines associés aux accusés, notamment « aitism.net », qui était au cœur de leurs opérations.

Ces mesures permettent à l’unité des crimes numériques de Microsoft de rediriger les communications de ces domaines vers des environnements contrôlés pour une enquête plus approfondie.

La plainte souligne également l’intention de Microsoft de demander des dommages-intérêts et une injonction pour démanteler les défendeurs.’infrastructures. En intentant une action en justice, l’entreprise vise à créer un précédent en matière de lutte contre l’utilisation abusive des technologies d’IA et de responsabilisation des acteurs malveillants.

Implications pour l’avenir de la sécurité de l’IA

Cette affaire illustre la sophistication croissante des cybercriminels exploitant les systèmes d’IA. À mesure que l’IA générative est de plus en plus intégrée aux applications commerciales et grand public, les risques d’utilisation abusive augmentent. Cet incident met en évidence l’importance d’un investissement continu dans les technologies de sécurité et la nécessité de cadres juridiques pour faire face aux menaces émergentes.

En poursuivant ce procès, Microsoft non seulement s’attaque aux vulnérabilités immédiates, mais renforce également son engagement en faveur du développement responsable de l’IA.