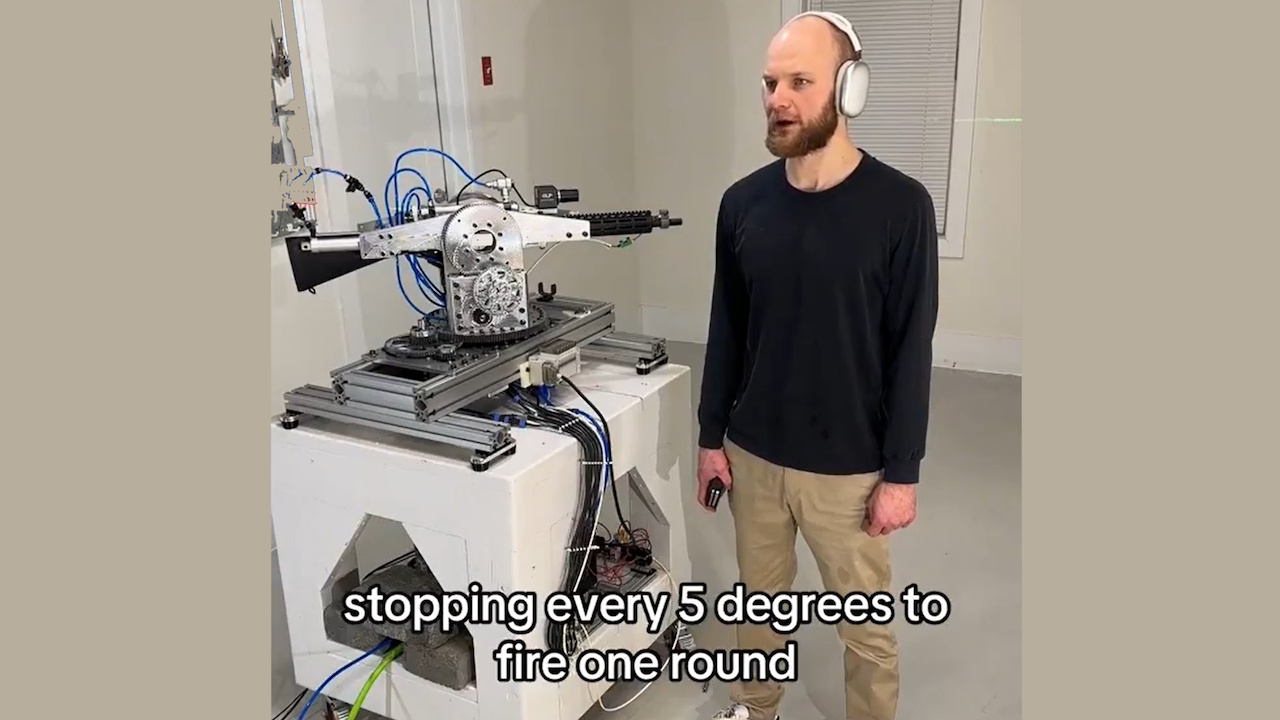

OpenAI a révoqué l’accès à l’API à un développeur qui utilisait son API en temps réel pour alimenter un système de fusil autonome. Le projet, qui impliquait une tourelle robotique équipée d’un fusil, pouvait interpréter des commandes verbales et exécuter des actions de tir simulées.

L’incident souligne les inquiétudes croissantes concernant l’utilisation abusive potentielle de l’intelligence artificielle dans le développement d’armes autonomes, soulevant des questions sur l’éthique et la sécurité de l’IA.

Le développeur, connu en ligne sous le nom de « STS Innovations LLC » a partagé des vidéos du système en ligne, démontrant ses fonctionnalités. Dans un clip, le développeur a émis la commande :”ChatGPT, nous sommes sous attaque de l’avant gauche et avant droit”, ce à quoi la tourelle a immédiatement répondu, tournant et tirant à blanc dans des directions spécifiées.

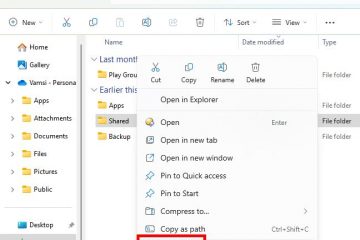

Simulation de visée/tir avec laser #robotics #électronique

A une voix synthétisée a ajouté :”Si vous avez besoin d’aide supplémentaire, faites-le-moi savoir.”La démonstration effrayante a montré comment les outils d’IA grand public peuvent être facilement adaptés à des utilisations potentiellement dangereuses.

Mise à jour sur le système de suivi #robotique #vision #électronique

Application rapide des politiques d’OpenAI

OpenAI, connue pour ses politiques strictes contre l’utilisation de sa technologie dans militarisation, a répondu rapidement. Un porte-parole a déclaré à Futurism :”Nous avons identifié de manière proactive cette violation de nos politiques et avons informé le développeur de cesser cette activité avant de recevoir votre demande.”

La société a souligné son interdiction d’utiliser ses outils pour créer ou utiliser des armes ou automatiser des systèmes qui pourraient présenter des risques pour la sécurité personnelle.

Système de gestion du recul, démo rapide #robotics #électronique #cnc

L’API Realtime, un outil conçu pour applications interactives, ont permis au développeur de transformer les commandes en langage naturel en entrées exploitables pour la tourelle robotique.

Bien que l’API soit destinée à des cas d’utilisation bénéfiques, tels que l’amélioration de l’accessibilité ou l’amélioration des interactions avec les clients, cette utilisation abusive démontre les défis de la réglementation des technologies à double usage.

Connexe : Partenariat OpenAI et Anduril Forge pour la défense des drones militaires américains

Implications plus larges pour l’IA et la militarisation

Cette affaire a relancé les débats sur l’éthique de armes autonomes. Ces systèmes, capables de sélectionner et d’engager des cibles sans surveillance humaine, posent des défis juridiques et moraux complexes.

Les Nations Unies plaident depuis longtemps en faveur d’une réglementation plus stricte sur l’IA en temps de guerre, avertissant que les systèmes autonomes pourraient violer les lois internationales et diminuer la responsabilité.

Connexe : Anthropic S’associe à Palantir, AWS pour l’IA dans le renseignement et l’armée américaine

Un rapport récent du Washington Post a détaillé des exemples troublants de déploiement de l’IA dans l’armée opérations, y compris des affirmations selon lesquelles Israël aurait utilisé l’IA pour sélectionner des cibles de bombardement.

Le rapport notait : « À certains moments, la seule corroboration requise était que la cible était un homme. » De tels cas mettent en évidence les risques liés au recours à l’IA pour des décisions de vie ou de mort et le potentiel d’attaques aveugles. violence.

Connexe : Green Beret a utilisé ChatGPT pour l’explosion d’un cybertruck, la police publie des journaux de discussion

Le rôle d’OpenAI dans la défense Technologies

Alors qu’OpenAI applique des politiques interdisant la militarisation, son partenariat avec Anduril Industries, une société spécialisée dans les solutions de défense basées sur l’IA, soulève des questions sur sa position.

La collaboration. vise à renforcer le renseignement sur le champ de bataille et à améliorer les systèmes de défense des drones. OpenAI décrit ces efforts comme défensifs, mais les critiques affirment qu’ils contribuent à une militarisation plus large des technologies d’IA.

Le secteur de la défense américain, soutenu par un budget annuel proche. 1 000 milliards de dollars, s’appuie de plus en plus sur des technologies avancées pour obtenir un avantage stratégique. Cette intersection croissante entre les entreprises d’IA et les applications militaires met en évidence les défis liés à l’équilibre entre l’innovation technologique et les considérations éthiques.

Connexe : Nouveau consortium d’IA Palantir-Anduril pour combler les lacunes des données de défense des États-Unis

Risques liés à la militarisation et à l’accessibilité

La facilité avec laquelle les individus peuvent abuser des outils d’IA et d’autres technologies comme si l’impression 3D aggrave le problème. Les forces de l’ordre ont déjà rencontré des cas de militarisation DIY, comme les actions présumées de Luigi Mangione, qui aurait utilisé des pièces imprimées en 3D pour assembler des armes à feu. Ces technologies réduisent les obstacles qui empêchent les individus de créer des systèmes autonomes dotés d’un potentiel mortel.

Le projet de STS 3D démontre comment les outils d’IA accessibles peuvent être adaptés à des fins imprévues. L’action décisive d’OpenAI dans ce cas montre son engagement à prévenir les abus, mais elle souligne également la difficulté de contrôler pleinement la manière dont ses technologies sont déployées une fois qu’elles entrent dans le domaine public.

L’incident soulève des questions plus larges sur la gouvernance de Technologies d’IA. Les partisans de la réglementation soulignent la nécessité de normes mondiales claires pour garantir que le développement de l’IA est conforme aux principes éthiques. Cependant, parvenir à un consensus entre des nations ayant des intérêts et des priorités divergents reste une tâche ardue.