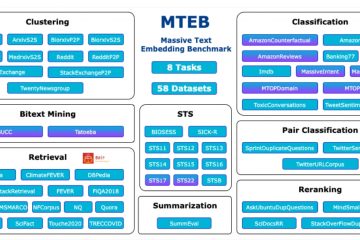

Des chercheurs de Microsoft et de l’Université de Beihang ont introduit MoRA, une nouvelle technique conçue pour affiner grands modèles de langage (LLM) avec une plus grande efficacité et des coûts réduits.

Contrairement aux Parameter-Efficient Fine-Tuning (PEFT), MoRA se concentre sur l’ajustement d’un sous-ensemble optimal de paramètres, permettant au modèle d’apprendre de nouvelles informations sans remanier l’ensemble de son ensemble de paramètres. Cette méthode rationalise le processus d’adaptation des LLM à des tâches spécifiques tout en réduisant considérablement les ressources nécessaires au réglage fin.

Défis liés aux méthodes traditionnelles

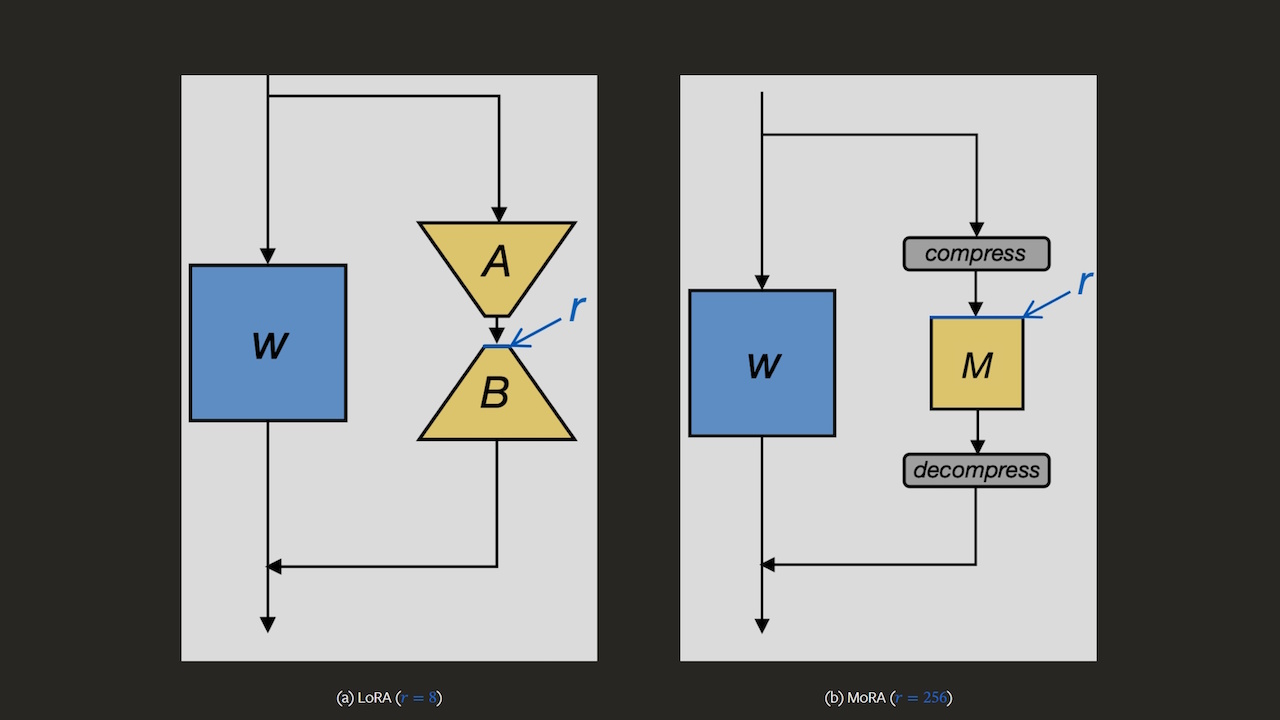

Traditionnelles Méthodes PEFT, telles que Low-Rank Adaptation (LoRA) ont été largement adoptés en raison de leurs faibles besoins en mémoire et de leur facilité de stockage et de déploiement de modèles affinés. Cependant, ces méthodes sont confrontées à des limites lorsqu’elles traitent des tâches complexes qui nécessitent une expansion approfondie des connaissances, telles qu’un raisonnement mathématique avancé et une pré-formation continue dans divers domaines. Les chercheurs ont identifié que le mécanisme de mise à jour de bas rang de LoRA a du mal à assimiler et à stocker efficacement les nouvelles informations en raison de la taille limitée du rang de son adaptateur par rapport au modèle complet.

Différences structurelles de MoRA

MoRA se distingue en utilisant une matrice carrée pour réglage des paramètres, par opposition aux matrices de bas rang utilisées par LoRA. Ce changement structurel permet à MoRA d’atteindre un rang plus élevé dans les dimensions originales du modèle, améliorant ainsi sa capacité à intégrer de nouvelles connaissances plus efficacement que LoRA ou des modèles de taille similaire. Pour intégrer ce nouveau système dans les cadres LLM existants sans perturber leurs paramètres opérationnels, l’équipe a développé une fonction de compression-décompression unique qui facilite des transitions fluides entre les espaces de modèle modifiés et originaux.

L’efficacité pratique de MoRA a été évaluée à travers une série d’analyses comparatives par rapport à des adaptations LoRA de taille égale. Les résultats ont démontré les performances supérieures de MoRA dans les tâches de mémorisation et son efficacité comparable dans le réglage des instructions et le raisonnement mathématique. Dans les domaines nécessitant une formation préalable continue, tels que les secteurs biomédical et financier, la capacité accrue du MoRA en matière de mise à jour de haut niveau s’est avérée particulièrement bénéfique, surpassant systématiquement les modèles LoRA.

Implications pour les entreprises et les développeurs

Avec l’introduction de MoRA, l’approche du réglage fin efficace des paramètres est appelée à évoluer. Les entreprises et les développeurs travaillant avec des LLM peuvent tirer parti de MoRA pour utiliser des modèles plus petits et plus spécialisés pour des tâches complexes sans encourir les coûts élevés associés à des systèmes plus grands et plus généralisés. La version open source de MoRA par les chercheurs amplifie encore son impact potentiel, offrant un outil robuste pour améliorer les modèles de base avec de nouvelles connaissances spécialisées dans divers domaines d’application.