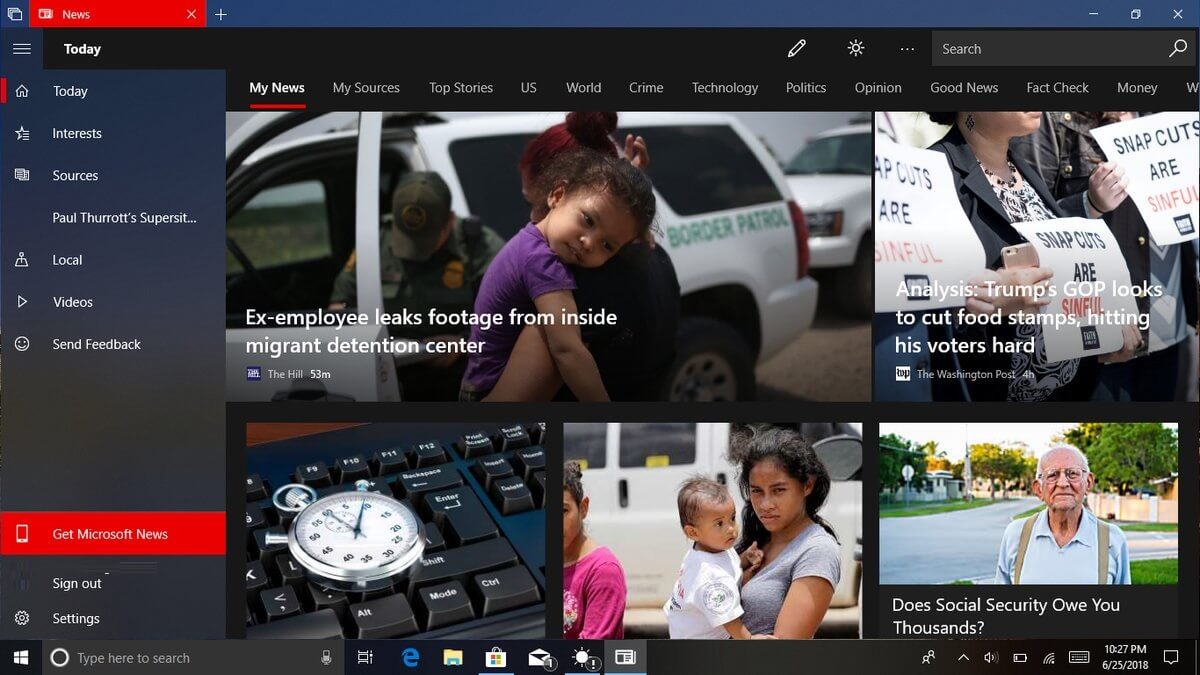

Le portail d’informations MSN de Microsoft est sous surveillance après la publication d’un article généré par l’IA qui qualifiait le joueur de NBA récemment décédé, Brandon Hunter, d’« inutile ». L’article original, paru sur un site d’informations sportives nommé « Race Track », est devenu viral, ce qui a suscité de nombreuses critiques.

L’article, apparemment généré par l’IA, décrivait le décès de l’ancien joueur de la NBA, âgé de 42 ans, d’une manière désagréable, avec des expressions telles que « rendu » et « joué dans 67 jeux vidéo. Cet incident a soulevé des inquiétudes quant à la fiabilité et à la sensibilité du contenu généré par l’IA, en particulier lorsqu’il s’agit de sujets sensibles tels que les nécrologies.

Un ancien joueur de la NBA décède jeune, et AI écrit ce titre :

p>

“Brandon Hunter inutile à 42”

Et vérifiez ce texte :

“L’ancien joueur de la NBA Brandon Hunter, qui avait auparavant joué pour les Boston Celtics et l’Orlando Magic, est décédé à l’âge de 42 ans.”https://t.co/xEvVVHo9DP pic.twitter.com/EiKlZEhluS

— Joshua Benton (@jbenton) 14 septembre 2023

Précédents incidents d’IA chez Microsoft

Ce n’est pas la première fois que les initiatives d’IA de Microsoft News sont critiquées. En août 2023, un guide de voyage généré par l’IA sur le portail d’information MSN recommandait bizarrement une banque alimentaire locale à Ottawa, au Canada, comme attraction touristique. Malgré ces erreurs répétées, Microsoft continue de s’appuyer fortement sur le contenu généré par l’IA.

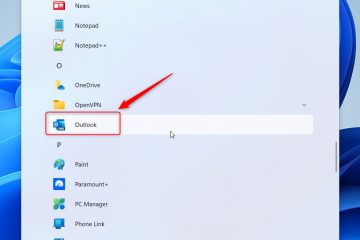

En 2020, l’entreprise a même licencié son équipe de journalistes MSN, entraînant une recrudescence des articles générés par l’IA sur la plateforme. Certains de ces articles ont été critiqués pour être factuellement inexacts, mal rédigés ou même plagiés.

Les implications plus larges de l’IA dans le journalisme

Les controverses récentes Le contenu généré par l’IA de Microsoft met en évidence les défis et les implications plus larges de l’intégration de l’IA dans le journalisme. Bien que l’IA puisse générer du contenu rapidement et à grande échelle, elle n’a pas le contact humain, la sensibilité et le jugement requis pour certains sujets.

L’incident avec la nécrologie de Brandon Hunter nous rappelle brutalement les pièges potentiels d’une trop grande confiance. fortement sur l’IA pour la génération de contenu. Alors que l’IA continue de jouer un rôle de plus en plus important dans le journalisme, il est crucial pour les éditeurs de trouver le bon équilibre entre l’automatisation et la surveillance humaine afin de maintenir la confiance et la crédibilité.

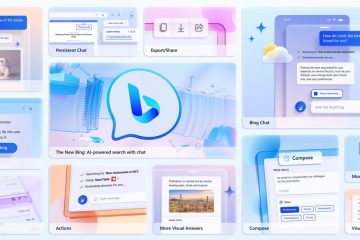

Microsoft exploite la même génération de contenu IA qui sous-tend Bing. Chatbot de recherche AI. Cela peut poser problème car Bing Chat est une source d’informations très peu fiable. J’ai arrêté d’utiliser Bing Chat comme outil de recherche/recherche approprié. Le chatbot de Microsoft est tout simplement trop aléatoire avec la vérité, notamment en fournissant de fausses citations, en inventant des noms et en se trompant généralement sur des détails mineurs – mais importants.

Bing Chat double également ses inexactitudes, argumente et devient facilement très confus. Ceci est important car cela signifie que les utilisateurs doivent micro-gérer le bot, utiliser des invites très claires et être prêts à vérifier tout ce qu’il produit. Cela prend du temps et n’est pas très efficace pour ce qui est censé être un outil de recherche.

Si les résultats des recherches ne sont pas fiables, à quoi sert-il d’utiliser Bing Chat ? C’est une situation similaire avec son utilisation pour tout type de création de contenu. S’il est nécessaire de tout vérifier et d’utiliser plusieurs invites, ces outils nous aident-ils vraiment ?