Tencent AI Labin tutkijat ovat julkistaneet uuden tekoälykehyksen, joka on suunniteltu murtamaan nykyisten suurten kielimallien nopeusrajoitukset.

Tällä viikolla julkaistussa verkossa julkaistussa asiakirjassa järjestelmän nimi on CALM, joka on tarkoitettu jatkuville automaattisille kielimalleille. Se haastaa suoraan hitaan, tunnistekohtaisesti prosessin, joka käyttää useimpia luovia tekoälyjä nykyään.

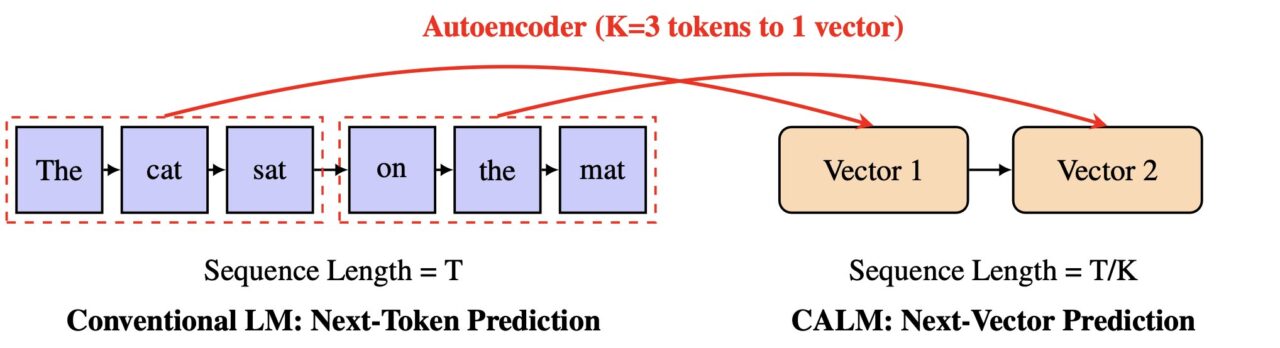

Sen sijaan, että se ennustaisi yhden pienen sanan palan kerrallaan, CALM oppii ennustamaan yhden vektorin, joka edustaa kokonaista tekstipalaa. Tämä menetelmä voisi tehdä tekoälyn luomisesta paljon nopeampaa ja tehokkaampaa, mikä avaa uuden polun mallien skaalausuudelle.

Nykyaikaisten LLM-yritysten perustavanlaatuinen heikkous on niiden riippuvuus autoregressiivisestä tunniste kerrallaan. Tämä peräkkäinen riippuvuus on suurin yksittäinen pullonkaula, joka rajoittaa tekoälyn nopeutta ja skaalautuvuutta. Pitkän artikkelin luominen vaatii tuhansia peräkkäisiä ennustusvaiheita, mikä tekee prosessista laskennallisesti kallista ja hidasta. Tämä ei ole vain akateeminen ongelma; Siksi tehokkaiden mallien käyttäminen on kallista ja reaaliaikainen, pitkän muodon luominen on edelleen haaste. Tästä tehokkuusongelmasta on tullut keskeinen taistelukenttä tekoälykehittäjille. Kuten Google Research totesi aiemmin,”kun otamme käyttöön näitä malleja useammille käyttäjille, niiden nopeampi ja halvempi tekeminen laadusta tinkimättä on kriittinen haaste.” Ala on tutkinut lukuisia ratkaisuja Googlen spekulatiivisista kaskadeista uusiin pakkaustekniikoihin. Nyt Tencentin työ ehdottaa radikaalimpaa ratkaisua. Paperissa ehdotetaan suunnitelmaa uudelle erittäin tehokkaiden kielimallien luokalle ja merkkien aiheuttamaan nopeuden pullonkaulaan. Tavoitteena on muuttaa ennustusyksikkö perusteellisesti yhdestä, vähän tietoa sisältävästä tunnisteesta paljon rikkaammaksi. Suoraan haasteeseen generatiivisen tekoälyn status quolle CALM muotoilee ennustetehtävän kokonaan uudelleen. Tutkijat ehdottavat uutta skaalausakselia LLM:ille. “Väitämme, että tämän pullonkaulan poistaminen vaatii uuden suunnitteluakselin LLM-skaalaukseen: kunkin generatiivisen vaiheen semanttisen kaistanleveyden lisäämistä”, he kirjoittavat paperissa. Kasvattamalla tätä”semanttista kaistanleveyttä”malli voi käsitellä enemmän tietoa yhdessä vaiheessa. CALM saavuttaa tämän innovatiivisella kaksivaiheisella prosessilla, joka toimii jatkuvassa, ei erillisessä tilassa. CALMin suunnittelun ytimessä on korkealaatuinen automaattinen kooderi. Tämä komponentti oppii pakkaamaan osan K merkkiä – esimerkiksi neljä merkkiä – yhdeksi, tiheäksi jatkuvaksi vektoriksi. Tärkeintä on, että se voi rekonstruoida alkuperäiset merkit tästä vektorista yli 99,9 %:n tarkkuudella. Erillinen kielimalli suorittaa sitten autoregressiivisen ennustuksen tässä uudessa vektoriavaruudessa. Projektin virallisen dokumentaation mukaan”sen sijaan, että ennustaisi yksi diskreetti merkki kerrallaan, CALM oppii ennustamaan yhden jatkuvan vektorin K:n, joka edustaa kokonaista p-vektoria.”vähentää generatiivisten vaiheiden määrää kertoimella K, mikä johtaa merkittäviin tehokkuuden lisäyksiin. Siirtyminen diskreeteistä tokeneista jatkuviin vektoreihin tuo suuren haasteen: malli ei voi enää laskea kaikkia standardimaisia mahdollisia prosessoitavuutta. Tämän vuoksi perinteisiä koulutus-ja arviointimenetelmiä, jotka perustuvat todennäköisyyksien laskemiseen, ei voida soveltaa. Tämän ratkaisemiseksi Tencent-tiimi kehitti kattavan, todennäköisyysvapaan viitekehyksen. CALM käyttää koulutuksessa Energy-Based Training-menetelmää, joka ohjaa mallia ehdottoman oikealla pisteytyssäännöllä ilman, että tarvitsee laskea todennäköisyyksiä. Arviointia varten tutkijat ottivat käyttöön uuden mittarin nimeltä BrierLM. Perinteisistä mittareista, kuten hämmennyksestä, BrierLM johdetaan Brier-pisteistä, todennäköisyysennusteiden työkalusta. Se mahdollistaa reilun, otokseen perustuvan mallin ominaisuuksien vertailun tarkistamalla, kuinka hyvin ennusteet vastaavat todellisuutta. Tämä menetelmä sopii täydellisesti malleihin, joissa todennäköisyydet ovat mahdottomia. Tämän uuden arkkitehtuurin käytännön vaikutus on ylivertainen suorituskyvyn ja laskennan välinen kompromissi. CALM-malli vähentää koulutuksen laskennallisia vaatimuksia 44 % ja päätelmiä 33 % vahvaan lähtötasoon verrattuna. Tämä osoittaa, että kunkin vaiheen semanttisen kaistanleveyden skaalaaminen on uusi tehokas vipu laskennan tehokkuuden parantamiseksi. Työ asettaa CALM:n merkittäväksi kilpailijaksi alan laajuisessa kilpailussa rakentaa nopeampaa, halvempaa ja helpompaa tekoälyä. Google on ratkaissut tekoälyn nopeusongelmaa spekulatiivisilla oppimismenetelmillä. Muut startupit, kuten Inception, tutkivat täysin erilaisia arkkitehtuureja, kuten diffuusiopohjaisia LLM-yrityksiä “Mercury Coderissa” välttääkseen autoregression”rakenteellisen pullonkaulan”. Yhdessä nämä erilaiset lähestymistavat korostavat tekoälyn kehitystä. Teollisuus on siirtymässä puhtaasta mittakaavakeskeisyydestä kestävämpään tavoitteeseen älykkäämpään, taloudellisesti kannattavampaan tekoälyyn. CALMin vektoripohjainen lähestymistapa tarjoaa uuden tien eteenpäin tällä rintamalla. The Tyken of the

The Tyken of the Todennäköisyysvapaa työkalupakki: Kuinka CALM oppii ja mittaa menestystä

Tehokkuus