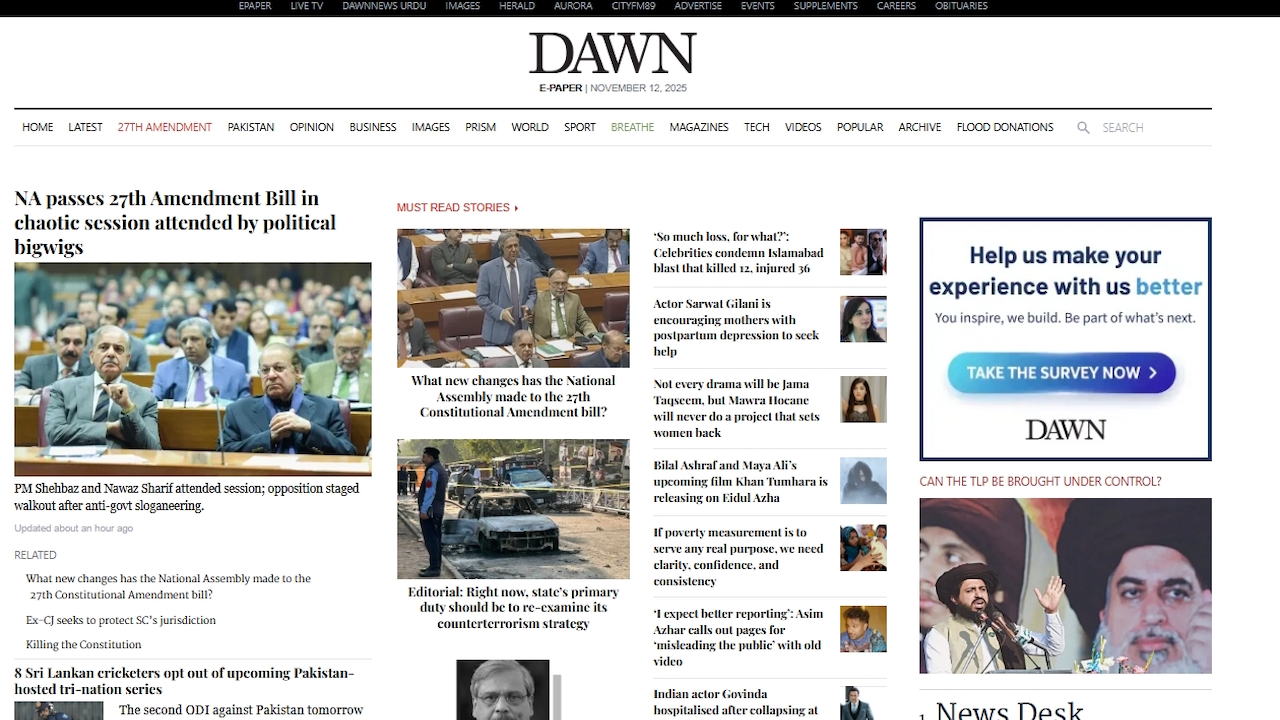

Pakistanilainen sanomalehti on korostanut hallitsemattoman tekoälyn kasvavaa ongelmaa sen jälkeen, kun se tulosti vahingossa chattibotin chattitekstiä. Dawn sisälsi 12. marraskuuta ilmestyneeseen painokseensa tekoälyn luoman viestin tehdäkseen selvästi luodusta artikkelista”näppärämmän”, pakottamalla julkisesti anteeksi omien sääntöjensä rikkomisesta.

Tällainen virhe ei ole yksittäistapaus, vaan osa laajempaa tekoälyvirheiden suuntausta. Tuomioistuimissa käytetyistä väärennetyistä lainopillisista lähteistä virheellisiin hallituksen raportteihin – kiire omaksua generatiivinen tekoäly ilman huolellista ihmisen arviointia heikentää yleisön luottamusta. Se on trendi, joka aiheuttaa vakavia, todellisia ongelmia suurille instituutioille.

“Haluatko, että teen sen seuraavaksi?”: Sanomalehden julkinen AI Gaffe

Pakistanin arvostettu englanninkielinen sanomalehti Dawn julkaisi artikkelin automyynnistä, joka päättyi omituiseen konekirjoitukseen. Päättävän kappaleen sijaan artikkelissa oli klassinen pala chatbot-pöyhkeää.

Tekoäly kysyi käyttäjältään:”Jos haluat, voin myös luoda”-front-schyna-sivulla”tasapuolisen version. rohkea, infografiikalla valmis asettelu – täydellinen lukijavaikutusten saavuttamiseen. Haluatko, että teen sen seuraavaksi?“

Tiedän, että toimittajat käyttävät tekoälyä työssään, mutta tämä on vähän paljon!

Dawn Business pages-työpöydän olisi pitänyt muokata ainakin viimeinen kohta!

😆😆😆 pic.twitter.com/JWNdHNWvnv

— omar r quraishi (@omar_quraishi) 12. marraskuuta 2025

Lukijat havaitsivat numeron nopeasti verkossa. muodollinen anteeksipyyntö. Artikkelin verkkoversioon liitetyssä huomautuksessa toimittaja myönsi, että”Tätä sanomalehtiraporttia on alun perin muokattu tekoälyllä, mikä on Dawnin nykyisen tekoälykäytännön vastaista. … Tekoälykäytännön rikkomista pahoittelemme. Tapausta tutkitaan.

“

Sanomalehden viralliset ohjeet kieltävät nimenomaisesti tekoälyn käyttämisen uutisten tuottamiseen tai muokkaamiseen ilman tiukkaa ihmisen valvontaa.

Vaikka Dawn-huijaus aiheutti hetken julkista hämmennystä, se toimii voimakkaana symbolina paljon syvemmälle ja merkityksellisemmälle ongelmalle. Generatiivisen tekoälyn ennenaikainen käyttöönotto ilman riittävää valvontaa johtaa useisiin suuriin epäonnistumisiin eri toimialoilla, mikä heikentää ammatillisia standardeja ja yleisön luottamusta.

Systeeminen ongelma: Kun tekoäly hallusinoituu suurilla panoksilla

Laikielestä julkisiin ammatillisiin malleihin ei voi löytää vaikeita keinoja. luotetaan kriittisiin tehtäviin. Hallusinaatioina tunnettu ilmiö, jossa tekoäly keksii itsevarmasti tosiasioita, lähteitä tai tietoja, on osoittautumassa pysyväksi ja vaaralliseksi virheeksi.

Tuore ja kallis esimerkki tulee konsulttimaailmasta. Maailmanlaajuinen yritys Deloitte joutui palauttamaan 97 000 dollaria Australian hallitukselle sen jälkeen, kun sen tuottaman 440 000 dollarin raportin havaittiin olevan täynnä tekoälyn luomia viittauksia.

Sen raportissa, joka on arkaluonteinen katsaus maan hyvinvointijärjestelmään, viitattiin olemattomiin kirjoihin ja väärin lainattuihin oikeustapauksiin. Australian työväenpuolueen senaattori Deborah O’Neill moitti jyrkästi:”Deloittella on ihmisälyongelma. Tämä olisi naurettavaa, jos se ei olisi niin valitettavaa.”

Akuutteja ongelmia ilmaantuu myös julkisella sektorilla. Heinäkuussa ilmestyi raportteja, että Yhdysvaltain elintarvike-ja lääkeviraston uusi”Elsa”AI, jonka tarkoituksena oli nopeuttaa lääkkeiden hyväksyntää, oli sen sijaan sepittänyt olemattomia lääketieteellisiä tutkimuksia.

Yksi turhautunut FDA:n työntekijä kuvaili työkalua CNN:lle epäluotettavaksi ja totesi, että se”halusinoi itsevarmasti”, kun taas toinen valitti, että olen vain tuhlannut ylimääräistä aikaa. on.“

Samaan tapaan tekoälyyrityksen Anthropicin asianajajien oli pyydettävä muodollisesti anteeksi tuomarilta sen jälkeen, kun heidän oma Claude AI keksi oikeudellisen viittauksen, jota käytettiin tuomioistuinhakemuksessa.

Erityisesti journalismi on nähnyt toistuvia tapauksia tästä laiminlyönnistä. Lokakuussa hämmästyttävän samankaltaisessa tapauksessa saksalainen Der Spiegel-lehti joutui korjaamaan artikkelin, joka sisälsi harhaanjohtavan tekoälyn luoman lauseen, joka tarjosi tekstin muuttamatta. rajoittuvat matalan tason sisältötiloihin, mutta niitä esiintyy arvostetuissa ja vakiintuneissa tiedotusvälineissä, mikä korostaa toimituksellisen työnkulun systeemistä kaatumista.

Nämä eivät ole yksittäisiä tapauksia. BBC:n ja European Broadcasting Unionin (EBU) koordinoima kansainvälinen maamerkkitutkimus paljasti tämän epäluotettavuuden systeemisen luonteen.

Yli 3 000 vastauksen arvioinnin jälkeen sen havainnot osoittivat, että tekoälyassistentit tuottavat merkittäviä virheitä 45 %:ssa uutisiin liittyvistä vastauksista. Kuten EBU:n mediajohtaja Jean Philip De Tender selitti:”Tämä tutkimus osoittaa lopullisesti, että nämä puutteet eivät ole yksittäisiä tapauksia. Ne ovat systeemisiä, rajat ylittäviä ja monikielisiä, ja uskomme, että tämä vaarantaa yleisön luottamuksen.”

Eroding Trust: The Real-World Cost of Unchecked AI Slop

Wikimedia Foundation raportoi äskettäin hätkähdyttävän 8 %:n laskun ihmisliikenteessä ja syytti suoraan tekoälyn hakutyökaluja ja chatbotteja siitä, että ne siivittävät kävijöitä tekemällä yhteenvedon sen sisällöstä ilman nimeä.

Tällainen suuntaus uhkaa tietosanakirjamallia. Kuten Wikimedian vanhempi tuotejohtaja Marshall Miller varoitti:”Jos Wikipediassa käy vähemmän, harvemmat vapaaehtoiset voivat kasvattaa ja rikastuttaa sisältöä ja harvemmat yksittäiset lahjoittajat voivat tukea tätä työtä.”

Sisäisesti alusta taistelee jo tekoälyn tuottamia lähetyksiä vastaan, jota yksi vapaaehtoisyhteisö kuvaili”ammattilaisena”poistopolitiikka poistaa pahimman osan.

Nämä toistuvat epäonnistumiset antavat lopulta kriittisen opetuksen tekoälyn nykytilasta. Vastuuta virheistä ei voi siirtää koneelle.

Kuten Googlen entinen pääpäätöstieteilijä Cassie Kozyrkov totesi sen jälkeen kun Cursor AI-koodieditorin tukibot keksi väärennetyn yrityskäytännön:”Tämä sotku olisi voitu välttää, jos johtajat ymmärtäisivät, että (1) tekoäly tekee virheitä, (2) tekoäly tekee virheitä, (2) tekoäly tekee virheistä (käyttäjiä ei voi ottaa vastuuta) ja virheistä (3) ei voi ottaa vastuuta. ihmisenä esiintyvän koneen huijaaman.“

Se, mitä Dawnissa tapahtui, on yksinkertaisesti viimeisin muistutus siitä, että tekoälyn aikakaudella viimeinen, välttämätön laadunvalvonnan kerros on edelleen ahkera ihmisen valvonta.