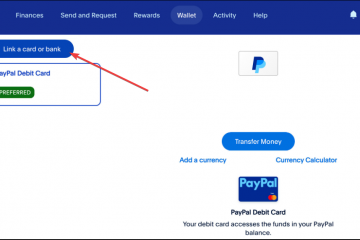

Meses después de implementar herramientas de resumen impulsadas por Gemini, Google se enfrenta a un nuevo escrutinio sobre cómo impulsa esos modelos de IA. Los informes indican que la compañía ha habilitado silenciosamente”funciones inteligentes”de forma predeterminada para usuarios fuera de Europa, otorgando permiso para escanear correos electrónicos privados y archivos adjuntos para potencialmente entrenar sus sistemas de inteligencia artificial generativa.

Este cambio obliga a una dura compensación: los usuarios deben permitir que sus datos se utilicen para mejorar el modelo o desactivar por completo herramientas de productividad básicas como la sincronización de calendarios y el seguimiento de paquetes.

Si bien las regulaciones europeas exigen una estricta política de participación voluntaria, los usuarios estadounidenses se están inscribiendo automáticamente en un ecosistema de intercambio de datos que sustenta la agresiva expansión de la IA de Google.

La aceptación’silenciosa’y la trampa de la utilidad

El YouTuber y bloguero tecnológico Dave Jones ha señalado un cambio significativo en la configuración predeterminada de Google para usuarios no europeos, lo que marca un alejamiento de la privacidad anterior normas.

En el centro de la controversia está la configuración”Funciones inteligentes y personalización”, que otorga a Google un amplio acceso para escanear contenido de correo electrónico privado, registros de chat y archivos adjuntos.

Mensaje IMPORTANTE para todos los que usan Gmail.

Se te ha aceptado automáticamente para permitir que Gmail acceda a todos tus mensajes privados y archivos adjuntos para entrenar modelos de IA.

Debes desactivar manualmente las funciones inteligentes en el menú Configuración en DOS ubicaciones.Retuitea para que todos estén al tanto. pic.twitter.com/54FKcr4jO2

— Dave Jones (@eevblog) 19 de noviembre de 2025

Como Pieter Arntz de Malwarebytes notas, “bajo el radar, Google ha agregado funciones que permiten a Gmail acceder a todos los mensajes privados y archivos adjuntos para entrenar sus modelos de IA”, destacando la falta de fanfarria que acompaña al cambio.

A diferencia de iteraciones anteriores de políticas de uso de datos, este permiso está vinculado explícitamente a”mejorar”los modelos de IA generativa, lo que genera preocupaciones sobre si la correspondencia personal se está utilizando para entrenar modelos fundamentales como Gemini.

La implementación crea lo que los críticos llaman una”trampa de utilidad”, donde el intercambio de datos está inextricablemente unido a herramientas de productividad centrales. Deshabilitar la configuración para compartir datos de IA desencadena una cascada de funciones fallidas, incluida Smart Compose, creación automática de entradas de calendario a partir de correos electrónicos y seguimiento de paquetes.

Los usuarios que intentan proteger sus datos deben navegar por un complejo proceso de exclusión voluntaria de dos pasos, deshabilitando tanto las”Funciones inteligentes en Gmail, Chat y Meet”como las”Funciones inteligentes en Google Workspace”para cortar completamente el enlace de datos. Arntz señala:

“Para excluirse por completo, debe desactivar las’funciones inteligentes’de Gmail en dos ubicaciones separadas de su configuración. No se pierda una, o la capacitación en IA puede continuar”.

El diseño de la interfaz de usuario desalienta activamente la exclusión voluntaria presentando una lista de advertencia de funcionalidades que se perderán, creando un ultimátum de”privacidad versus utilidad”.

Este enfoque contrasta con los controles granulares que a menudo exigen los defensores de la privacidad, lo que obliga los usuarios pueden elegir entre una bandeja de entrada funcional y una privada.

El hambre de datos: por qué Google necesita su bandeja de entrada

La documentación de soporte oficial de Google describe la base legal para este procesamiento, que incluye”el desarrollo de nuevos productos y funciones”.

La empresa establece que “cuando activas las funciones inteligentes en Gmail, Chat y Meet, aceptas que Gmail, Chat y Meet usen tu contenido y actividad en estos productos para personalizar tu experiencia en esas aplicaciones”, enmarcando el acceso a los datos como un componente necesario del acuerdo de servicio.

“Para mejorar nuestros servicios. Si has activado alguna de las configuraciones de funciones inteligentes, también podemos procesar el contenido y la actividad de tu espacio de trabajo para mejorar estas funciones”.

“Procesamiento La información para este propósito es necesaria para los intereses legítimos de Google y nuestros usuarios en: Proporcionar, mantener y mejorar servicios… Desarrollar nuevos productos y características… Realizar investigaciones que beneficien a nuestros usuarios y al público”.

La ambigüedad de la”personalización”, que puede incluir”afinar”modelos locales (para beneficio del usuario) y”entrenar”modelos fundamentales (para beneficio de Google) sigue siendo un punto crítico de discordia. Si bien Google afirma que los datos se utilizan para”mejorar”funciones, la falta de una distinción clara deja abierta la posibilidad de que los datos del usuario contribuyan a la inteligencia más amplia del ecosistema Gemini.

Se ha formado una”brecha de privacidad”basada en la geografía: Google confirma que estas configuraciones están desactivadas de forma predeterminada en el EEE, Reino Unido, Suiza y Japón debido a regulaciones más estrictas como GDPR.

“Cuando activas funciones inteligentes en Google Workspace, aceptas permitirlas. Google Workspace utiliza el contenido y la actividad de Workspace para personalizar su experiencia en Workspace.”

“Cuando desactiva esta configuración, no puede usar las experiencias enumeradas anteriormente en los productos de Google Workspace. Para continuar usando estas experiencias, debe volver a activar la configuración”.

Para los usuarios de los Estados Unidos, que carecen de protecciones federales similares, la postura predeterminada es la de inclusión en el ecosistema de intercambio de datos. La disparidad resalta cómo la presión regulatoria, en lugar de la benevolencia corporativa, dicta la postura de privacidad predeterminada de las grandes empresas tecnológicas.

El contexto histórico resalta los riesgos de implementar estos modelos en datos privados: el error de traducción de IA de Google Gmail de julio de 2025 sirve como advertencia. En ese incidente, Gemini tradujo erróneamente correos electrónicos alemanes, convirtiendo un”as”político en un”asno”, causando un daño significativo a la reputación de los editores.

A pesar de estos riesgos, el impulso de la industria sugiere que la recopilación de datos se está convirtiendo en el costo de entrada estándar para los servicios gratuitos.

Ron Richards del podcast Android Faithful describió la tendencia más amplia a principios de este año, diciendo que”ese barco ha zarpado. Y no solo de Google, sino de toda la industria… la IA está aquí… y no va a desaparecer”, lo que refleja una creciente resignación entre los observadores tecnológicos de que la integración de la IA es inevitable.

La privacidad como producto de lujo

Está surgiendo una segmentación de mercado distinta donde la privacidad se está convirtiendo en una característica premium en lugar de un derecho estándar. Competidores como Perplexity están aprovechando esto al ofrecer un plan”Max”de $200 al mes que promete explícitamente no entrenar modelos con datos de usuario.

Esto contrasta marcadamente con el modelo gratuito y con publicidad de Google, que se basa en monetizar los datos de los usuarios ya sea a través de anuncios o entrenamiento de modelos. Pieter Arntz argumentó que”la falta de consentimiento explícito se siente como un paso atrás para las personas que quieren controlar cómo se utilizan sus datos personales”, señalando la erosión de la agencia del usuario frente a las configuraciones predeterminadas.