AI Startup Qodo ha ingresado a la feroz”guerra de referencia”para codificar la supremacía. El 11 de agosto, la compañía anunció que su nuevo agente, Qodo Command, obtuvo un impresionante 71.2% en la prueba verificada de SWE-Bench. Este resultado empuja a Qodo directamente a una arena competitiva dominada por gigantes como Anthrope y OpenAI. El comando QODO se basa en Langgraph y permite usar modelos de OpenAI, Anthrope y otros para tareas de codificación.

El anuncio sigue una semana vertiginosa de una sola vez. Anthrope y OpenAi recientemente se saltaron entre sí para el primer lugar, reclamando puntajes de 74.5% y 74.9%, respectivamente. La implacable carrera para el dominio de referencia está aumentando rápidamente.

Esta competencia de alto riesgo, sin embargo, se desarrolla en un contexto de tropiezos del mundo real. High-scoring models like OpenAI’s new GPT-5 have faced troubled public launches, raising critical questions about whether benchmark success truly translates to reliable, production-ready performance.

The Swe-Bench Gauntlet: un nuevo campeón mundial de codificación cada dos semanas

La batalla por el El lugar superior en el ritmo de la tabla de clasificación Swe-bench ha sido un afecto frustrado y alto, con el título de”Modelo de mejor momento”de los mejores tiempos”. Esta serie de anuncios rápidos de los principales laboratorios de la industria destaca a ritmo frenético y armonizado de desarrollo , donde bench-geaponized/”Target=”_ _ en blanco”> frenético y armado de desarrollo del desarrollo ,, donde Benchbot-weaponized/”Target=”_ _ en blanco”> frenético y armado de desarrollo de Desarrollo ,, donde Bench-Geaponized/”Target=”_ _ en blanco”> Pacio frenético y armonizado de Desarrollo ,, donde Bench-Geaponized Objetivo.

El enfoque intenso está en el banco SWE por una razón. A diferencia de las pruebas sintéticas, es una evaluación exigente que refleja la ingeniería de software del mundo real. Cada tarea se deriva de un problema real de GitHub que se encuentra en uno de los 12 repositorios de Python de código abierto ampliamente utilizados. Para tener éxito, los agentes de IA deben razonar, planificar y editar correctamente el código, a menudo a través de múltiples archivos, iterando como lo haría un desarrollador humano sin atajos.

La última ronda de esta guerra de referencia comenzó en serio el 5 de agosto, cuando Anthrope anunció su nuevo Opus 4.1 de Claude había alcanzado una partitura de 74.5%. Esta puntuación representó un salto significativo sobre el 72.5% de su predecesor, Claude 4 Opus, había publicado solo unos meses antes en mayo, demostrando un progreso notable.

Sin embargo, el reinado de Anthrope fue de corta duración. Solo unos días después, el 7 de agosto, Openai respondió con el lanzamiento de su muy esperada serie de modelos GPT-5. La compañía afirmó que su nuevo buque insignia había superado por poco a su rival con una tasa de éxito del 74.9%, destronando inmediatamente a Claude 4.1 y aprovechando el primer lugar para sí mismo.

está en este campo turbulento que ahora entra el puntaje del 71.2% de Qodo. Si bien no es el puntaje más alto, es un logro formidable para una startup más pequeña, colocando su agente de comandos Qodo firmemente en la misma liga que los titanes de la industria. El resultado demuestra que los enfoques arquitectónicos innovadores pueden competir con la escala de los laboratorios más grandes.

Esta vertiginosa sucesión de afirmaciones ha creado una confusión significativa en la comunidad de desarrolladores. El sitio web oficial de SWE-Bench se ha convertido en un indicador de retraso, incapaz de seguir el ritmo de los comunicados de prensa de la compañía. La tabla de clasificación que se muestra públicamente aún muestra puntajes más antiguos y reemplazados, por lo que es una fuente poco confiable para el estado actual.

Para complicar aún más las cosas, toda la jerarquía está siendo cuestionada por análisis independientes. Muchos expertos, por ejemplo, sugieren que un modelo diferente, el soneto de Claude menos potente de Anthrope, en realidad lidera el paquete cuando se evalúa bajo ciertas condiciones. Esta discrepancia plantea preguntas críticas sobre las metodologías de prueba y si la parte superior de la tabla de clasificación es tan clara como sugieren los anuncios.

debajo del capó: cómo el comando QODO logró su puntaje

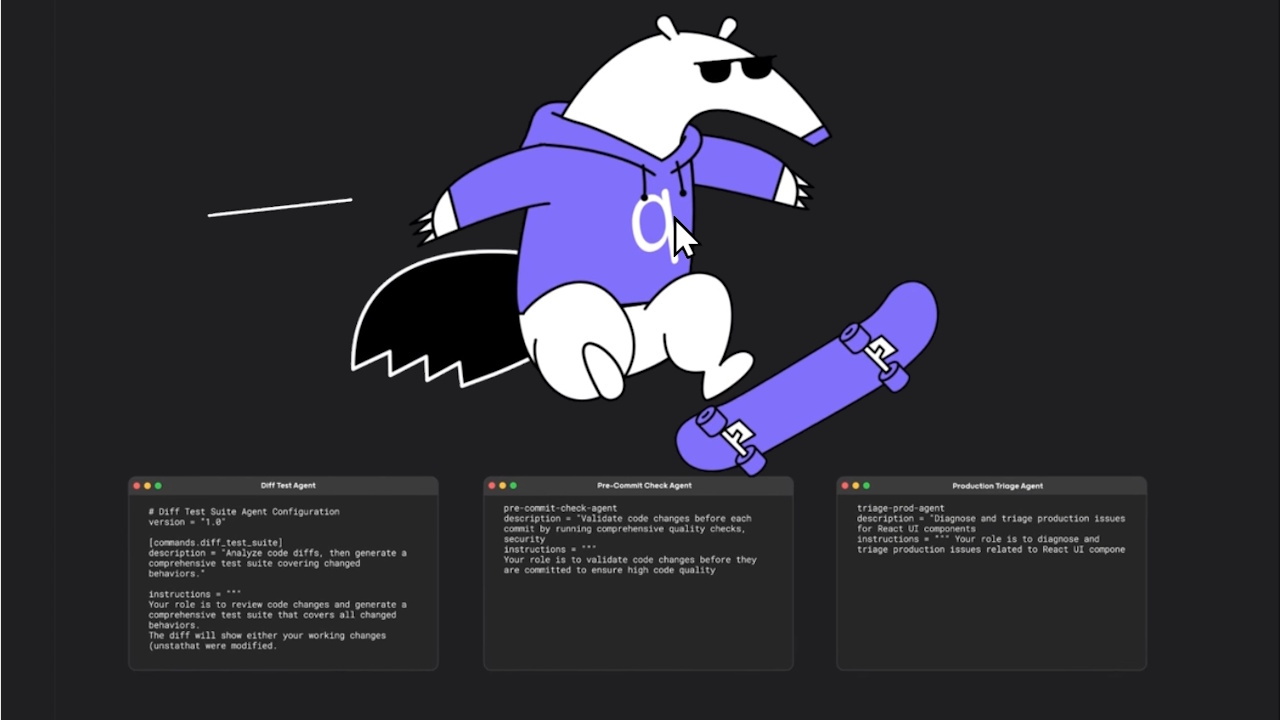

Qodo atribuye su fuerte mostrador para no comparar optimización, sino a una arquitectura agente sofisticada Diseñado desde cero para ingeniería de software del mundo real . En lugar de confiar en un solo modelo monolítico, el agente de comandos QODO se basa en Langgraph, un marco poderoso que permite la creación de flujos de trabajo modulares, estestados y cíclicos. Esta base proporciona la velocidad y la flexibilidad necesarias para abordar problemas complejos y de varios pasos.

El uso de Langgraph es un diferenciador clave. Permite que Qodo orquesta operaciones complejas como un gráfico, donde cada paso es un nodo configurable. Esta modularidad no es solo una ventaja teórica; Permitió al equipo reutilizar y extender los componentes probados de su extensión IDE existente, Qodo Gen. Esto incluye módulos probados en batalla para el análisis de código, resumen y escaneo de seguridad, que podría reutilizarse sin esfuerzo dentro del nuevo agente.

Una de las fortalezas centrales del agente es su avanzada resumen de contexto. El sistema de Qodo reconoce que tener éxito en bases complejas de código múltiple requiere más que solo alimentar archivos sin procesar a un modelo de idioma. Resuelve esto al destilar primero el código en capas en resúmenes precisos y de alta señal, asegurando que la LLM reciba solo el contexto más relevante y estructurado en cada paso de su proceso de razonamiento.

Esto se combina con un enfoque disciplinado de”plan primero”para la ejecución. Antes de escribir cualquier código, el agente analiza profundamente el objetivo del usuario y lo descompone en una serie clara y procesable de subtareas. Esto crea una hoja de ruta confiable para que la LLM lo siga. De manera crucial, la finalización de la tarea se juzga no solo por la salida final sino también por la estricta adhesión a este plan original. Cualquier hueco detectado desencadena un bucle de retroalimentación y reintento hasta que se logre una alineación completa. Cuando una llamada de herramienta falla, el agente no simplemente se detiene; se adapta. El sistema extrae automáticamente la retroalimentación de errores, invoca el LLM para diagnosticar la falla y luego ajusta de manera inteligente los parámetros o estructura de la herramienta. El agente está facultado para volver a intentar una llamada hasta tres veces, y si una resolución aún no es posible, puede pivotar estrategias alternativas para garantizar que el progreso continúe.

Este razonamiento de agente está respaldado por un poderoso conjunto de herramientas de grado desarrollador que le permiten operar como un desarrollador humano experto. Su conjunto de herramientas incluye:

archivos del sistema: herramientas estándar para leer, escribir y editar archivos. Reconociendo que incluso los modelos de vanguardia pueden fallar en las coincidencias de ruta de archivo exacta, Qodo implementó un mecanismo de retroceso que utiliza la coincidencia difusa para mejorar la tasa de éxito de la herramienta. herramienta de shell: Esto le da al agente la capacidad de interactuar directamente con el shell del sistema. Puede ejecutar scripts de construcción, ejecutar suites de prueba y validar sus propias hipótesis en tiempo real, imitando el flujo de trabajo interactivo de un desarrollador. ripgrep: Para una comprensión de base de código profunda, el agente está diseñado de forma nativa para el uso optimizado de la herramienta de búsqueda recursiva de RipGrep, lo que le permite localizar rápidamente los fragmentos de código relevantes en repositorios grandes. Pensamiento secuencial: Aunque no está habilitado de forma predeterminada, esta herramienta de razonamiento estructurada ayudó a contribuir a los resultados de referencia descomponiendo tareas complejas en pasos más manejables y procesables.

Para la ejecución de referencia, Qodo señala que su herramienta de búsqueda web estaba deshabilitada para evitar cualquier posible fuga de datos en las soluciones, asegurando la integridad de su puntaje. Finalmente, la compañía destaca su sólida asociación con Anthrope, lo que confirma que es un “alimentado por Claude”Solución . Especifica que Claude 4 surgió como su modelo de elección para lograr sus impresionantes resultados de Swe-Bench.

supremacía de referencia versus tropiezos del mundo real

El intenso enfoque de la industria en el dominio de referencia contrasta bruscamente con el debut público de Open de Openi. A pesar de su puntaje récord y afirmaciones ambiciosas del CEO Sam Altman de que”este es el mejor modelo del mundo en la codificación… el mejor modelo del mundo en la escritura, el mejor modelo del mundo en el cuidado de la salud y una larga lista de cosas más allá de eso”, el lanzamiento del modelo fue un casi desastre. El modelo produjo mapas con estados ficticios, matemáticas básicas fallidas e inventó a los presidentes estadounidenses, lo que llevó a un ridículo generalizado y dañando la credibilidad de la compañía.

La reacción violenta fue tan severa que para el 8 de agosto, Altman emitió una disculpa pública. Admitió que”un”AutoSwitcher”defectuoso entre los modos internos del modelo lo había hecho durante más tiempo”parecía mucho más tonto”de lo previsto”, una falla técnica que hizo que el modelo pareciera mucho menos capaz de lo previsto. En una reversión significativa, Openai prometió Restaurar el acceso a su popular predecorante, GPT-4O .

este Glaring Disconnect ha desanimado a su popular predecorán Sobre el valor final de los puntos de referencia, a medida que las apuestas en las guerras de codificación de IA aumentan. Los competidores se apresuran a capitalizar cualquier paso en falso. En una clara respuesta al tropiezo de OpenAi, XAI de Elon Musk hizo su modelo Grok 4 gratis por un tiempo limitado. Sin embargo, Grok en sí ha enfrentado críticas por ser sobrecargado a puntos de referencia.

Esta volatilidad de referencia crea un entorno desafiante para los clientes empresariales. Elegir un socio de codificación de IA se convierte en una apuesta cuando el modelo proclamado”mejor”puede destronarse en días o fallar en la práctica. Cambia el enfoque de las métricas de rendimiento puro a la confiabilidad, la consistencia y la utilidad del mundo real.

Para los desarrolladores y las empresas que dependen de ellas, la pregunta clave sigue siendo: ¿Puede un modelo que se puede confiar en una prueba estandarizada para crear un software robusto, confiable y seguro? La agitación reciente sugiere que la respuesta está lejos de ser simple.)