Hugging Face ha lanzado una iniciativa para proporcionar al público 10 millones de dólares en computación GPU, con el objetivo de aliviar la presión financiera sobre los equipos de desarrollo de IA más pequeños. El programa, denominado ZeroGPU, fue presentado por el CEO Clem Delangue en X.

Abordar las disparidades de recursos

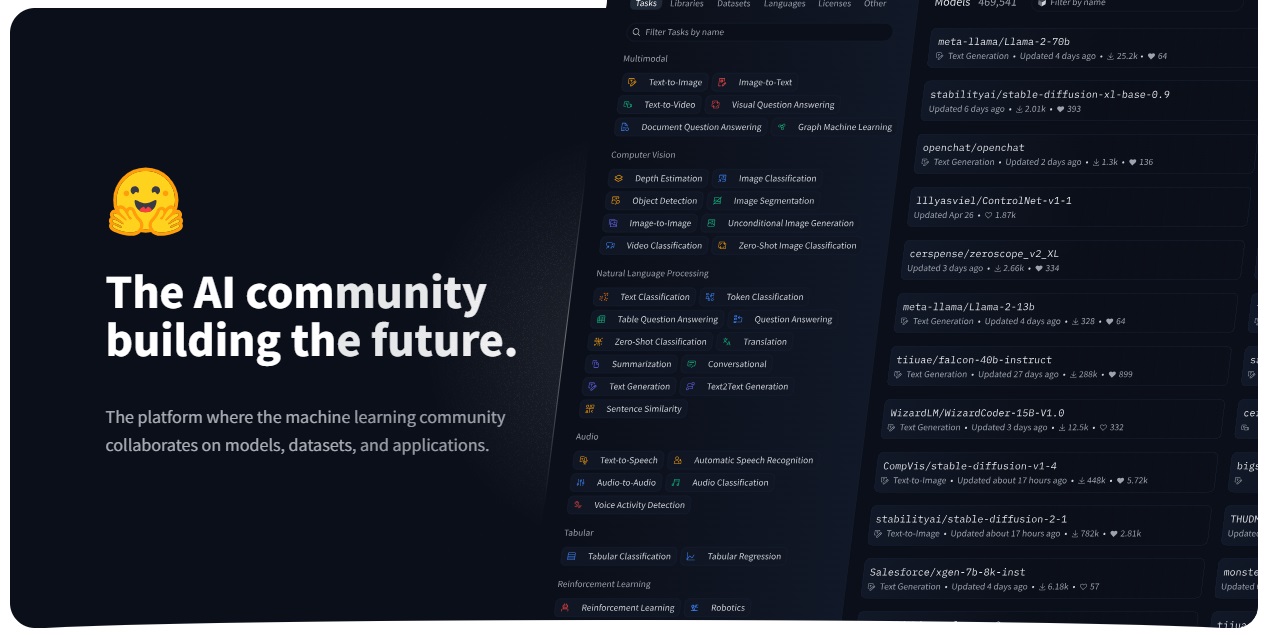

Delangue enfatizó la brecha de recursos entre las grandes empresas de tecnología y la comunidad de código abierto, que a menudo carece de la infraestructura necesaria para entrenar e implementar modelos de IA. Esta disparidad ha contribuido al predominio de aplicaciones como ChatGPT. ZeroGPU tiene como objetivo cerrar esta brecha ofreciendo infraestructura compartida para que los desarrolladores de IA académicos e independientes ejecuten demostraciones de IA en Hugging Face Spaces, reduciendo así su carga financiera.

GPU-Poor no more: muy emocionado de Lanza oficialmente ZeroGPU en versión beta hoy. ¡Felicitaciones @victormustar y equipo por el lanzamiento!

En los últimos meses, la comunidad de IA de código abierto ha prosperado. No solo Meta sino también Apple, NVIDIA, Bytedance, Snowflake, Databricks, Microsoft,… pic.twitter.com/6UzWvYhmpw

— clem 🤗 (@ClementDelangue) 16 de mayo de 2024

Fundada en 2016, Hugging Face se ha convertido en un proveedor líder de modelos de IA de código abierto optimizados para diversas plataformas de hardware, gracias a asociaciones con gigantes de la industria como Nvidia, Intel y AMD. Delangue considera el código abierto como el futuro de la innovación y la adopción de la IA, y la iniciativa ZeroGPU es un paso hacia la democratización del acceso a los recursos esenciales.

Infraestructura de GPU compartida

La documentación de soporte indica que las funciones de la GPU tienen un límite de 120 segundos, lo cual es insuficiente para fines de formación. Un portavoz de Hugging Face ha confirmado que la atención se centra principalmente en la inferencia, aunque hay planes para explorar otras aplicaciones en el futuro.

Implementación técnica

El Los detalles técnicos de cómo Hugging Face logra compartir los recursos de la GPU de manera eficiente siguen sin estar claros. Delangue menciona que el sistema puede”retener y liberar GPU de manera eficiente según sea necesario”, pero no se detallan los mecanismos exactos. Los métodos potenciales incluyen dividir el tiempo para ejecutar múltiples cargas de trabajo simultáneamente, tecnología GPU (MIG) de instancias múltiples de Nvidia y Contenedores acelerados por GPU orquestados por Kubernetes. Estas técnicas han sido utilizadas por otros proveedores de nube para hacer que la computación por GPU sea más accesible.

Las GPU A100 que se utilizan tienen una memoria de 40 GB La capacidad, que puede admitir cargas de trabajo de modelos sustanciales pero limitadas, estará disponible a través de Hugging Face’s Spaces, una plataforma de alojamiento para publicar aplicaciones, que cuenta con más de 300.000 demostraciones de IA creadas hasta ahora en CPU o GPU paga.

Financiamiento y visión

El compromiso de Hugging Face con esta iniciativa es posible gracias a su estabilidad financiera, ya que la compañía es”rentable o casi rentable”y recientemente recaudó $235 millones en financiamiento. valorándolo en 4.500 millones de dólares. Delangue expresó su preocupación por la capacidad de las nuevas empresas de IA para competir con los gigantes tecnológicos, que mantienen avances significativos en la IA y tienen importantes recursos computacionales. Hugging Face tiene como objetivo hacer que las tecnologías avanzadas de inteligencia artificial sean accesibles para todos, no solo para los gigantes tecnológicos.

Impacto en la comunidad

El acceso a la computación plantea un desafío importante para la construcción de grandes empresas. modelos de lenguaje, que a menudo favorecen a empresas como OpenAI y Anthropic. Andrew Reed, ingeniero de aprendizaje automático en Hugging Face, creó una aplicación que visualiza el progreso de los LLM propietarios y de código abierto a lo largo del tiempo, mostrando la brecha entre los dos cada vez más cerca. Más de 35.000 variaciones del modelo de IA de código abierto Llama de Meta se han compartido en Hugging Face desde la primera versión de Meta hace un año.