Anthropic ha lanzado hoy Claude Opus 4.5, consiguiendo la puntuación de codificación más alta de la industria e introduciendo un cambio arquitectónico significativo para reducir los costos.

Al recortar el precio un 66% a $5 por millón de tokens de entrada e implementar la”Búsqueda de herramientas”para reducir la sobrecarga de contexto en un 85%, la compañía ataca directamente la principal barrera económica para los agentes autónomos de IA.

El modelo logra una puntuación del 80,9% en SWE-bench Verified, superando por poco los lanzamientos recientes de Google y OpenAI para recuperar la corona de rendimiento para tareas complejas de ingeniería de software.

The Benchmark Wars: Reclamando la Corona

Opus 4.5 llega con una puntuación del 80,9% en SWE-bench Verified, el estándar de oro actual para evaluar capacidades de ingeniería de software autónomas. Superando a la competencia, la puntuación supera al lanzamiento de Gemini 3 Pro de Google con un 76,2 % y a GPT-5.1-Codex-Max con un 77,9 %.

Las evaluaciones internas sugieren que el modelo ahora obtiene una puntuación más alta que los candidatos humanos en las pruebas de ingeniería de Anthropic.”Opus 4.5 es un paso adelante en lo que pueden hacer los sistemas de IA y una vista previa de cambios más importantes en la forma en que se realiza el trabajo”, afirmó la compañía en su anuncio.

Para equilibrar el costo con la capacidad, un nuevo parámetro de”esfuerzo”permite a los desarrolladores ajustar dinámicamente la profundidad del razonamiento del modelo durante las llamadas API. Con un esfuerzo”medio”, Opus 4.5 iguala el rendimiento máximo del modelo Sonnet 4.5 anterior pero consume un 76 % menos de tokens de salida.

Empujando el límite de la resolución automatizada de problemas, la configuración de esfuerzo”alto”supera las capacidades de Sonnet 4.5 en 4,3 puntos porcentuales. Noviembre ha demostrado ser un mes activo en IA, con los tres laboratorios principales implementando sus modelos de codificación emblemáticos entre el 18 y el 24.

El cambio económico: precios y arquitectura

Para abordar las preocupaciones de las empresas sobre la viabilidad de costosos modelos de”razonamiento”, Anthropic ha revalorizado agresivamente el modelo a 5 dólares por millón de tokens de entrada y 25 dólares por millón de tokens de salida.

En comparación con la generación anterior de Opus ($15/$75), la nueva tarifa ofrece un descuento del 66 %, como se detalla en Presentación de Claude Opus 4.5.

Bajo el capó, la arquitectura aborda el problema del”Context Bloat”. Tradicionalmente, cargar más de 50 definiciones de herramientas podía consumir aproximadamente 55 000 tokens antes de que se procesara una sola consulta de usuario.

Según la documentación de uso avanzado de herramientas, el nuevo sistema cambia fundamentalmente esta dinámica:

“En lugar de cargar todas las definiciones de herramientas por adelantado, la herramienta de búsqueda de herramientas descubre herramientas bajo demanda. Claude solo ve las herramientas que realmente necesita para la tarea actual.”

“Esto representa una reducción del 85% en el uso de tokens mientras se mantiene el acceso a su biblioteca de herramientas completa. Las pruebas internas mostraron mejoras significativas en la precisión en las evaluaciones de MCP cuando se trabaja con bibliotecas de herramientas grandes”.

Complementando esto está la “Llamada de herramientas programáticas” (PTC), que permite que el modelo escriba código de orquestación en lugar de depender de la toma de turnos basada en chat.

La documentación técnica explica con más detalle la mecánica de PTC:

“En lugar de que Claude solicite herramientas una a la vez y cada resultado se devuelva a su contexto, Claude escribe código que llama a múltiples herramientas, procesa sus resultados y controla qué información ingresa realmente a su ventana de contexto”.

“Claude sobresale en la escritura de código y, al permitirle expresar la lógica de orquestación en Python en lugar de a través de invocaciones de herramientas en lenguaje natural, se obtiene un flujo de control más confiable y preciso”.

PTC elimina la necesidad de pasos de inferencia de ida y vuelta para cada llamada de herramienta individual, lo que reduce significativamente la latencia. El procesamiento de conjuntos de datos extensos, como 200 KB de datos de gastos sin procesar, se vuelve viable ya que el modelo devuelve solo el resultado final de 1 KB a la ventana de contexto.

“Para crear agentes eficaces, necesitan trabajar con bibliotecas de herramientas ilimitadas sin meter cada definición en el contexto de antemano”, señaló el equipo de ingeniería de Anthropic.

Expansión del ecosistema: Chrome, Excel y seguridad

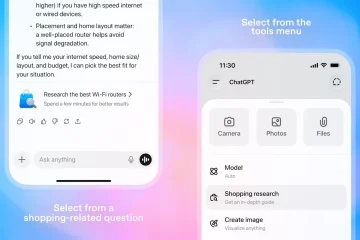

Más allá del modelo central, “Claude Code”pasó de la versión beta a la disponibilidad general y ofrece una aplicación de escritorio completa para los flujos de trabajo de los desarrolladores. Las nuevas integraciones permiten que el modelo controle el navegador Chrome directamente, yendo más allá de la generación de texto a la investigación activa y la ejecución de tareas.

[contenido incrustado]

Dirigida al modelado financiero, una integración de Excel dedicada permite al modelo manipular hojas de cálculo con miles de filas.

Dianne Na Penn, jefa de gestión de productos para investigación en Anthropic, enfatizó la importancia de esta capacidad:”Conocer los detalles correctos para recordar es realmente importante además de tener una ventana de contexto más larga”.

[contenido incorporado]

La seguridad sigue siendo un pilar central del lanzamiento. La tarjeta del sistema Claude Opus 4.5 destaca importantes inversiones en la mitigación de riesgos químicos, biológicos, radiológicos y nucleares (CBRN).

La tarjeta del sistema describe explícitamente el estado de alineación del modelo:

“Opus 4.5 es el modelo más sólidamente alineado que hemos lanzado hasta la fecha y, sospechamos, el modelo de frontera mejor alineado por cualquier desarrollador.”

“Opus 4.5 es más difícil de engañar con una inyección rápida que cualquier otro modelo de frontera en la industria”.

Realidad del mercado: la era de los agentes

Contextualizando el lanzamiento, la”fiebre de la IA de noviembre”ha visto a Google, OpenAI y Anthropic girar simultáneamente hacia agentes autónomos. Las narrativas han pasado de “chatbots” a “agentes” capaces de realizar tareas durante más de 24 horas.

Si bien Anthropic lidera los puntos de referencia brutos (80,9%), el margen es muy estrecho, con menos de 5 puntos porcentuales que separan a los tres principales contendientes. Existe una compensación clave en la nueva arquitectura: la “Búsqueda de herramientas”introduce un paso de búsqueda que puede agregar latencia en comparación con tener todas las herramientas precargadas en contexto.

A diferencia de la optimización nativa de Windows de OpenAI con Codex-Max, Anthropic apuesta por un enfoque de escritorio independiente de la plataforma. La gestión de la memoria se ha convertido en el nuevo campo de batalla, con OpenAI utilizando la”compactación”y Anthropic implementando la”Búsqueda de herramientas”para resolver el mismo cuello de botella de la ventana de contexto.