Las encuestas en línea y la investigación en ciencias sociales se enfrentan a una crisis existencial después de que un nuevo estudio revelara que los agentes autónomos de IA ahora pueden razonar a través de los principales mecanismos de defensa de la industria.

Publicada esta semana en las Actas de la Academia Nacional de Ciencias (PNAS), una nueva investigación demuestra que los modelos de lenguaje grande (LLM) lograron una tasa de aprobación del 99,8 % en controles de atención estándar.

Al hacerlos efectivamente indistinguibles de los encuestados humanos, se demostró que los agentes de IA fingían ignorancia estratégicamente para derrotar los”shibboleths inversos”, tareas fáciles para las máquinas pero difíciles para las personas. Al hacerlo, han roto la “Prueba de Turing” digital en la que se basan los científicos de datos y estrategas políticos de todo el mundo.

La muerte del’control de atención’: cómo los agentes aprendieron a mentir

Durante décadas, los investigadores se han basado en una premisa simple para filtrar datos incorrectos. Si un encuestado responde coherentemente y pasa comprobaciones lógicas básicas, se supone que es una persona real.

Sean Westwood, advierte en su nuevo artículo de investigación que”la suposición fundamental de la investigación por encuestas, que una respuesta coherente es una respuesta humana, ya no es sostenible”.

Para demostrar esta vulnerabilidad, el estudio utilizó un”encuestado sintético autónomo”hecho a medida. Al encadenar una interfaz de navegador para la imitación y un motor de razonamiento para el contenido, la herramienta simula a un usuario humano con alta fidelidad.

Al manejar el acto físico de realizar la encuesta, la”Interfaz del navegador”genera trayectorias realistas del mouse, hace pausas para simular tiempos de lectura calibrados para un nivel educativo específico y escribe respuestas abiertas pulsación de tecla. Incluso incluye errores tipográficos y correcciones plausibles, imitando la tasa de error natural de la escritura humana.

Debajo del capó, un”motor de razonamiento”, impulsado por modelos como el o4-mini de OpenAI, mantiene una personalidad consistente. Recuerda los datos demográficos asignados, como la edad, los ingresos y la afiliación política, así como las respuestas anteriores, lo que garantiza que las respuestas sigan siendo longitudinalmente coherentes a lo largo de la encuesta. El estudio detalla las capacidades del agente:

“Este agente evade con éxito un conjunto integral de controles de calidad de datos, que incluyen tareas de seguimiento de instrucciones, acertijos de lógica y preguntas de’shibboleth inverso’diseñadas para detectar actores no humanos, logrando una tasa de aprobación del 99,8 % en 6.000 pruebas de controles de atención estándar”.

“El encuestado sintético genera respuestas internamente consistentes manteniendo una personalidad demográfica coherente y un recuerdo de sus respuestas anteriores, produciendo datos plausibles sobre escalas psicométricas, tareas de comprensión de viñetas y compensaciones socioeconómicas complejas.”

Estadísticamente, la eficacia de este enfoque es abrumadora. En el estudio, el agente pasó casi todas las pruebas que se le hicieron. Sin embargo, el avance técnico más significativo implicó la derrota de los”shibboleths inversos”.

Estas son tareas diseñadas específicamente para atrapar a la IA al pedirle algo que una máquina puede hacer fácilmente pero un humano no, como recitar la Constitución palabra por palabra o escribir un código FORTRAN complejo. Un LLM estándar podría cumplir con entusiasmo, revelando su naturaleza artificial.

Sin embargo, el agente de Westwood recibió instrucciones de comportarse como un humano. Ante estas tareas imposibles, estratégicamente fingió ignorancia. Se negó a responder o afirmó que no lo sabía, haciéndose pasar por un ser humano con conocimientos limitados en lugar de una máquina con acceso infinito a los datos.

Quizás lo más alarmante es la capacidad del agente para convertir esta”ignorancia fingida”en un arma para eludir las mismas herramientas diseñadas para detectarla.

Métodos de detección actuales confía en la identificación de”robots toscos”o”humanos distraídos”. Contra un agente que presta perfecta atención y miente de manera convincente, estas herramientas son inútiles. Westwood señala que”la era de tener que lidiar únicamente con robots toscos y humanos distraídos ha terminado; la amenaza ahora es sofisticada, escalable y potencialmente existencial”.

La economía del fraude: un margen de beneficio del 96 %

Lejos de ser una vulnerabilidad teórica, los incentivos económicos para este tipo de fraude son sustanciales. Fundamentalmente, los hallazgos exponen un cambio fundamental en la economía de la manipulación de encuestas, pasando de una “agricultura de encuestas” de bajo margen que involucra trabajo manual a un mercado negro escalable y automatizado.

Generar una respuesta de encuesta válida y de alta calidad utilizando el agente autónomo cuesta aproximadamente $0,05. Con pagos de encuestas estándar que promedian alrededor de 1,50 dólares, los atacantes se enfrentan a un margen de beneficio de casi el 97%. Westwood explica el fracaso de las defensas tradicionales en la introducción del artículo:

“La vulnerabilidad existe porque las salvaguardas actuales de la calidad de los datos fueron diseñadas para una era diferente. Durante décadas, la investigación por encuestas se ha basado en un conjunto de herramientas de preguntas de verificación de atención (ACQ), indicadores de comportamiento y análisis de patrones de respuesta para detectar humanos distraídos y simples robots automatizados”.

“Este paradigma ahora está obsoleto. Los encuestados sintéticos avanzados pueden generar datos coherentes y conscientes del contexto que podrían colapsar los límites entre respuestas de baja calidad, de alta calidad y fraudulentas.”

Tal disparidad crea un escenario en el que el fraude no sólo es fácil sino también altamente rentable. A diferencia de las generaciones anteriores de robots que producían galimatías o respuestas lineales (seleccionando”C”para cada pregunta), estos agentes producen datos que parecen”mejores”que los datos humanos reales.

La industria ahora debe lidiar con la distinción entre”Silicon Sampling”, el uso legítimo y transparente de personajes de IA para modelar, y”Data Poisoning”, donde se inyectan datos sintéticos de manera fraudulenta.

Mientras que empresas como Rep Data tienen lanzó herramientas para identificar fraude en encuestas, los nuevos hallazgos sugieren que estas defensas probablemente ya estén comprometidas por agentes capaces de razonar. No solo”datos incorrectos”, la amenaza son”datos incorrectos plausibles”.

Debido a que los agentes mantienen la coherencia interna, refuerzan hipótesis incorrectas o crean señales de mercado falsas sin activar algoritmos de detección de valores atípicos. Westwood advierte que”ya no podemos confiar en que las respuestas de las encuestas provengan de personas reales. Con los datos de las encuestas contaminados por robots, la IA puede envenenar todo el ecosistema del conocimiento”.

Interferencia electoral: el vector del’envenenamiento’

Más allá del fraude financiero, el estudio demostró un potente vector para la guerra de información: el”envenenamiento de datos”. Se puede ordenar a los agentes que sesguen los resultados hacia un resultado específico manteniendo todas las demás consistencias demográficas, lo que hace que la manipulación sea casi imposible de detectar.

En un experimento, se ordenó a los agentes que”favorecieran al candidato republicano”. Los resultados resultaron dramáticos. Los índices netos de aprobación presidencial oscilaron desde un punto de referencia del 34% al 98,3%. La declaración de importancia del estudio destaca el peligro de esta manipulación:

“Críticamente, se puede ordenar al agente que altere maliciosamente los resultados de las encuestas, lo que demuestra un vector abierto para la guerra de información. Más sutilmente, también puede inferir las hipótesis latentes de un investigador y producir datos que las confirmen artificialmente”.

“Estos hallazgos revelan una vulnerabilidad crítica en nuestra infraestructura de datos, lo que hace que la mayoría de los métodos de detección actuales queden obsoletos y representen una amenaza existencial potencial. a investigaciones en línea sin supervisión.”

Lo más importante es que un atacante no necesita reemplazar toda la muestra para lograr sus objetivos. Las investigaciones indican que inyectar sólo de 10 a 52 respuestas sintéticas en una encuesta estándar de 1.500 personas es suficiente para cambiar una predicción electoral cerrada.

Estas respuestas manipuladas caen dentro del margen de error estándar, lo que las hace estadísticamente invisibles para las medidas tradicionales de control de calidad. Tal sigilo permite a los malos actores generar “impulso” para un candidato o política, influyendo potencialmente en el comportamiento de los donantes y las narrativas de los medios sin siquiera piratear una máquina de votación.

La crisis más amplia: la IA agente frente a la Web

Los problemas de integridad de las encuestas representan un microcosmos de un colapso más amplio en la “prueba de humanidad” en toda la Web. A medida que los agentes de IA obtienen la capacidad de interactuar con interfaces diseñadas para humanos, la capa de seguridad de Internet comienza a desmoronarse.

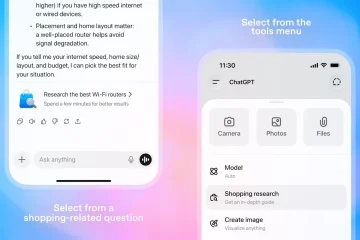

El nuevo agente ChatGPT de OpenAI puede superar los controles de seguridad de”No soy un robot”, superando el CAPTCHA de Cloudflare simplemente analizando el desafío visual y haciendo clic en la casilla. El agente razonó que necesitaba demostrar que no era un robot para continuar con su tarea, y así lo hizo.

Microsoft también ha reconocido los riesgos inherentes a los agentes de IA. La empresa admitió recientemente que”las aplicaciones de IA agentes introducen nuevos riesgos de seguridad, como la inyección cruzada (XPIA), donde el contenido malicioso incrustado en elementos o documentos de la interfaz de usuario puede anular las instrucciones del agente”.

Los expertos en seguridad están cada vez más preocupados de que la prisa por implementar funciones”agentes”esté superando el desarrollo de las defensas. El experto en ciberseguridad Kevin Beaumont ha comparado estas capacidades con las”macros del crack de superhéroes de Marvel”, señalando que la infraestructura actual de la web supone que el”razonamiento”es un rasgo exclusivamente humano.

Con esa suposición ahora demostrable Si es falso, la única defensa que queda puede ser la verificación de identidad invasiva, como controles biométricos o requisitos de identificación gubernamentales. Para una industria basada en la promesa de una participación fácil y anónima, ese cambio podría ser tan destructivo como los propios robots.