Menos de cuatro meses después de presentar su Segment Anything Model 2 centrado en video, Meta lanzó SAM 3 y SAM 3D, implementando inmediatamente los modelos avanzados de visión por computadora en productos de consumo como Facebook Marketplace e Instagram.

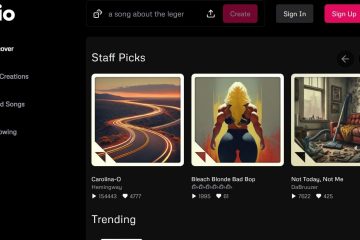

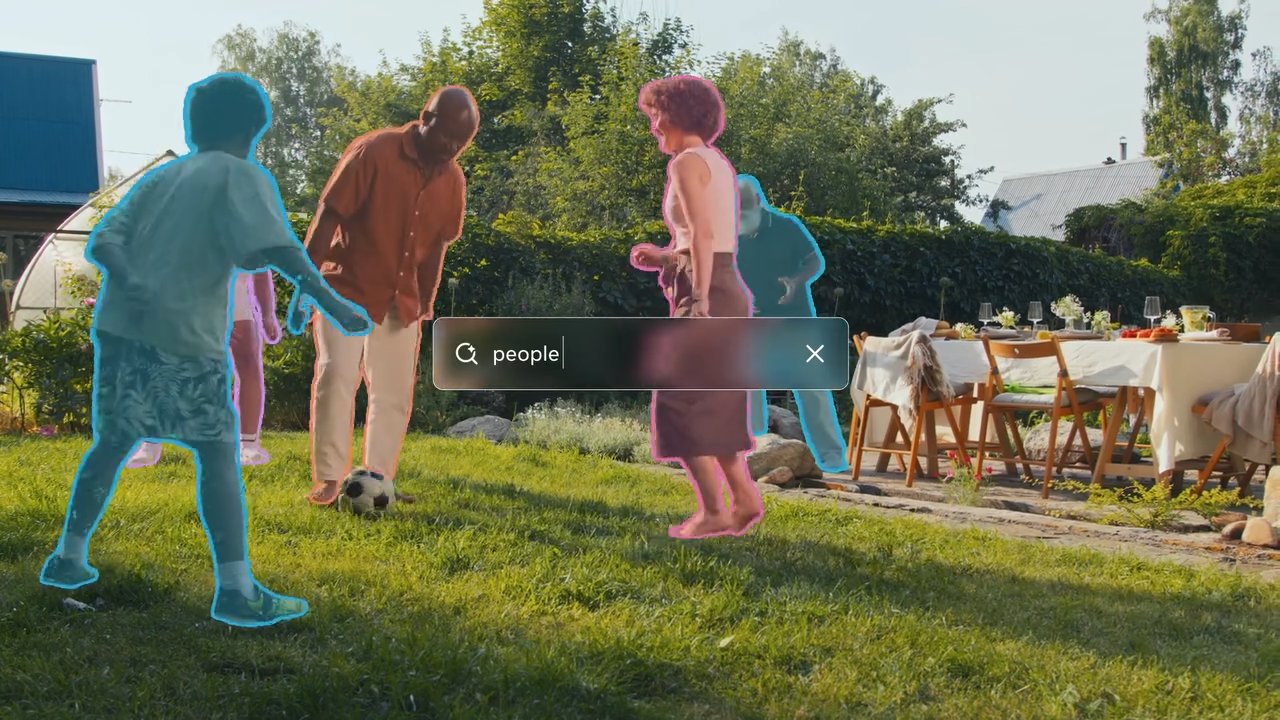

Ambas herramientas brindan a las computadoras una comprensión mucho mejor de lo que están mirando. SAM 3 permite a los usuarios escribir una descripción y hacer que la IA encuentre y resalte instantáneamente cada objeto coincidente en una foto o video.

SAM 3D va un paso más allá al tomar una imagen plana bidimensional y predecir cómo se verá el objeto desde otros ángulos, convirtiendo efectivamente una foto estándar en un modelo 3D giratorio.

Si bien las iteraciones anteriores se mantuvieron en gran medida dentro del dominio de investigación, esta actualización marca un cambio rápido hacia la utilidad aplicada, impulsando funciones que permiten a los usuarios visualizar muebles en sus hogares o aplicar efectos a objetos específicos en videos.

Los nuevos modelos presentan el “Concepto Promptable”. Segmentación”, que permite la identificación basada en texto de todos los objetos coincidentes en una escena y la reconstrucción 3D de alta fidelidad a partir de imágenes 2D únicas: capacidades que, según Meta, superan los puntos de referencia existentes por un amplio margen.

El lanzamiento de SAM 2 en 2024 se centró en gran medida en la eficiencia de la segmentación de video, pero el anuncio de hoy amplía significativamente el alcance para incluir la comprensión semántica y la generación 3D.

De la investigación al producto: inmediato Integración

Rompiendo con el ciclo tradicional de investigación a producto, Meta está evitando la típica fase de incubación para integrar SAM 3 directamente en sus aplicaciones emblemáticas.

Los usuarios de Facebook Marketplace ahora encontrarán una función”Ver en la habitación”impulsada por SAM 3D, que permite a los compradores potenciales visualizar cómo se verían los muebles dentro de sus propios espacios antes de comprometerse con una compra.

Esta aplicación aprovecha la capacidad del modelo para reconstruir. Objetos 3D a partir de imágenes 2D únicas, lo que aborda un punto de fricción común en el comercio en línea.

Al mismo tiempo, la aplicación”Edits”de Instagram y la función”Vibes”dentro de Meta AI están utilizando SAM 3 para permitir efectos de video precisos y específicos de cada objeto. Los creadores ahora pueden aplicar modificaciones como iluminación o rastros de movimiento a sujetos específicos dentro de un cuadro de video, tareas que antes requerían enmascaramiento complejo en software de edición profesional.

Ver en Threads

Al automatizar estos procesos, Meta pretende convertir en productos básicos los efectos visuales avanzados, haciéndolos accesibles como utilidades estándar para usuarios ocasionales.

Para facilitar una experimentación más amplia, la compañía ha lanzado “Segment Anything”. Playground”, una interfaz basada en web que permite al público probar estos modelos sin experiencia técnica.

Los usuarios pueden cargar imágenes o vídeos y solicitar al sistema descripciones de texto para ver las capacidades de segmentación en tiempo real. Esta estrategia contrasta marcadamente con el lanzamiento de SAM 2, que siguió siendo principalmente una herramienta para la comunidad de investigación de visión por computadora.

La implementación inmediata en aplicaciones de consumo sugiere un giro estratégico para aprovechar los avances de la IA para la retención y participación de los usuarios en todo el ecosistema social de Meta.

Salto técnico: segmentación de conceptos y 3D

SAM 3 introduce una capacidad importante denominada”Segmentación de conceptos promptable”(PCS). A diferencia de sus predecesores, que se centraban en segmentar objetos individuales basándose en indicaciones visuales como clics o cuadros, SAM 3 puede identificar y enmascarar todas las instancias de un concepto descrito por texto.

Por ejemplo, un usuario puede indicar al modelo una”gorra de béisbol roja”y segmentará cada elemento coincidente en el marco. Este cambio requiere que el modelo posea comprensión semántica del texto y capacidades de localización precisas.

Para lograr esto, la arquitectura desacopla el reconocimiento de la localización mediante un”token de presencia”. Este mecanismo primero determina si existe un concepto dentro del marco antes de que el modelo intente segmentarlo, lo que reduce los falsos positivos y mejora la precisión general de la detección.

Según el Meta Research Team,”SAM 3 duplica la precisión de los sistemas existentes en PCS de imagen y video, y mejora las capacidades SAM anteriores en tareas de segmentación visual”.

Este enfoque dual permite al modelo manejar consultas complejas mientras mantiene un alto rendimiento en tareas de segmentación estándar.

Meta Sam 3 Segmenta cualquier cosa con Conceptos

En la generación 3D, SAM 3D permite la reconstrucción de objetos y escenas a partir de una única imagen 2D, una tarea que tradicionalmente requería múltiples puntos de vista o datos de profundidad. Meta afirma que este nuevo modelo supera significativamente a los métodos existentes.

El equipo de Meta AI señala que”en las pruebas de preferencia humana cara a cara, logra al menos una tasa de victoria de 5:1 sobre otros modelos líderes”. Esto es particularmente relevante para aplicaciones de realidad aumentada y juegos, donde la generación rápida de activos es crucial.

Ver en Threads

Las métricas de rendimiento publicadas por Meta indican que SAM 3 es altamente eficiente. El Meta Research Team también afirma que”SAM 3 se ejecuta en 30 milisegundos para una sola imagen con más de 100 objetos detectados en una GPU H200″. Esta velocidad es esencial para aplicaciones en tiempo real en dispositivos de consumo, donde la latencia puede degradar la experiencia del usuario.

Para la reconstrucción humana, SAM 3D Body utiliza un nuevo formato de código abierto.

“SAM 3D Body… aprovecha un nuevo formato de malla 3D de código abierto llamado Meta Momentum Human Rig (MHR), que ofrece una interpretabilidad mejorada al separar la estructura esquelética y la forma del tejido blando”.

Esta separación permite una mayor realismo y ajuste modelos humanos, lo que podría tener implicaciones para los avatares virtuales y la animación.

A pesar de estos avances, el modelo no está exento de limitaciones. El equipo de Meta AI admite que”SAM 3 tiene dificultades para generalizar a conceptos detallados fuera del dominio de manera inmediata, como identificar términos específicos que requieren conocimiento del dominio como’plaquetas'”.

Esto sugiere que, si bien el modelo es sólido para objetos comunes, puede requerir ajustes finos o datos adicionales para manejar categorías especializadas o raras de manera efectiva.

Motor de datos y evaluación comparativa

Aprovechando Como motor de datos híbrido, Meta pudo escalar significativamente sus datos de entrenamiento. La empresa desarrolló un sistema que utiliza”anotadores de IA”basados en Llama para verificar máscaras y verificar la exhaustividad, una tarea que sería prohibitivamente lenta para los humanos solos.

Meta explica que”al delegar ciertas tareas a anotadores de IA (modelos que igualan o superan la precisión humana) duplicamos con creces el rendimiento en comparación con un canal de anotaciones solo para humanos”.

Este enfoque permitió la creación del conjunto de datos SA-Co, que contiene más de 4 millones de conceptos únicos y 52 millones de máscaras, lo que proporciona un rico campo de entrenamiento para los nuevos modelos.

Junto con los modelos, Meta ha lanzado el punto de referencia”Segmentar cualquier cosa con conceptos”(SA-Co). Este conjunto de datos presenta 207.000 conceptos únicos diseñados para probar capacidades de reconocimiento de vocabulario abierto, impulsando el estándar de evaluación de la industria.

El motor de datos también extrae de forma iterativa”negativos duros”(frases que no existen en una imagen pero que son adversas al modelo) para mejorar la solidez contra los falsos positivos.

Más allá de las aplicaciones de consumo, la tecnología está encontrando aplicaciones en la investigación científica. Una asociación con Conservation X Labs aplicó SAM 3 al conjunto de datos SA-FARI, ayudando en el monitoreo automatizado de la vida silvestre a través de segmentación de video. Este caso de uso demuestra la utilidad potencial del modelo en el procesamiento de grandes volúmenes de datos de vídeo no seleccionados con fines de investigación.

El lanzamiento incluye pesos de modelo, código y conjuntos de datos de evaluación, continuando la estrategia de Meta de abrir tecnologías clave de IA. Al hacer que estas herramientas estén disponibles, Meta tiene como objetivo establecer estándares de la industria y fomentar un mayor desarrollo dentro de la comunidad de IA.

El trabajo futuro se centrará en mejorar la capacidad del modelo para manejar consultas de razonamiento complejas combinando SAM 3 con modelos de lenguaje grande multimodal (MLLM), lo que potencialmente permitirá interacciones aún más sofisticadas.