Microsoft, NVIDIA y Anthropic han formado una alianza que remodelará el mercado de la IA. En un acuerdo revelado el martes, Anthropic acordó gastar 30 mil millones de dólares en capacidad de nube de Microsoft Azure. Al mismo tiempo, NVIDIA y Microsoft invertirán un total combinado de 15.000 millones de dólares en la startup.

NVIDIA aportará 10.000 millones de dólares, mientras que Microsoft aportará 5.000 millones de dólares. La integración lleva los modelos Claude de Anthropic directamente a Azure, respaldando el plan de Microsoft de ofrecer diversas herramientas de inteligencia artificial. El acceso a dicha capacidad proporciona a Anthropic la potencia bruta necesaria para construir sus próximos grandes modelos.

Un compromiso de 30 mil millones de dólares con Azure

Anthropic se ha comprometido a comprar 30 mil millones de dólares en créditos informáticos durante la próxima década, una cifra que subraya los costos astronómicos asociados con el desarrollo de inteligencia artificial de vanguardia.

Más allá del compromiso monetario, el acuerdo incluye una disposición específica para que Anthropic contrate capacidad informática adicional de hasta un gigavatio, lo que garantiza que la startup tenga acceso garantizado a la energía y potencia de procesamiento necesarios para capacitar a los sucesores de su generación de modelos actual.

La arquitectura financiera del acuerdo crea un circuito simbiótico de liquidez entre los socios. Según los términos del acuerdo, la inyección de capital de 15 mil millones de dólares, dividida entre los 10 mil millones de dólares de NVIDIA y los 5 mil millones de dólares de Microsoft, proporciona el capital inmediato necesario para financiar esta infraestructura. desarrollo.

Esencialmente, una parte significativa del capital que Microsoft está invirtiendo en Anthropic regresará a su propia división Azure como ingresos, lo que ayudará a subsidiar los enormes gastos de capital necesarios para construir nuevos centros de datos.

Esta estructura refleja acuerdos similares que Microsoft ha utilizado con OpenAI, asegurando efectivamente un inquilino ancla a largo plazo para sus clústeres de supercomputación en expansión.

Esta realineación estratégica marca un giro decisivo desde La estrategia de infraestructura anterior de Anthropic, que hasta ahora dependía en gran medida de Amazon Web Services (AWS) como su principal proveedor de nube.

Si bien la compañía mantiene su relación existente con Amazon, la magnitud del compromiso con Azure indica la adopción de una estrategia de facto de doble nube. Al diversificar su base informática, Anthropic mitiga el riesgo de dependencia de proveedores y garantiza la redundancia en las dos plataformas de nube más grandes del mundo.

Según Microsoft, este movimiento convierte a Claude en la única familia de modelos de vanguardia disponible en los tres servicios de nube más destacados del mundo, lo que le otorga una ventaja de distribución única sobre los competidores vinculados exclusivamente a un único socio de infraestructura.

La medida está impulsada por los crecientes requisitos de infraestructura para entrenar modelos de próxima generación, que ahora demandan grupos de decenas de miles de GPU que operan en conjunto.

Al asegurar el acceso prioritario a la arquitectura de supercomputación avanzada de Azure, que incluye los últimos sistemas NVIDIA Grace Blackwell y Vera Rubin, Anthropic garantiza que puede seguir siendo competitivo frente a GPT-5 de OpenAI y Gemini de Google.

Para Microsoft, el acuerdo valida su agresiva expansión del centro de datos, incluidos proyectos recientes para construir supercomputadoras masivas de IA, al demostrar que existe una demanda sostenida y de alto valor. para dicha capacidad más allá de sus propias necesidades internas.

La cobertura de $10 mil millones de NVIDIA

La participación de NVIDIA agrega una capa compleja a la alianza. Al invertir 10 mil millones de dólares, el director ejecutivo Jensen Huang está financiando efectivamente al principal competidor de su otro socio importante, OpenAI. El objetivo aquí es dominar el mercado; la medida garantiza la demanda de GPU Blackwell y Rubin independientemente de qué familia de modelos domine la capa de software.

Sin embargo, la asociación une a ejecutivos con puntos de vista históricamente divergentes. Hace sólo unos meses, Huang y el director ejecutivo de Anthropic, Dario Amodei, se enfrentaron públicamente por el impacto social de la IA. Amodei ha advertido frecuentemente sobre riesgos catastróficos, mientras que Huang ha descartado tales preocupaciones como alarmistas.

El dinero parece haber salvado esa división filosófica. La alineación estratégica garantiza que los clústeres de Anthropic se construirán sobre la última arquitectura de NVIDIA en lugar de silicio personalizado de Google o Amazon.

Para NVIDIA, se trata de una jugada defensiva contra el auge de los chips propietarios, lo que garantiza que su hardware siga siendo el estándar de la industria tanto para el entrenamiento como para la inferencia.

Nativo en Azure: un pivote técnico

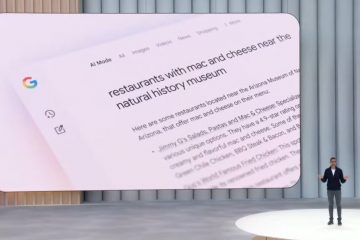

Si bien las integraciones anteriores dependían de llamadas API enrutadas a hosts externos, las noticias de hoy confirma una unificación técnica más profunda. En septiembre, Microsoft 365 Copilot comenzó a ofrecer Claude a través de API estándar alojadas en AWS. Esa configuración permitió a los usuarios acceder a los modelos, pero los datos aún tenían que atravesar los límites de la nube.

Ahora, Anthropic está escalando sus modelos de forma nativa en la infraestructura de Azure. Los desarrolladores que utilicen Microsoft Foundry y Azure AI Agent Service tendrán acceso a Claude Sonnet 4.5, Claude Opus 4.1 y Claude Haiku 4.5 ejecutándose directamente en los centros de datos de Microsoft. Como resultado, se espera que la latencia disminuya significativamente.

Los clientes empresariales también pueden aplicar los controles de cumplimiento y seguridad de Azure de manera más efectiva cuando los pesos del modelo residen en la plataforma. Este alojamiento nativo es fundamental para el agente”Investigador”en Microsoft 365, que realiza tareas complejas de razonamiento de varios pasos.

Charles Lamanna, presidente de Business & Industry Copilot de Microsoft, enfatizó esta flexibilidad durante la integración inicial:”Copilot seguirá funcionando con los últimos modelos de OpenAI y ahora nuestros clientes también tendrán la flexibilidad de usar modelos Anthropic”.

Además, la integración aprovecha el protocolo de contexto modelo. (MCP), un estándar abierto desarrollado conjuntamente por las dos empresas. Este protocolo estandariza la forma en que los agentes de IA se conectan a los datos, lo que permite a Claude interactuar sin problemas con el vasto ecosistema empresarial de Microsoft.

Fortificar el foso multimodelo

Microsoft está ejecutando agresivamente su estrategia de”foso multimodelo”. Al albergar tanto OpenAI como Anthropic, Satya Nadella posiciona a Azure como la utilidad neutral para la era de la IA.

La diversificación de la cartera protege a Redmond de depender demasiado de un solo proveedor, un riesgo que se hizo evidente durante la agitación del liderazgo de OpenAI el año pasado.

Esta diversificación se produce justo después de que Microsoft resolvió una disputa contractual crítica con OpenAI con respecto a la”cláusula del fin del mundo de AGI”. Esa disposición original de 2019 podría haber permitido a OpenAI cortar el acceso de Microsoft al lograr la Inteligencia Artificial General.

Con esa amenaza legal neutralizada, Redmond es libre de reforzar a los rivales de OpenAI sin temer un incumplimiento de contrato.

A pesar de la nueva competencia, el CEO de Microsoft AI, Mustafa Suleyman, declaró en agosto que “nuestro objetivo es profundizar la asociación y asegurarnos de que tengamos una gran colaboración con OpenAI durante muchos, muchos años por venir. venir”, sugiriendo una estrategia de diversificación en lugar de reemplazo.

La estrategia es aditiva en lugar de sustractiva, lo que garantiza que Microsoft tenga participación en cada avance importante en IA. Al reconocer que ningún modelo supera todos los puntos de referencia, Microsoft ha optado por ofrecer la”mejor herramienta para el trabajo”. Los usuarios podrán cambiar entre los modelos OpenAI y Anthropic.

Esta capacidad es particularmente relevante para el agente”Investigador”, que analiza datos web y archivos internos para crear estrategias. Los usuarios ahora pueden alternar entre el amplio conocimiento de GPT-5 y el razonamiento especializado de Claude según la tarea.

OpenAI sigue siendo una entidad formidable por derecho propio. Tras su reestructuración, la organización. Como señaló el presidente de OpenAI, Bret Taylor, esa valoración la convierte en”una de las organizaciones filantrópicas con mayores recursos del mundo”. Al final, Azure gana en cualquier caso. Ya sea que una empresa elija GPT-5 o Claude Opus 4.1, los ingresos por computación fluyen hacia Microsoft.