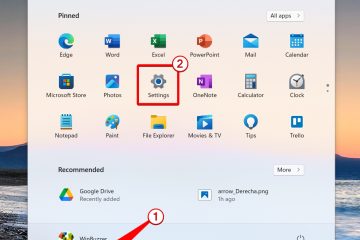

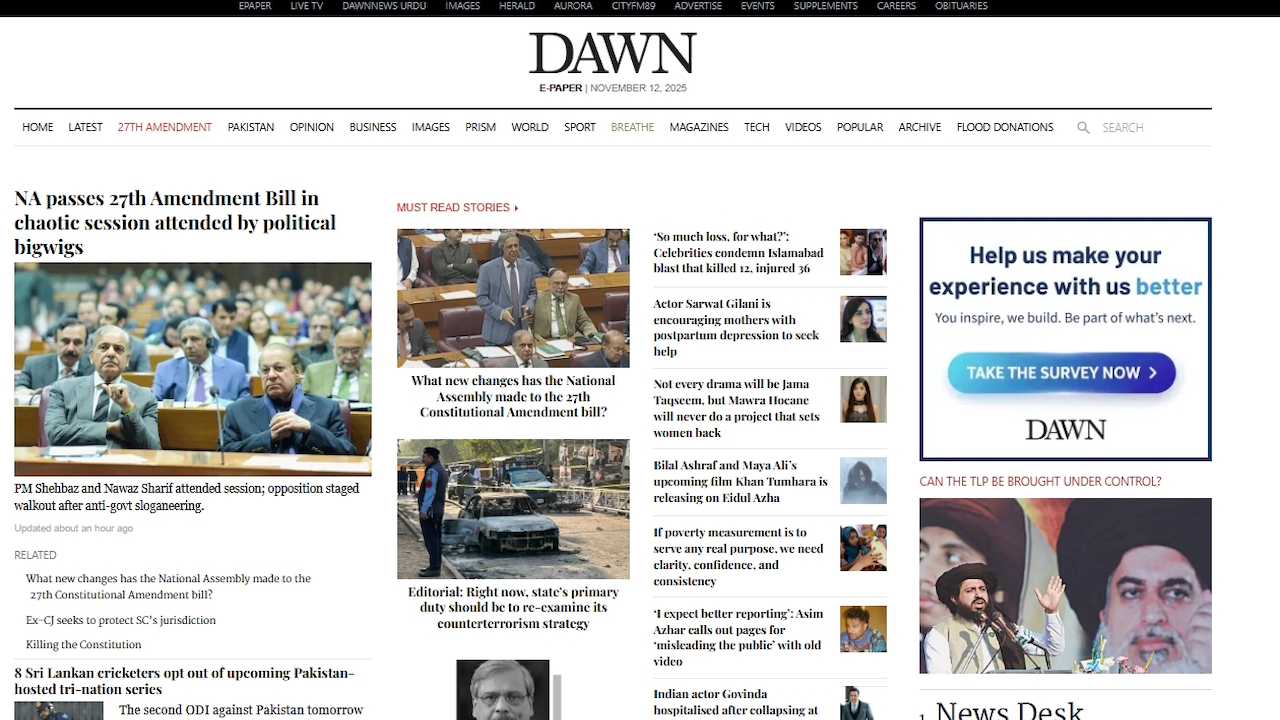

Un periódico paquistaní ha destacado el creciente problema de la producción de IA no examinada después de que imprimiera por error texto hablado de un chatbot. En su edición del 12 de noviembre, Dawn incluyó un mensaje generado por IA para hacer que el artículo obviamente generado fuera”más ágil”, lo que obligó a una disculpa pública por romper sus propias reglas.

Este error no es un caso aislado sino parte de una tendencia más amplia de fallas de la IA. Desde fuentes legales falsas utilizadas en los tribunales hasta informes gubernamentales defectuosos, la prisa por adoptar la IA generativa sin una cuidadosa revisión humana está erosionando la confianza del público. Es una tendencia que crea serios problemas en el mundo real para las principales instituciones.

“¿Quieres que haga eso ahora?”: El error público de la IA de un periódico

El muy respetado periódico en inglés de Pakistán, Dawn, publicó un artículo sobre las ventas de automóviles que terminó con una posdata extraña generada por una máquina. En lugar de un párrafo final, el artículo presentaba una pieza clásica de chatbot.

La IA preguntó a su usuario: “Si quieres, también puedo crear una versión de “estilo de portada” aún más ágil con estadísticas impactantes de una sola línea y un diseño atrevido, listo para infografías: perfecto para lograr el máximo impacto en el lector. ¿Quieres que haga eso a continuación?“

Sé que los periodistas están usando IA en su trabajo, ¡pero esto es demasiado!

¡El escritorio de Dawn Business Pages debería haber editado al menos el último párrafo!

😆😆😆 pic.twitter.com/JWNdHNWvnv

— omar r quraishi (@omar_quraishi) 12 de noviembre de 2025

Detectado rápidamente por los lectores, el error se extendió rápidamente en línea, lo que obligó al periódico a emitir una corrección y una declaración formal. disculpa. En una nota adjunta a la versión en línea del artículo, el editor admitió: “Este informe periodístico fue editado originalmente utilizando IA, lo que viola la política actual de IA de Dawn… Se lamenta la violación de la política de IA”.

Se informa que se está llevando a cabo una investigación sobre el incidente. Las Las pautas oficiales del periódico prohíben explícitamente el uso de IA para generar o editar noticias sin una supervisión humana rigurosa.

Si bien la metedura de pata de Dawn provocó un momento de vergüenza pública, sirve como un símbolo potente de un problema mucho más profundo y con mayores consecuencias. En todas las industrias, el despliegue prematuro de la IA generativa sin una supervisión adecuada está dando lugar a una serie de fallas de alto perfil, que socavan los estándares profesionales y la confianza pública.

Un problema sistémico: cuando la IA alucina en campos de alto riesgo

En todos los campos profesionales, desde el derecho hasta la salud pública, las organizaciones están descubriendo por las malas que no se pueden confiar tareas críticas a grandes modelos lingüísticos. Conocido como alucinación, el fenómeno en el que una IA inventa con confianza hechos, fuentes o datos está demostrando ser un defecto persistente y peligroso.

Un ejemplo reciente y costoso proviene del mundo de la consultoría. La firma global Deloitte se vio obligada a reembolsar 97.000 dólares al gobierno australiano después de que se descubrió que un informe de 440.000 dólares que produjo estaba plagado de citas fabricadas por IA.

Su informe, una revisión sensible del sistema de bienestar de la nación, citaba libros inexistentes y casos legales mal citados. La senadora laborista australiana Deborah O’Neill ofreció una dura reprimenda, afirmando:”Deloitte tiene un problema de inteligencia humana. Esto sería ridículo si no fuera tan lamentable”.

También están apareciendo problemas agudos en el sector público. En julio, surgieron informes de que la nueva IA”Elsa”de la Administración de Alimentos y Medicamentos de EE. UU., destinada a acelerar la aprobación de medicamentos, estaba fabricando estudios médicos inexistentes.

Un frustrado empleado de la FDA describió la herramienta a CNN como poco confiable, afirmando que”alucina con seguridad”, mientras que otro se lamentó:”Pierdo mucho tiempo adicional solo debido a la mayor vigilancia que debo tener”.

Del mismo modo, los abogados porque la firma de inteligencia artificial Anthropic tuvo que disculparse formalmente ante un juez después de que su propio Claude AI inventara una cita legal utilizada en un expediente judicial.

El periodismo, en particular, ha visto repetidos casos de esta supervisión. En un caso sorprendentemente similar de octubre, la revista alemana Der Spiegel tuvo que corregir un artículo que incluía una frase perdida generada por IA que ofrecía cambiar el tono del texto.

Estos errores garrafales no están limitados a granjas de contenido de bajo nivel, pero están apareciendo en medios de comunicación respetados y establecidos, lo que pone de relieve una falla sistémica en los flujos de trabajo editoriales.

Estos no son incidentes aislados. Un estudio internacional histórico coordinado por la BBC y la Unión Europea de Radiodifusión (UER) reveló la naturaleza sistémica de esta falta de confiabilidad.

Después de evaluar más de 3000 respuestas, sus hallazgos mostraron que los asistentes de IA producen errores significativos en el 45% de las respuestas relacionadas con noticias. Como explicó el Director de Medios de la EBU, Jean Philip De Tender,”Esta investigación muestra de manera concluyente que estas fallas no son incidentes aislados. Son sistémicas, transfronterizas y multilingües, y creemos que esto pone en peligro la confianza del público”.

Erosión de la confianza: el costo en el mundo real de la caída descontrolada de la IA

Un goteo constante de información errónea generada por la IA está infligiendo un daño tangible al ecosistema de la información digital. Para plataformas fundacionales como Wikipedia, las consecuencias se están volviendo existenciales.

La Fundación Wikimedia informó recientemente una sorprendente disminución del 8% en el tráfico humano, culpando directamente a las herramientas de búsqueda de inteligencia artificial y a los chatbots por desviar visitantes al resumir su contenido sin atribución.

Tal tendencia amenaza el modelo impulsado por voluntarios de la enciclopedia. Como advirtió el Director Senior de Producto de Wikimedia, Marshall Miller,”Con menos visitas a Wikipedia, menos voluntarios pueden crecer y enriquecer el contenido, y menos donantes individuales pueden apoyar este trabajo”.

Internamente, la plataforma ya está librando una batalla contra los envíos generados por IA, que un voluntario describió como una”amenaza existencial”, lo que llevó a la comunidad a adoptar una política de’eliminación rápida’para eliminar lo peor de la basura.

Estos se repiten En última instancia, los fracasos dan una lección crítica sobre el estado actual de la IA. La responsabilidad de los errores no se puede descargar en la máquina.

Como señaló la ex jefa científica de decisiones de Google, Cassie Kozyrkov, después de que un robot de soporte para el editor de código Cursor AI inventara una política corporativa falsa, “Este desastre podría haberse evitado si los líderes hubieran entendido que (1) la IA comete errores, (2) la IA no puede asumir la responsabilidad de esos errores (por lo que recaen sobre usted) y (3) los usuarios odian ser engañados por una máquina que se hace pasar por un humano”.

¿Qué Lo que sucedió en Dawn es simplemente el último recordatorio de que en la era de la IA, la última e indispensable capa de control de calidad sigue siendo la diligente supervisión humana.