Los investigadores de Microsoft han detallado un nuevo ataque de canal lateral llamado”Whisper Leak”que puede adivinar el tema de los chats de IA cifrados, exponiendo un riesgo de privacidad fundamental en toda la industria de la IA.

En un informe, el equipo mostró cómo los patrones en el tamaño y el tiempo del tráfico de la red pueden revelar lo que los usuarios están discutiendo, incluso con TLS cifrado. La falla afecta a 28 modelos principales de IA, lo que crea un grave riesgo de privacidad para los usuarios de todo el mundo. Un observador en una red podría detectar conversaciones delicadas sobre temas legales o de salud.

Después de un proceso de divulgación que comenzó en junio, los principales proveedores como OpenAI y Microsoft comenzaron a implementar correcciones, pero el problema apunta a un riesgo central en la transmisión de IA.

Cómo Whisper Leak Escuchas furtivas en chats de IA cifrados

El ingenio del ataque radica en su capacidad de funcionar sin romper el cifrado TLS subyacente que protege las comunicaciones en línea. En su lugar, explota los metadatos que el cifrado deja inherentemente expuestos.

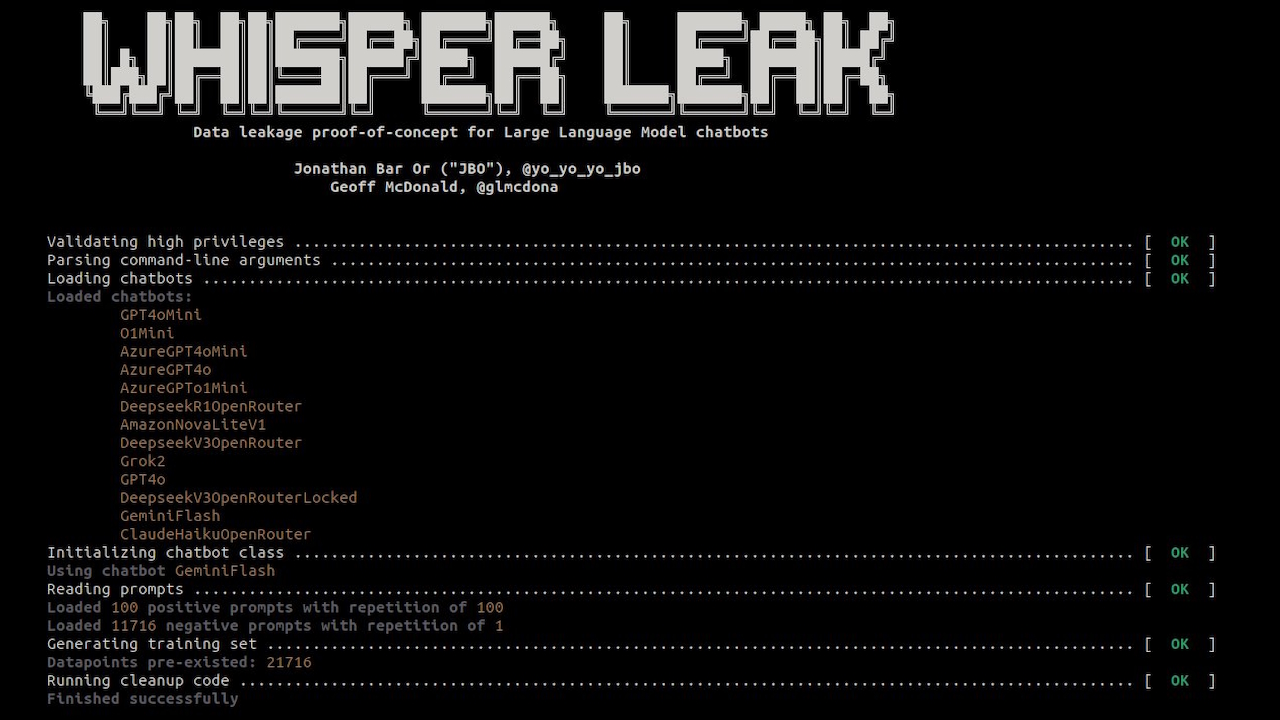

Según la documentación del proyecto, “Whisper Leak es un conjunto de herramientas de investigación que demuestra cómo las conversaciones cifradas y transmitidas con modelos de lenguaje grandes filtran información rápida a través del tamaño y el tiempo de los paquetes”.

El método evita la seguridad del contenido centrándose en la forma y el ritmo del flujo de datos.

Las respuestas LLM, generadas token por token, crean secuencias únicas de datos paquetes cuando se transmiten a un usuario. Cada tema, desde el análisis legal hasta la conversación informal, genera texto con vocabulario y estructuras de oraciones distintas. Estos patrones lingüísticos producen una”huella digital”característica en el tráfico de la red.

Analizando secuencias de tamaños de paquetes y tiempos entre llegadas, los investigadores crearon clasificadores para reconocer estas huellas digitales con alta precisión.

El conjunto de herramientas públicas del proyecto lo confirma método, que utiliza modelos de aprendizaje automático para aprender las firmas sutiles de diferentes tipos de conversaciones. Incluso con contenido codificado, los patrones de tráfico traicionan el tema de la conversación.

Una falla en toda la industria que afecta a 28 modelos principales de IA

Whisper Leak no es un error aislado sino una vulnerabilidad sistémica que afecta a una amplia franja de la industria de la IA. El equipo de Microsoft probó 28 LLM disponibles comercialmente y descubrió que la mayoría eran altamente susceptibles.

Para muchos modelos, el ataque logró una clasificación casi perfecta. Los investigadores señalaron en una publicación de blog:”Esto nos dice que las’huellas digitales’únicas que dejan las conversaciones sobre un tema específico son lo suficientemente distintas como para que nuestro espía impulsado por IA pueda detectarlas de manera confiable en una prueba controlada”.

Para las empresas que dependen de la IA para comunicaciones sensibles, los hallazgos representan un vector de amenaza nuevo y desafiante. La investigación demostró una precisión alarmante en condiciones realistas.

En una simulación con una proporción de 10 000 a 1 de ruido de fondo para las conversaciones objetivo, el ataque identificó temas sensibles con una precisión del 100 % para 17 de los 28 modelos, al mismo tiempo que detectaba entre el 5 % y el 20 % de todas las conversaciones objetivo.

Un adversario pasivo de la red, como un ISP, una agencia gubernamental o un atacante en una red Wi-Fi pública, podría de manera confiable identificar a los usuarios que discuten asuntos legales, financieros o de salud confidenciales.

Esta capacidad convierte los chats de IA cifrados en una fuente potencial de vigilancia específica. Como afirman los investigadores,”Esta vulnerabilidad en toda la industria plantea riesgos significativos para los usuarios bajo vigilancia de red por parte de ISP, gobiernos o adversarios locales”.

Rendimiento de ataque (AUPRC) en los LLM objetivo alojados por los proveedores y conjuntos de características especificados y arquitectura del modelo de ataque. Los números más altos corresponden a una mayor efectividad del ataque del canal lateral. Las métricas se calculan como una mediana de 5 ensayos, donde se realiza una división aleatoria por ensayo. La columna”Mejor”también es la mediana de las cinco mejores pruebas de los modelos y conjuntos de características utilizados. (Fuente: Microsoft)

Una solución difícil: mitigación y respuestas inconsistentes de los proveedores

Microsoft inició un proceso de divulgación responsable en junio de 2025, notificando a los 28 proveedores afectados. Hasta noviembre, las respuestas han sido mixtas.

Si bien proveedores como OpenAI, Microsoft, Mistral y xAI tomaron medidas para corregir la falla, el informe señala que otros proveedores se negaron a implementar correcciones o no respondieron.

Este incidente resalta una inconsistencia preocupante en la forma en que la industria maneja las nuevas amenazas nativas de la IA. Esto sigue a la negativa de Google en octubre a corregir una falla crítica de”contrabando de ASCII”en sus modelos Gemini, que clasificó como un problema de ingeniería social en lugar de un error de seguridad.

También se hace eco de una reciente vulnerabilidad de filtración de datos en Claude de Anthropic, donde la compañía inicialmente desestimó el informe antes de reconocer un”error en el proceso”.

Como señaló el investigador de seguridad Johann Rehberger en ese caso,”la seguridad te protege”. de accidentes. La seguridad te protege de los adversarios.”La distinción es fundamental a medida que los agentes de IA se vuelven más autónomos y se integran con datos confidenciales.

Reparar las fugas de metadatos no es sencillo. Los investigadores evaluaron varias mitigaciones, cada una con importantes compensaciones. El relleno de datos aleatorio, que ahora implementan algunos proveedores, agrega ruido a los tamaños de los paquetes, pero solo reduce parcialmente el éxito del ataque.

Otra estrategia, el procesamiento por lotes de tokens, agrupa varios tokens antes de enviarlos, oscureciendo los patrones individuales. Si bien es efectivo en lotes de mayor tamaño, esto puede degradar la sensación de respuesta en tiempo real de un chatbot, lo que afecta la experiencia del usuario.

Una tercera opción, inyectar paquetes de”ruido”sintéticos, también puede ofuscar los patrones de tráfico. Sin embargo, este enfoque aumenta la sobrecarga del ancho de banda, una consideración de costo significativa para los proveedores.

El episodio muestra que a medida que la IA se integra más en flujos de trabajo sensibles, proteger la privacidad del usuario requiere mirar más allá del cifrado de contenido para proteger los propios patrones de comunicación digital.