El equipo QWEN de

Alibaba lanzó el martes QWEN3-coder, una nueva serie de modelos de codificación de IA de código abierto dirigidos directamente a rivales como Anthrope. Encabezado por una versión masiva de 480 mil millones de parámetros, los modelos están diseñados para el trabajo”agente”, lo que les permite manejar tareas complejas de desarrollo de software de forma autónoma.

El lanzamiento global el 22 de julio de 2025, en plataforma”> plataforma”> plataforma”/plataforma/plataforma/plataforma/plataforma/plategos como github. Un nuevo estándar para modelos abiertos. Sin embargo, el lanzamiento también llega en medio de un profundo escepticismo de la industria sobre los puntos de referencia de IA, impulsado por las recientes acusaciones de que otro de los propios modelos de Alibaba engañó a las pruebas de rendimiento clave.

bajo el capó: una potencia de codificación de agente 480b

El centropelio del lanzamiento es el qwen3-coder-480b-a35b-instruct , un modelo masivo de mezcla de experiencia (moe). Contiene 480 mil millones de parámetros totales, pero activa solo un subconjunto de 35 mil millones de parámetros para cualquier tarea dada. Esta arquitectura proporciona una potencia inmensa mientras se mantiene la eficiencia computacional.

>

La base del modelo se basó en un colosal tokens de 7.5 billones de datos de pretronante, con una relación del 70% dedicada específicamente al código. Según el equipo de Qwen, la calidad de los datos fue primordial; Aprovecharon un modelo anterior, Qwen2.5-coder, para limpiar sintéticamente y reescribir datos ruidosos para esta nueva generación.

Sus especificaciones técnicas son formidables. El modelo cuenta con una longitud nativa de contexto de 256,000 token, que puede extenderse a un millón de tokens utilizando métodos de extrapolación como el hilo. Esta vasta capacidad se adapta a la comprensión a escala de repositorio, lo que permite que la IA comprenda el contexto completo de grandes proyectos de software.

Esta conciencia contextual se combina con una amplitud increíble. El modelo admite una amplia gama de lenguajes de programación, desde opciones convencionales como C ++, Python y Java hasta idiomas especializados como ABAP, Rust y Swift, como se detalla en su

Más allá de la capacitación previa, Alibaba se centró en técnicas avanzadas posteriores a la capacitación. El equipo amplió lo que llama el aprendizaje de refuerzo de código (Código RL) en una amplia gama de tareas de codificación del mundo real. Este enfoque se basa en el principio de abordar los problemas que son”difíciles de resolver, pero fáciles de verificar”, utilizando la retroalimentación basada en la ejecución para aumentar significativamente las tasas de éxito. Para cultivar un verdadero comportamiento de agente, el equipo implementó lo que llama”Horizon RL de larga duración”. Esto requirió construir un sistema escalable en la nube de Alibaba capaz de ejecutar 20,000 entornos independientes en paralelo. Esta infraestructura proporciona el circuito de retroalimentación crucial para enseñar al modelo a planificar, usar herramientas y tomar decisiones a través de interacciones complejas de múltiples vueltas. Según los datos de rendimiento publicados por el equipo de QWEN, el nuevo modelo de codificadores QWEN3 se establece como un modelo de codificación de agente de alto nivel, logrando resultados de estado de estado abiertos. En el punto de referencia verificado SWE-Bench, una prueba clave de las capacidades de ingeniería de software del mundo real, el modelo QWEN3-Coder obtiene un impresionante 69.6% con 500 turnos de interacción. Esto lo coloca en competencia directa y casi a la par, el modelo principal, Claude-Sonnet-4, que anotó 70.4% en condiciones similares. Además, QWEN3-Coder supera significativamente a otros modelos principales en el campo, incluidos Kimi-K2 (65.4%), GPT-4.1 (54.6%) y Gemini-2.5-Pro (49.0%), cimentando a Supremacy

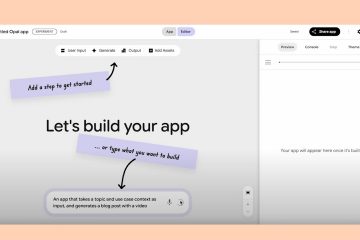

Esta liberación indica el empuje agresivo de Alibaba a la próxima frontera de IA: Inteligencia Agente. La industria se está moviendo rápidamente más allá de los simples asistentes de código a los agentes autónomos que pueden planificar, ejecutar y adaptarse a tareas complejas de desarrollo de varios pasos. QWEN3-coder no es solo un nuevo modelo; Es una entrada estratégica en esta creciente”carrera armamentista”. La tendencia ya está siendo validada en la empresa. El banco de inversiones Goldman Sachs, por ejemplo, recientemente comenzó a probar el agente de IA Devin para construir una”fuerza laboral híbrida”. Su jefe de tecnología, Marco Argenti, describió un futuro en el que”se trata realmente de que las personas y el AIS funcionen de lado a lado. Se espera que los ingenieros tengan la capacidad de describir realmente problemas de manera coherente…”Cambiando el enfoque humano de la codificación tediosa a la resolución de problemas de alto nivel. En los EE. UU., Amazon presentó recientemente a su agente de Kiro para imponer estructura a la”codificación de ambientes”caótica, mientras que Google realiza un ataque de dos puntas con su estudio integral de Firebase y un CLI Géminis libre. Operai continúa actualizando su agente Codex, recientemente dándole acceso a Internet a encontrar y usar datos autónomos. La competencia es tan intensa dentro de la”guerra de cien modelos”de China. QWEN3-Coder se coloca contra potencias de código abierto como Moonshot Ai, que recientemente lanzó su modelo Kimi K2 de 1 billón de parámetros. Esta rivalidad nacional está impulsada por las presiones geopolíticas que obligan a las empresas chinas a construir ecosistemas autosuficientes. Las altas apuestas de esta carrera son evidentes en la despiadada competencia por el talento y la tecnología. La startup de codificación Windsurf recientemente vio a Google cazar a su CEO y al máximo talento, hundiendo una adquisición de OpenAI y permitiendo que la cognición rival adquiriera la compañía restante. La batalla se extiende a la percepción pública, a menudo luchó en las tablas de clasificación. En un claro ejemplo de esta”guerra de referencia”, Xai de Elon Musk recientemente contrató contratistas específicamente para capacitar a su modelo Grok 4 para vencer a Claude de Anthrope. Los inmensos costos operativos también son un factor, como se ve cuando los límites de uso ajustados antrópicos para sus suscriptores premium, destacando la tensión financiera de proporcionar estos poderosos servicios. A pesar de sus impresionantes afirmaciones técnicas, el lanzamiento QWEN3-Coder está a la altura de la creciente creciente de fideicomiso. El momento es incómodo para Alibaba. Solo unos días antes, el 18 de julio, Un estudio de la Universidad de Fudan alegó que su modelo Qwen2.5 había”engañado”en los datos de Math-500, ya razonamiento genuino. Esta controversia resalta el problema sistémico de la contaminación de datos, donde las preguntas de prueba se filtran en conjuntos de capacitación, inflando el rendimiento y creando una falsa impresión de las verdaderas capacidades de un modelo. La comunidad de IA sigue profundamente dividida en la práctica de la”enseñanza a la prueba”. Algunos, como el CEO de Lmarena, Anastasios Angelopoulos, lo ven como una parte normal del desarrollo, afirmando:”Esto es parte del flujo de trabajo estándar de la capacitación de modelos. Necesita recopilar datos para mejorar su modelo”. Como señaló el estratega de IA Nate Jones,”en el momento en que establecemos el dominio de la tabla de clasificación como objetivo, corremos el riesgo de crear modelos que sobresalen en ejercicios triviales y platle cuando enfrentamos la realidad”. Este sentimiento se hace eco de expertos como Sara Hooker, Jefa de Cohere Labs, quien argumentó que”cuando una tabla de clasificación es importante para un ecosistema completo, los incentivos están alineados para que sean gamadas”, creando un riesgo de modelos que sean buenos en los exámenes pero pobres en tareas prácticas. Alibaba está lanzando un conjunto de herramientas junto con los modelos. La compañía ha lanzado”Qwen Code”, una interfaz de línea de comandos bifurcada desde la CLI Gemini de Google y personalizada para los nuevos modelos. Esto proporciona a los desarrolladores un entorno preparado para la codificación de agente. En un movimiento inteligente para ampliar su atractivo, el equipo de Qwen también ha asegurado la compatibilidad con las herramientas de desarrollador populares existentes. En particular, qwen3-coder se puede utilizar con el código de Claude de Anthrope, esta estrategia de construcción, que los desarrolladores cambian sin interrumpir sus flujos de trabajo . . Ganar la lealtad de los desarrolladores. Al hacer que sus potentes modelos sean accesibles a través de múltiples plataformas, incluyendo su propio modelo de estudio de estudio , Alibaba aposta que la utilidad y la facilidad de uso de uso también impulsarán la adopción en un bloqueo de mercado de la vendedor. QWEN3-235B-A22B-INSTRUCT-25507, que

Un lanzamiento nublado nublado por el escepticismo de referencia