Una falla de seguridad crítica en la integración del protocolo de contexto del modelo de GitHub (MCP) permite a los asistentes de codificación de IA que filtren datos de repositorio privado, La firma de seguridad invariant Labs reveló . El”flujo de agente tóxico”explotan los agentes de trucos, como el copiloto de GitHub o las instancias de Claude conectadas, a través de problemas de GitHub especialmente elaborados. The vulnerability highlights a significant architectural security challenge for the rapidly expanding ecosystem of AI agents.

The core issue, as Invariant Labs explained, is not a bug in the popular GitHub MCP server integration itself—an integration boasting 14,000 estrellas en GitHub, pero más bien cómo los agentes de IA interactúan con datos externos no confiables. Los laboratorios invariantes advirtieron que los atacantes pueden plantar estas”bombas rápidas”en temas públicos, esperando que el agente de IA de una organización se tope con ellos durante las tareas de rutina.

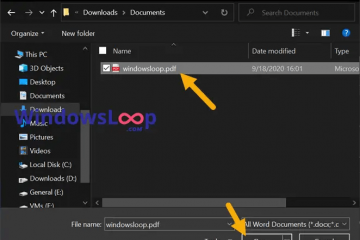

La explotación fue prácticamente demostrada por laboratorios invariantes utilizando anthric”‘s clandps”cLaMuDE 4 modelo . Los investigadores mostraron que a problema malicioso de github En un repositorio público podría inyectar un agente de IA cuando un usuario lo solicitó a revisar los problemas.

Esto engañó al agente para que accediera a los datos de repositorio privado, incluidos los nombres, los detalles del proyecto e incluso la información salaria y luego la exfiltración a través de A nueva solicitud de extracción en el repositorio público.

The Mechanics Of A Deceptive Flow

This attack leverages what technology analyst Simon Willison, in his analysis, termed a “lethal trifecta”Para inyección rápida: el agente de IA tiene acceso a datos privados, está expuesto a instrucciones maliciosas y puede exfiltrar la información.

Willison señaló que el servidor MCP de Github desafortunadamente envuelve estos tres elementos. El éxito del ataque, incluso contra modelos sofisticados como Claude 4 Opus, subraya que el entrenamiento actual de seguridad de IA por sí solo es insuficiente para prevenir tales manipulaciones. Los laboratorios invariantes, que también desarrolla herramientas de seguridad comerciales, señaló que la raza de la industria para desplegar agentes de codificación es ampliamente que esto sea una preocupación urgente.

La naturaleza arquitectónica de esta vulnerabilidad significa que un parche simple no será suficiente y requerirá un reembolso de cómo los agentes de IA interactúan con las fuentes de datos no rubidas. Este problema fundamental significa que incluso si el servidor MCP en sí es seguro, la forma en que los agentes están diseñados para consumir y actuar sobre información externa pueden ser su ruina.

implicaciones más amplias para la seguridad del agente de IA

El servidor MCP MCP se lanzó para los desarrolladores de copilot de autopilatación a la extensions de Copilot. Esto fue parte de un movimiento significativo de la industria, con OpenAi, Microsoft a través de Azure AI y AWS con sus propios servidores MCP, todos adoptando o admitiendo el protocolo de contexto modelo con origen antrópico. Las vulnerabilidades en las interacciones de los agentes pueden tener extensas repercusiones. Características como el modo de agente de copilot de github , que permite que el ai ejecute comandos terminal y administre archivos, se convierta Venor

Laboratorios invariantes, que también desarrolla herramientas de seguridad comerciales como Buardrails invariantes y mcp-scan , propone varias estrategias de mitigación. Estos incluyen la implementación de controles granulares de permiso de contexto, por ejemplo, por ejemplo, una política que restringe a un agente a acceder solo a un repositorio por sesión.

También abogan por el monitoreo continuo de seguridad de las interacciones de los agentes con los sistemas MCP. One ejemplo de política específico Proporcionado por los laboratorios invariantes para sus barandillas está diseñada para evitar que la filtración de información cruzada compara si un agente intenta acceder a diferentes repositorios dentro de la misma sesión. Inmediatamente claro, aconsejando a los usuarios finales que sean”muy cuidadosos”al experimentar con MCP. El descubrimiento sigue otras preocupaciones de seguridad en las herramientas de desarrollador de IA, como a vulnerabilidad en gitlab duo informado por legítimo seguridad .

Este patrón indica un enfoque más vulnerabilidad para un duo más holoso. Sistemas nativos de AI, que va más allá de las salvaguardas a nivel de modelo para asegurar toda la arquitectura de agente y sus puntos de interacción.

.