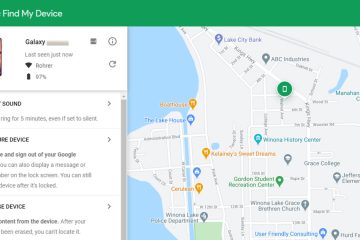

Investigación presentada en la conferencia chi 2025 revela un patrón curioso en cómo la cola de la cola de la colocación legal: informan que están más dispuestos a actuar de la orientación de los grandes modelos de idiomas (LLMS) como el chatgpt que de los abogados humanos, sino especificadamente cuando la fuente está más dispuesta a actuar de la orientación de los grandes modelos de idiomas (LLMS) como el chatgpt que de los abogados humanos, sino que las leyes humanas, sino que la fuente no se identifica más a los modelos de idiomas. Surge la preferencia a pesar de que las personas demuestran la capacidad de diferenciar entre la IA y el texto escrito por los humanos mejor de lo que el azar predeciría, lo que sugiere una relación compleja con la experiencia automatizada, como se detalla en el documento titulado”Objeción anulada! Las personas laicas pueden distinguir grandes modelos de idiomas de los abogados, pero aún favorecen los consejos de una LLM”. href=”https://dl.acm.org/doi/10.1145/3706598.3713470″target=”_ en blanco”> hallazgos proviene de una serie de tres experimentos que involucran 288 participantes. Los investigadores presentaron escenarios legales que cubren problemas comunes como el tráfico, la planificación y el derecho de la propiedad, basados en consultas en línea del mundo real procedentes de plataformas como Reddit R/legaladviceuk . They then showed participants corresponding advice generated either by OpenAI’s ChatGPT-4o or by specialized UK lawyers, measuring willingness to act or confidence in identifying the source.

Preference Depende de conocer la fuente

El hallazgo central surgió al comparar las reacciones de los participantes en función de si sabían quién escribió el consejo. Cuando los participantes desconocían la fuente (probadas en el grupo”Fuente desconocido”del Experimento 1 y confirmados en el Experimento 2), expresaron constantemente una disposición significativamente mayor de actuar sobre el consejo de la LLM en comparación con el consejo de los abogados humanos. Sin embargo, cuando la fuente fue etiquetada explícitamente como”LLM”o”abogado”(grupo de”fuente conocida”del Experimento 1), esta diferencia desapareció; Las calificaciones de disposición a Actos se volvieron estadísticamente similares para ambas fuentes.

Los investigadores sugieren que esta discrepancia podría provenir de los factores sociales cuando se revela la fuente; Las personas pueden sentirse obligadas a calificar el asesoramiento de un profesional humano más alto, conforme a las expectativas percibidas solo cuando se hacen explícitamente conscientes.

Otro factor podría ser las características textuales en sí mismas. El estudio señaló que si bien el consejo de la LLM fue generalmente más corto, su lenguaje se registró como más complejo en función de los puntajes de legibilidad LIX (una medida donde las puntuaciones más altas indican mayores dificultades). El documento discute que las LLM pueden presentar información con un aire de confianza, en contraste con el lenguaje más cauteloso y lleno de cobertura típico de los abogados humanos relacionados con la responsabilidad y los matices.

distinguiendo la IA, sin embargo, lo favorece a ciegas

que, la complejidad, el tercer experimento no ha demostrado los participantes por completo a la fuente. En la tarea de calificar la probabilidad de que cada consejo fuera a versus ser generado por humanos (cuando no estén etiquetados), los participantes tuvieron un rendimiento significativamente mejor que el azar.

usando el análisis de la característica operativa del receptor (ROC): un método de la teoría de detección de señales para medir la discriminabilidad independientemente del sesgo de respuesta: el estudio midió un área bajo la curva (AUC) de 0.59. Un AUC de 0.50 representa el rendimiento del azar, mientras que 1.0 es una precisión perfecta, por lo que 0.59 indica una capacidad genuina, aunque imperfecta, para discernir las diferencias textuales.

Esto presenta un rompecabezas: incluso con cierta capacidad para detectar la autoría de AI, la inclinación predeterminada cuando operaba”ciego”parece favorecer la salida de LLM.

la sábana de la confiabilidad: la fianza predeterminada parece favorecer la salida de LLM. Riesgos

Esta preferencia por el asesoramiento de IA potencialmente indetectable es particularmente relevante dado los problemas de confiabilidad conocidos que afectan a los LLM actuales. A medida que estos modelos se expanden en aplicaciones de asesoramiento más sensibles, como la función de investigación profunda recientemente actualizada de OpenAI en CHATGPT, el riesgo de que los usuarios actúen en información inexacta aumenten.

informa después del lanzamiento de mediados de abril 2025 de la versión O3 y O4-Mini de OpenAI, por ejemplo, apuntando a las tasas más altas de la alucinación, génera que se gana las placas falsas pero falsas a las declaraciones de las versiones anteriores. Openai’s Own

Investigación explorando por qué estos poderosos modelos alucinan apunta a varios factores potenciales relacionados con su entrenamiento. Las teorías incluyen procesos de aprendizaje de refuerzo (RL) que posiblemente recompensan las fabricaciones convincentes si conducen a una respuesta final aparentemente correcta, desafíos para el aprendizaje de refuerzo de la retroalimentación humana (RLHF) cuando los evaluadores humanos no pueden verificar fácilmente la precisión de los pasos de razonamiento intermedio complejo y los modelos que a veces carecen de acceso a su propio paso a paso por la historia de la historia de la conversación. Acciones inventivas que no podían realizar . Como el investigador de transluciones Neil Chowdhury sugirió a TechCrunch,”Nuestra hipótesis es que el tipo de aprendizaje de refuerzo utilizado para los modelos de la serie O puede amplificar los problemas que generalmente están mitigados (pero no completamente borrados) por las tuberías posteriores al entrenamiento estándar”. Este telón de fondo de posibles falta de fiabilidad subraya las preocupaciones planteadas por los hallazgos del documento de Chi sobre el fideicomiso del usuario. Los hallazgos se ajustan a una discusión más amplia sobre la confianza pública en la IA. A medida que el uso crece,

El estudio Chi agrega matices, lo que sugiere que esta desconfianza podría ser más pronunciada cuando la participación de la IA es explícita, contrasta con la preferencia que se encuentra en el escenario ciega. La tendencia a favorecer el asesoramiento de IA”ciego”también complica los esfuerzos para garantizar la responsabilidad cuando las herramientas de IA contribuyen a la orientación profesional. Los autores de Chi Paper proponen mejorar la alfabetización de IA como un camino hacia adelante, posiblemente utilizando métodos de capacitación desarrollados para identificar la información errónea. También señalan la importancia de las medidas de transparencia, referenciando regulaciones como la Ley de AI de la UE que exige un etiquetado claro de contenido generado por IA ( Artículo 50 ) y los desclosuros de riesgo para ciertas aplicaciones.

. Identificable, en lugar de imitar a los expertos humanos, puede ser clave para fomentar la confianza de los usuarios más calibrada. Los materiales de estudio completos, incluidos los scripts de datos y análisis utilizados en jspsych / jatos experimentos, están disponibles a los investigadores a través de los experimentos. href=”https://osf.io/bksqa/?view_only=8c9a5893fb52478cb755870e56e686ca”target=”_ en blanco”> Abrir marco de ciencias contexto más amplio y avanzando