Openai parece prepararse para introducir un nuevo obstáculo significativo para los desarrolladores que desean acceso a sus modelos de IA futuros más poderosos a través de API: un requisito potencial para que las organizaciones se sometan a verificación de identidad utilizando IDS emitidos por el gobierno.

Los detalles que surgen de un Página de soporte de OpenAI La semana pasada describe un proceso de”organización verificada”, enmarcada por la compañía como un paso necesario para contrarrestar el mal uso y promover la implementación de AI responsable. OpenAI suggests this targets a “small minority”intentionally violating its usage policies, aiming to “mitigate unsafe use of AI while continuing to make advanced models available to the broader developer community.”

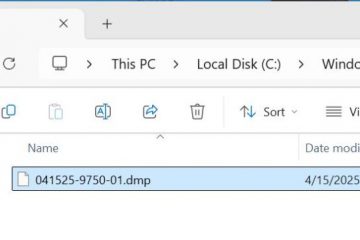

This verification links an authorized individual’s personal government ID to their organization’s API use, with the stipulation that each ID can only validate one organization every 90 days, and eligibility isn’t guaranteed for all applicants, planteando preguntas sobre los criterios específicos.

El sistema propuesto ya está generando una discusión entre los desarrolladores en línea. Las preocupaciones del centro de la fricción operativa adicional, las consideraciones de privacidad de presentar la identificación del gobierno, la exclusión potencial de los usuarios en las regiones fuera de la lista de los usuarios de OpenAi de los países de API compatibles , y el escepticismo más amplio sobre si la motivación primaria es la municipación principal es puramente la lista de los usuarios de la seguridad de los usuarios de seguridad. y un control mejorado sobre el acceso a su plataforma, especialmente dadas acciones pasadas como el bloque API en China o las investigaciones sobre el supuesto mal uso de datos por parte de Deepseek y otros.

nuevos modelos nuevos podría desencadenar nuevos controles

Este posible posible de la capa de verificación, justo cuando los abiertos se preparan para lo que sugieren las fuentes es un lanzamiento inminente de los nuevos modelos AI, los mismos de los sistemas que probablemente caigan en los sistemas de los sistemas de los sistemas. El momento de la política revela. Los nuevos lanzamientos podrían ocurrir tan pronto como esta semana, incluido GPT-4.1 como una actualización de su modelo multimodal GPT-4O, junto con modelos de razonamiento especializados designados O3, O4-Mini y O4-Mini-High.

La estrategia de implementación del modelo de OpenAI se alinea con un ajuste estratégico significativo confirmado por el CEO Sam Altman el 4 de abril el 4 de abril. Al anunciar un”cambio de planes”, Altman priorizó el lanzamiento de los modelos O3 y O4-Mini”probablemente en un par de semanas”, mientras impulsa el debut de los tan esperados GPT-5 de regreso por”unos pocos meses”. GPT-5 mucho mejor de lo que originalmente [t]”. This reversed a plan from February 2025 to potentially fold o3’s abilities into GPT-5.

The need for distinct reasoning models was apparent even after the late February launch of GPT-4.5, which OpenAI’s own system card Reconocido no fue de modelos especializados en ciertos puntos de referencia intensivos en lógica, a pesar de Altman

La llegada de estos sistemas más poderosos, particularmente los modelos de razonamiento previsajes con puntajes de referencia fuertes pero costos de cómputo potencialmente altos, proporciona un contexto para un mayor control de acceso. Sin embargo, la justificación de seguridad establecida de OpenAI para la verificación de ID contrasta bruscamente con los informes de que los períodos de evaluación de seguridad para estos mismos modelos se han acortado drásticamente. Las operaciones de OpenAi supuestamente reducen los plazos de prueba de seguridad para modelos como O3 desde meses hasta a veces menos de una semana, impulsadas por presiones competitivas intensas. Según los informes, esta aceleración ha alarmado a algunos involucrados en el proceso de evaluación. Las metodologías de prueba específicas también están bajo fuego. Los críticos señalan la falta de resultados publicados para las pruebas potenciales de uso indebido utilizando el ajuste fino: más capacitación en datos especializados para investigar las capacidades emergentes peligrosas: en los modelos más nuevos y capaces como O1 o O3-Mini. El ex investigador de seguridad de OpenAi Steven Adler, que detalló las vistas Preguntas de seguridad Sombras Rápidas Lanzamientos

Jefe de Sistemas de Seguridad de OpenAi, Johannes Heidecke, contrarrestó estos puntos, afirmando:”Tenemos un buen equilibrio de cuán rápido nos movemos y cuán exhaustivos somos”, atribuyendo la velocidad a la automatización a la automatización y la realización de los puntos de control fueron”Básicamente Identicales”. > Tensiones internas y telón de fondo de la industria

Esta aparente fricción entre la velocidad del desarrollo y la precaución de seguridad no es un territorio nuevo para OpenAi. Los desacuerdos internos fueron subrayados por la partida de mayo de 2024 de Jan Leike, luego co-líder del equipo de superalineación centrado en el riesgo a largo plazo, que declaró públicamente que”la cultura y los procesos de seguridad han tomado un asiento trasero a los productos brillantes”. The brief argues OpenAI’s shift toward a capped-profit structure deviates from its founding non-profit mission, potentially impacting safety commitments and resource allocation.

The potential ID verification policy unfolds as competitors make varied public gestures toward safety and transparency, such as Anthropic detailing an interpretability framework (though the company also quietly removed some prior voluntary safety pledges) and Google DeepMind proposing a global AGI Estructura de seguridad. Esto ocurre en un contexto de regulación naciente como la Ley de IA de la UE, los descubrimientos continuos de las vulnerabilidades del modelo y las técnicas de jailbreak, y las propias de OpenAI Capacidad reconocida