Según los informes,

Google está en negociaciones avanzadas para arrendar las GPU Blackwell B200 de NVIDIA de CoreWeave, marcando un cambio potencial en la forma en que la compañía escala sus operaciones de IA. The possible deal, first reported by The Information, would allow Google to access powerful AI compute without waiting on internal TPU rollouts.

Instead of relying solely on its in-house Trillium Las TPU, chips comprensivos optimizados para el entrenamiento e inferencia de IA a escala, Google está explorando la capacidad externa para manejar la creciente demanda. CoreWeave, a cloud provider built around Nvidia’s GPU stack, is emerging as a potential partner with the inventory and speed to meet hyperscale needs.

Fast Track to Compute: Why Google May Go External

CoreWeave operates 32 data centers and manages roughly 250,000 GPUs, including the new Blackwell chips. La compañía originalmente comenzó como una empresa minera de criptomonedas antes de girar hacia la infraestructura de IA a medida que surgió la demanda de cómputo con GPU.

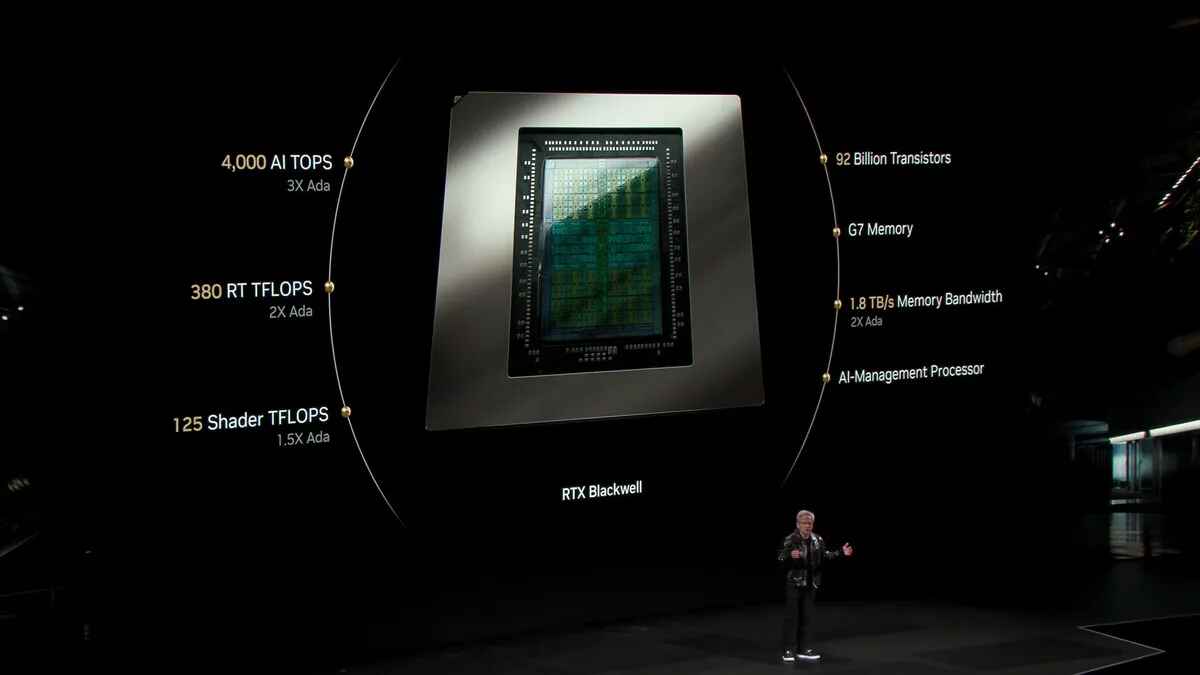

At Nvidia’s GTC 2025 event, held March 18–21, the company introduced Blackwell-based AI servers designed to handle Modelos de billones de parámetros con eficiencia energética mejorada. Benchmark data shows the new 72-GPU servers deliver performance improvements of 2.8 to 3.4 times compared to the previous generation, offering meaningful gains for inference-heavy workloads.

That kind of performance is in high demand. Reuters informó que las empresas chinas son la firma china, incluido el billete, alibaba, y tencent —plays —Plays Worth anders. for Nvidia’s export-compliant H20 chips in just the first quarter of 2025.

What Microsoft Walked Away From

CoreWeave’s availability to potentially service Google is due in part to Microsoft stepping aside. Microsoft decidió no avanzar con una opción de infraestructura de $ 12 mil millones que tenía con CoreWeave. Instead, it redirected resources toward internal chip development, including Azure Maia and Cobalt processors built with AMD.

OpenAI quickly filled the gap. The AI research lab, once closely aligned with Microsoft’s Azure cloud, signed an $11.9 billion, five-year agreement with CoreWeave and took a $350 million equity stake ahead of the company’s IPO.

Microsoft’s pullback from CoreWeave appears to be part of a larger retreat from external AI infrastructure commitments, highlighting a broader trend among tech giants to internalize compute.

CoreWeave’s Financial Strategy and Risk Profile

The potential deal with Google comes at a critical financial moment for CoreWeave. La compañía se hizo pública el 28 de marzo de 2025, recaudando $ 1.5 mil millones a un punto de precio de $ 40/acciones, por una valoración de alrededor de $ 23 mil millones. Nvidia, already a 6% stakeholder, anchored the IPO with a $250 million order.

Although the stock initially wavered, CoreWeave’s shares rose to $43.50 within days of trading. Aún así, la compañía enfrenta obligaciones financieras considerables. CoreWeave registró $ 1.9 mil millones en ingresos en 2024, hasta solo $ 228.9 millones el año anterior, pero también registró una pérdida neta de $ 863 millones. Su infraestructura está en gran medida arrendada, no propiedad, lo que lleva a $ 8 mil millones en deuda y $ 2.6 mil millones en obligaciones de arrendamiento adicionales. The company plans to use $1 billion of IPO proceeds to reduce debt.

The five-year OpenAI contract is expected to drive long-term revenue, but it may not deliver positive cash flow until 2029. That, along with the company’s historical reliance on just two clients—Microsoft and Nvidia—for 77% of its 2024 revenue, has raised sustainability concerns.

Shifting Priorities Among Hyperscalers

Google’s interest in leasing compute from CoreWeave reflects a broader shift in how hyperscalers are managing AI infrastructure. Microsoft está duplicando las inversiones internas de hardware. Amazon continúa expandiendo sus líneas de chips de entrenamiento e inferentios internos. OpenAI, backed by a $40 billion investment from SoftBank, is building its independence from Azure through alternative compute deals like the one with CoreWeave.

Google’s approach seems more hybrid. Si bien continúa evolucionando la familia Trillium TPU, el arrendamiento de hardware NVIDIA de alto rendimiento ofrece una forma de escalar inmediatamente los recursos de calcular a medida que los servicios de IA se vuelven más exigentes. For a company supporting large-scale models like Gemini and a growing suite of AI products, waiting for internal deployments may not be an option.

Yet there are risks. Las GPU Blackwell de NVIDIA ofrecen ganancias sustanciales de rendimiento, pero sus mejoras de eficiencia pueden venir con las compensaciones en la optimización de software y el sorteo de energía. Their real-world benefits will vary depending on workload configuration, and independent testing will be needed to validate manufacturer claims across diverse use cases.

Still, by potentially turning to CoreWeave, Google is buying time—and capacity. Queda por ver si esta es una solución temporal o una estrategia a más largo plazo. Pero en una industria donde el cálculo se ha convertido en moneda, tener acceso, incluso si se alquila, puede marcar la diferencia.