Hugging Face ha presentado dos modelos ligeros de IA, SmolVLM-256M-Instruct y SmolVLM-500M-Instruct, destinados a redefinir cómo la IA puede funcionar en dispositivos con potencia computacional limitada.

Los modelos, que utilizan 256 millones y 500 millones de parámetros respectivamente, están diseñados para abordar los desafíos que enfrentan los desarrolladores que trabajan con hardware limitado o análisis de datos a gran escala a un costo mínimo.

El lanzamiento representa un gran avance en eficiencia y accesibilidad para el procesamiento de IA. Los modelos SmolVLM ofrecen capacidades multimodales avanzadas, lo que permite tareas como describir imágenes, analizar videos cortos y responder preguntas sobre archivos PDF o gráficos científicos.

Como explica Hugging Face, “SmolVLM hace que sea más rápido y económico crear archivos con funciones de búsqueda bases de datos, con velocidades que rivalizan con modelos 10 veces su tamaño.”

Redefiniendo la IA multimodal con modelos más pequeños

SmolVLM-256M-Instruir y SmolVLM-500M-Instruct están diseñados para maximizar el rendimiento y minimizar el consumo de recursos. Los modelos multimodales como estos procesan e interpretan. múltiples formas de datos, como texto e imágenes, simultáneamente, lo que los hace versátiles para diversas aplicaciones.

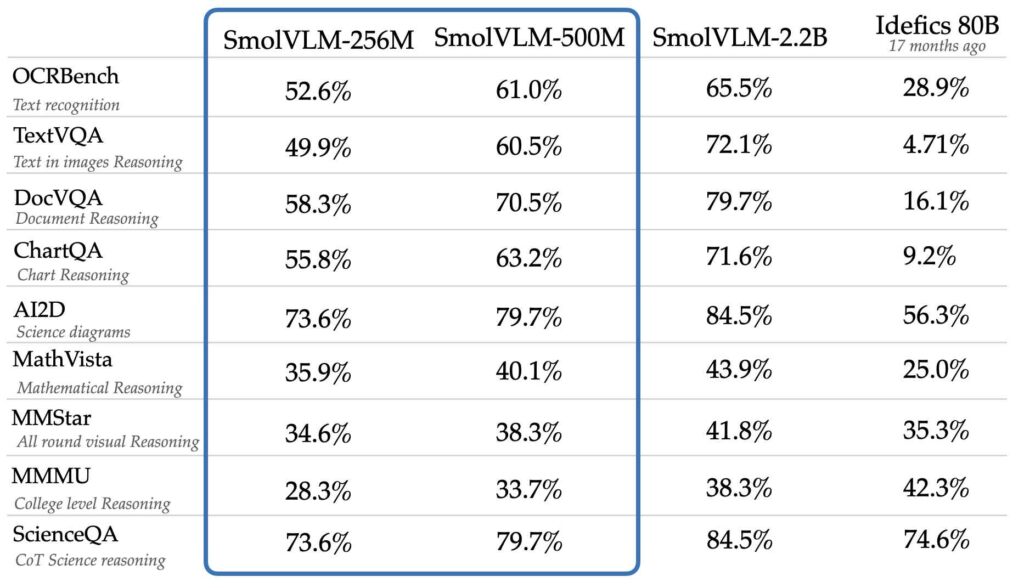

A pesar de su tamaño reducido, los modelos alcanzan niveles de rendimiento comparables. igual o mejor que modelos mucho más grandes como Idefics 80B, según pruebas comparativas como AI2D, que evalúa la capacidad de comprender y razonar con diagramas científicos.

Idefics 80B es una reproducción de acceso abierto de modelo de lenguaje visual Flamingo de código cerrado de DeepMind, desarrollado por Hugging Face, que puede procesar tanto imágenes como entradas de texto.

Fuente: Hugging Face

Fuente: Hugging Face

El desarrollo de estos modelos se basó en dos conjuntos de datos propietarios: The Cauldron y Docmatix. The Cauldron es una colección seleccionada de 50 conjuntos de datos de texto e imágenes de alta calidad que enfatiza el aprendizaje multimodal, mientras que Docmatix está diseñado para la comprensión de documentos, combinando archivos escaneados con subtítulos detallados para mejorar la comprensión.

El equipo M4 de Hugging Face, conocido por su experiencia en IA multimodal, encabezó la creación de estos conjuntos de datos.

En su anuncio, Hugging Face enfatizó la importancia de hacer que la IA sea más accesible.”Los desarrolladores nos dijeron que necesitaban modelos para computadoras portátiles o incluso navegadores, y esa retroalimentación impulsó la creación de estos modelos”, afirmó el equipo. Estos modelos abordan las limitaciones prácticas que enfrentan muchos desarrolladores, especialmente cuando trabajan con dispositivos de consumo u operaciones con presupuesto limitado.

Innovaciones técnicas en los modelos SmolVLM

Un factor crítico en el éxito de los modelos radica en su diseño subyacente. Hugging Face tomó decisiones estratégicas para mejorar tanto la eficiencia como la eficiencia. precisión. Una de esas decisiones fue la adopción de un codificador de visión más pequeño, SigLIP base patch-16/512, en lugar del SigLIP 400M SO utilizado en modelos anteriores como SmolVLM 2B.

Este codificador más pequeño procesa imágenes a resoluciones más altas sin aumentar significativamente la sobrecarga computacional.

Otra innovación implica la tokenización, un proceso clave en los modelos de IA donde los datos se dividen en unidades más pequeñas ( tokens) para su análisis. Al optimizar la forma en que se procesan los tokens de imágenes, Hugging Face redujo la redundancia y mejoró la capacidad de los modelos para manejar datos complejos.

Por ejemplo, los separadores de subimágenes, previamente asignados a múltiples tokens, ahora se representan con un solo token, lo que mejora tanto la estabilidad del entrenamiento como la calidad de la inferencia.”Con SmolVLM, estamos redefiniendo lo que los modelos de IA más pequeños pueden lograr”, explicó el equipo en su anuncio.

Estas opciones de diseño permiten a los modelos SmolVLM codificar imágenes a una velocidad de 4096 píxeles por token, una cifra significativa. mejora con respecto a los 1.820 píxeles por token observados en versiones anteriores. El resultado es una comprensión visual más nítida y velocidades de procesamiento más rápidas.

Perspectiva SmolVLM para. Aplicaciones

Los beneficios prácticos de SmolVLM se extienden más allá de los casos de uso típicos de IA. Los desarrolladores pueden integrar estos modelos sin problemas en los flujos de trabajo existentes utilizando herramientas como Transformers, MLX y ONNX que también han proporcionado excelentes instrucciones. Puntos de control ajustados para ambos modelos, lo que permite una fácil personalización para tareas específicas.

Los modelos son particularmente adecuados para el análisis y la recuperación de documentos. En colaboración con IBM, Hugging Face aplicó SmolVLM-256M. a su sistema Docling, demostrando su potencial para automatizar flujos de trabajo y extraer información de archivos escaneados. Los primeros resultados de esta asociación han resultado prometedores y destacan la versatilidad del modelo.

Además, los modelos SmolVLM están disponibles bajo una Apache Licencia 2.0, que garantiza el acceso abierto para desarrolladores de todo el mundo. Este compromiso con el desarrollo de código abierto se alinea con la misión de Hugging Face de democratizar la IA, permitiendo que más organizaciones adopten tecnologías avanzadas sin enfrentar costos prohibitivos.

Equilibrio entre costos y rendimiento

La introducción de SmolVLM-256M y SmolVLM-500M completa la familia SmolVLM, que ahora incluye una gama completa de modelos de lenguaje de visión más pequeños diseñados para diversas aplicaciones.

Estos modelos son particularmente efectivos para entornos con recursos limitados, como computadoras portátiles de consumo o aplicaciones basadas en navegador. La variante 256M, como el modelo de lenguaje Vision más pequeño jamás lanzado, destaca por su capacidad de ofrecer un rendimiento sólido en dispositivos con menos de 1 GB de RAM.

Hugging Face prevé que SmolVLM se convierta en una solución práctica para los desarrolladores que abordan grandes-escalar el procesamiento de datos con un presupuesto limitado.