Microsoft ha presentado una demanda federal contra un grupo no identificado de ciberdelincuentes acusados de utilizar claves API robadas para eludir los protocolos de seguridad en su servicio Azure OpenAI.

Según la denuncia presentado en el Tribunal de Distrito de los Estados Unidos para el Distrito Este de Virginia, el grupo, conocido como Does 1-10, supuestamente desarrolló y distribuyó herramientas para explotar los sistemas de Microsoft y generan contenido dañino en violación de sus políticas.

Los reclamos legales incluyen violaciones de la Fraude y Abuso Informático Ley (CFAA), la Ley de Derechos de Autor del Milenio Digital (DMCA) y la Ley de Organizaciones Corruptas e Influenciadas por Racketeers (RICO).

El gigante tecnológico alega que el grupo operó un sofisticado plan de piratería, monetizar el acceso no autorizado al servicio Azure OpenAI mediante la distribución de software personalizado, incluida una aplicación del lado del cliente conocida como”de3u”y un sistema de proxy inverso llamado”oai proxy inverso”.

Estas herramientas permitieron a los usuarios aprovechar las credenciales robadas y eludir las medidas de seguridad avanzadas de Microsoft.

Relacionado: Microsoft corta el acceso a Azure OpenAI para los desarrolladores chinos

La investigación de Microsoft comenzó en julio de 2024 cuando descubrió que las claves API (identificadores únicos que autentican las solicitudes de los usuarios) emitidas a clientes legítimos de Azure OpenAI se estaban utilizando para acceder a sus sistemas sin autorización.

La empresa rastreó la actividad hasta una operación coordinada dirigida a múltiples clientes, incluidas varias empresas con sede en EE. UU.

“La manera precisa en que los demandados obtuvieron todas las claves API utilizadas para transportar Se desconoce la mala conducta descrita en esta demanda”, declaró Microsoft en su presentación,”pero parece que los demandados han participado en un patrón de robo sistemático de claves API que les permitió robar claves API de Microsoft de múltiples clientes de Microsoft”.

Relacionado: Los ciberataques impulsados por IA aumentan hasta alcanzar más de 600 millones de incidentes diarios

Herramientas utilizadas en el plan

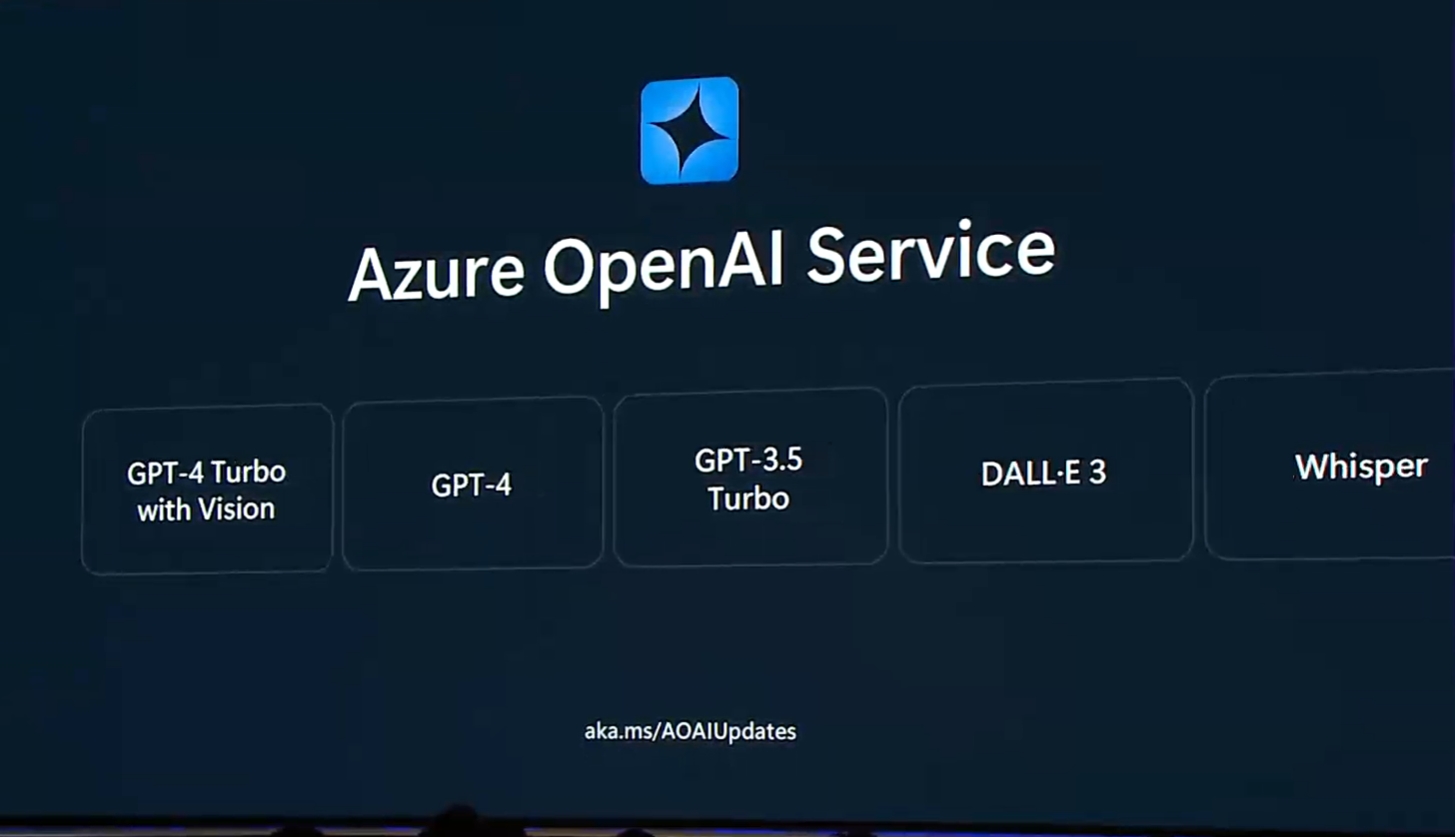

El Los acusados supuestamente crearon el software de3u para facilitar el uso no autorizado del servicio Azure OpenAI. Esta herramienta proporcionó una interfaz fácil de usar para generar imágenes a través del modelo DALL-E de OpenAI.

Se comunicaba con los sistemas de Azure imitando solicitudes API legítimas y explotando credenciales robadas para eludir las medidas de seguridad integradas. El sistema de proxy inverso permitió aún más este abuso al redirigir el tráfico no autorizado a través de túneles de Cloudflare, lo que oscureció las actividades y las hizo más difíciles de detectar.

La demanda de Microsoft describe las herramientas en detalle: “La aplicación de3u de los demandados se comunica con Azure computadoras que utilizan API de red de Microsoft no documentadas para enviar solicitudes diseñadas para imitar solicitudes legítimas de API del servicio Azure OpenAI. El sistema de proxy inverso oai permitió a los usuarios enrutar las comunicaciones a través de túneles de Cloudflare hacia los sistemas Azure y recibir resultados que eludieron las restricciones de seguridad”.

Las herramientas también incluyeron características para eliminar metadatos del contenido generado por IA, evitando la identificación de sus orígenes y permitir aún más el uso indebido.

Tras el descubrimiento de Microsoft, los acusados supuestamente intentaron eliminar la infraestructura clave, incluidas las páginas de Rentry.org, el repositorio de GitHub para de3u y elementos del proxy inverso. sistema.

Contexto más amplio e implicaciones para toda la industria

La demanda llega en un momento en que las tecnologías de IA generativa están bajo un mayor escrutinio por su potencial uso indebido. como DALL-E y ChatGPT de OpenAI han transformado la creación de contenido, pero también han sido explotados para desinformación, desarrollo de malware e imágenes dañinas.

La acción legal de Microsoft subraya los desafíos actuales que enfrentan. Proveedores de IA para proteger sus sistemas.

Microsoft ha enfatizado que las medidas de seguridad integradas en el servicio Azure OpenAI son sólidas y emplean modelos de clasificación neuronal multiclase y protecciones de metadatos. Estos sistemas están diseñados para bloquear contenido dañino y rastrear los resultados generados por la IA hasta sus fuentes.

Sin embargo, como lo demuestra este caso, incluso las salvaguardias más avanzadas pueden ser eludidas por actores determinados.”A pesar de las diversas mitigaciones de seguridad de Microsoft y OpenAI, los malos actores sofisticados han ideado formas de obtener acceso ilegal a los sistemas de Microsoft”, señala la denuncia.

El grupo al que apunta Microsoft no puede estar aislado en sus actividades. alega que los mismos actores probablemente han explotado a otros proveedores de servicios de IA, lo que refleja una tendencia más amplia de abuso en el espacio de la IA. Esto resalta las vulnerabilidades sistémicas de las tecnologías de IA generativa y la necesidad de una colaboración en toda la industria para hacerlo. abordar estas amenazas.

Acciones legales y contramedidas

Para combatir la explotación, Microsoft ha invalidado todas las credenciales robadas e implementado medidas de seguridad adicionales para evitar infracciones similares. La empresa también obtuvo una orden judicial para confiscar dominios asociados con los demandados, incluido”aitism.net”, que era fundamental para sus operaciones.

Estas medidas permiten a la Unidad de Delitos Digitales de Microsoft redirigir las comunicaciones desde estos dominios a entornos controlados para una mayor investigación.

La demanda también describe la intención de Microsoft de buscar daños y medidas cautelares para desmantelar a los acusados.’infraestructura. Al emprender acciones legales, la empresa pretende sentar un precedente para abordar el uso indebido de las tecnologías de IA y responsabilizar a los actores maliciosos.

Implicaciones para el futuro de la seguridad de la IA

El caso ilustra la creciente sofisticación de los ciberdelincuentes que explotan los sistemas de inteligencia artificial. A medida que la IA generativa se integra más en las aplicaciones empresariales y de consumo, aumentan los riesgos de uso indebido. Este incidente resalta la importancia de la inversión continua en tecnologías de seguridad y la necesidad de marcos legales para abordar las amenazas emergentes.

Al presentar esta demanda, Microsoft no solo aborda las vulnerabilidades inmediatas sino que también refuerza su compromiso con el desarrollo responsable de la IA.