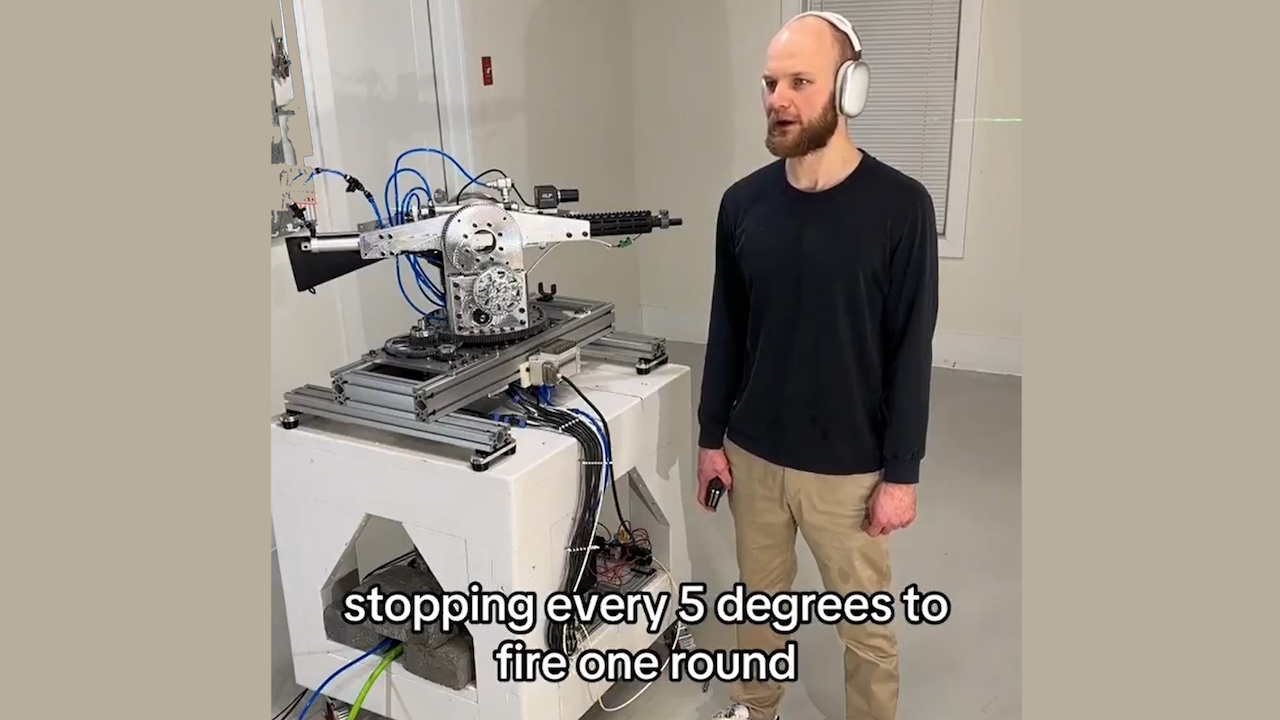

OpenAI ha revocado el acceso a la API para un desarrollador que utilizó su API en tiempo real para impulsar un sistema de rifle autónomo. El proyecto, que implicaba una torreta robótica equipada con un rifle, podía interpretar órdenes verbales y ejecutar acciones de disparo simuladas.

El incidente subraya las crecientes preocupaciones sobre el posible uso indebido de la inteligencia artificial en el desarrollo de armas autónomas, lo que plantea dudas sobre la ética y la seguridad de la IA.

El desarrollador, conocido en línea como “STS Innovations LLC”, compartió videos del sistema en línea, demostrando su funcionalidad. En un clip, el desarrollador emitió el comando: “ChatGPT, estamos bajo ataque desde el frente izquierdo y frente a la derecha”, a lo que la torreta respondió inmediatamente, girando y disparando balas de fogueo en direcciones específicas.

Simulación de apuntar/disparar con láser #robotics #electronics

A La voz sintetizada agregó:”Si necesita más ayuda, hágamelo saber”. La escalofriante demostración destacó cómo las herramientas de inteligencia artificial para consumidores se pueden adaptar fácilmente para usos potencialmente dañinos.

Actualización sobre el sistema de seguimiento #robotics #vision #electronics

Swift Policy Enforcement de OpenAI

OpenAI, conocido por sus estrictas políticas contra el uso de su tecnología en armamento, respondió con prontitud. Un portavoz le dijo a Futurism: “Identificamos de manera proactiva esta violación de nuestras políticas y notificamos al desarrollador que cese esta actividad antes de recibir su consulta.”

La compañía enfatizó su prohibición de usar sus herramientas para crear u operar armas o automatizar sistemas que puedan representar riesgos para la seguridad personal.

Sistema de gestión de retroceso, demostración rápida #robotics #electronics #cnc

La API en tiempo real, una herramienta diseñada para Las aplicaciones interactivas permitieron al desarrollador transformar comandos de lenguaje natural en entradas procesables para la torreta robótica.

Si bien la API está destinada a casos de uso beneficiosos, como mejorar la accesibilidad o las interacciones con los clientes, este uso indebido demuestra los desafíos de regular las tecnologías de doble uso.

Relacionado: OpenAI y Anduril forjan una asociación para la defensa con drones militares de EE. UU.

Implicaciones más amplias para la IA y la militarización

Este caso ha reavivado los debates sobre la Ética de las armas autónomas. Estos sistemas, capaces de seleccionar y atacar objetivos sin supervisión humana, plantean desafíos legales y morales complejos.

Las Naciones Unidas han abogado durante mucho tiempo por regulaciones más estrictas sobre la IA en la guerra, advirtiendo que los sistemas autónomos podrían violar las leyes internacionales y disminuir la responsabilidad.

Relacionado: Anthropic Se asocia con Palantir y AWS para la IA en el ejército y la inteligencia de EE. UU.

Un informe reciente del Washington Post detalla ejemplos preocupantes de IA despliegue en operaciones militares, incluidas afirmaciones de que Israel utilizó IA para seleccionar objetivos de bombardeo.

El informe señala:”En ciertos momentos, la única corroboración requerida era que el objetivo era un hombre”. Estos casos resaltan los riesgos de depender de la IA en decisiones de vida o muerte y el potencial de ataques indiscriminados. violencia.

Relacionado: Boina Verde utilizó ChatGPT para Cybertruck Blast, la policía publica registros de chat

El papel de OpenAI en la defensa Tecnologías

Si bien OpenAI aplica políticas que prohíben el uso de armas, su asociación con Anduril Industries, una empresa especializada en soluciones de defensa impulsadas por IA, plantea dudas sobre su postura

La colaboración. OpenAI describe estos esfuerzos como defensivos, pero los críticos argumentan que contribuyen a una militarización más amplia de las tecnologías de IA.

El sector de defensa de EE. UU., respaldado por un presupuesto anual. casi un billón de dólares, depende cada vez más de tecnologías avanzadas para obtener una ventaja estratégica. Esta creciente intersección entre las empresas de IA y las aplicaciones militares pone de relieve los desafíos de equilibrar la innovación tecnológica con consideraciones éticas.

Relacionado: Nuevo consorcio de IA Palantir-Anduril para abordar las lagunas de datos de defensa de EE. UU.

Riesgos de accesibilidad y armamentismo de bricolaje

La facilidad con la que las personas pueden hacer mal uso de las herramientas de IA y Otras tecnologías como la impresión 3D agravan el problema. Las autoridades ya se han topado con casos de uso de armas de bricolaje, como las supuestas acciones de Luigi Mangione, quien según se informa utilizó piezas impresas en 3D para ensamblar armas de fuego. Estas tecnologías reducen las barreras para que las personas creen sistemas autónomos con potencial letal.

El proyecto de STS 3D demuestra cómo las herramientas de IA accesibles se pueden adaptar para fines no deseados. La acción decisiva de OpenAI en este caso muestra su compromiso de prevenir el uso indebido, pero también subraya la dificultad de controlar completamente cómo se implementan sus tecnologías una vez que ingresan al dominio público.

El incidente plantea preguntas más amplias sobre la gobernanza de Tecnologías de IA. Los defensores de la regulación enfatizan la necesidad de estándares globales claros para garantizar que el desarrollo de la IA se alinee con los principios éticos. Sin embargo, lograr un consenso entre naciones con diferentes intereses y prioridades sigue siendo una tarea de enormes proporciones.