Nvidia ha presentado Jetson Orin Nano Super Developer Kit, una plataforma de IA de alto rendimiento que ofrece un aumento del 70 % en la velocidad de inferencia de IA generativa y al mismo tiempo duplica el ancho de banda de la memoria en comparación con su predecesor.

Con un precio de 249 dólares, el kit ofrece a desarrolladores, investigadores y estudiantes una herramienta rentable para crear e implementar aplicaciones avanzadas de IA en el borde.

El kit de superdesarrollador NVIDIA Jetson Orin Nano es una placa de IA de borde compacta diseñada para crear aplicaciones de entrada. Dispositivos impulsados por IA de alto nivel, como robots, drones y cámaras inteligentes.

Es La combinación de rendimiento de hardware mejorado y optimizaciones de software compatibles con versiones anteriores lo posiciona como una solución atractiva para cargas de trabajo de robótica, visión por computadora y IA generativa en tiempo real, áreas donde la potencia computacional debe combinarse con la energía y limitaciones de espacio.

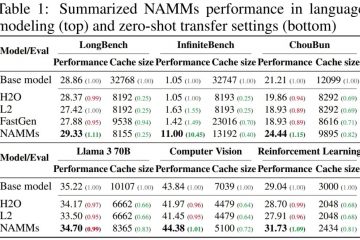

Comparación de configuración del Jetson Orin Nano Super Developer Kit

Aumento de rendimiento de IA asequible para Edge Computing

El Jetson Orin Nano Super se basa en la arquitectura de GPU Ampere de Nvidia, que tiene ha sido una piedra angular de sus ofertas de IA en centros de datos, nube y ahora computación de borde. El kit de desarrollador incluye el sistema en módulo (SoM) Jetson Orin Nano 8GB. y ofrece una mayor eficiencia para tareas como modelos basados en transformadores, modelos de lenguaje y simulaciones de robótica.

Nvidia informa un aumento de 1,7 veces en la IA generativa rendimiento de inferencia, posible gracias a actualizaciones de hardware y optimización de software. En particular, el nuevo sistema logra 67 TOPS (billones de operaciones por segundo) de rendimiento de computación dispersa, en comparación con los 40 TOPS de la serie Orin Nano anterior, y aumenta el ancho de banda de la memoria a 102 GB/s, un salto significativo con respecto a los 68 GB/s anteriores./p>

Según Nvidia, el kit de desarrollador conserva el mismo factor de forma compacto y al mismo tiempo ofrece mayor eficiencia. Deepu Talla, vicepresidente de Computación integrada y perimetral de Nvidia, destacó el impacto de la actualización y dijo:”Es como si hubiéramos tomado a Orin Nano y le hubiéramos dado una capa de superhéroe”.

Estas mejoras permiten a los desarrolladores manejar la IA Tareas que antes estaban limitadas a sistemas en la nube, como ejecutar modelos de lenguaje grande (LLM) compactos como Llama-3.1 y Gemma-2. Al permitir que modelos más pequeños y optimizados se ejecuten localmente, Jetson Orin Nano Super reduce la dependencia de los recursos de la nube. y latencia: fundamental para la robótica, las máquinas autónomas y otras aplicaciones en tiempo real.

[contenido integrado]

Las actualizaciones de software amplían las ganancias de rendimiento a los dispositivos existentes

Además del lanzamiento del hardware, Nvidia presentó una actualización JetPack SDK que beneficia a toda la familia Jetson Orin, incluidas las versiones anteriores. Modelos Orin Nano y NX Esta actualización desbloquea el Super Modo, una configuración de mayor potencia que aumenta las frecuencias de reloj de la GPU y la CPU para mejorar el rendimiento.

Los desarrolladores pueden activar el Super Modo utilizando la herramienta Power Mode Selector de Nvidia, accesible a través de. línea de comando o interfaz gráfica. Con esta característica, el hardware existente puede lograr ganancias de rendimiento similares a las del Jetson Orin Nano Super sin inversión adicional.

Al garantizar la paridad de software en toda su línea Orin, Nvidia maximiza el ciclo de vida y el valor de sus plataformas de IA de vanguardia, lo que hace que facilita a los desarrolladores escalar sus proyectos.

Aplicaciones del mundo real: robótica, modelos de visión e IA generativa

Jetson Orin Nano Super de Nvidia está diseñado específicamente para aplicaciones de vanguardia que requieren un procesamiento de IA eficiente. Las áreas clave de enfoque incluyen robótica, visión por computadora e IA generativa:

En robótica, Nvidia La plataforma Isaac ofrece herramientas de simulación y generación de datos sintéticos para acelerar el desarrollo. Por ejemplo, Isaac Sim permite a los desarrolladores crear prototipos de sistemas robóticos en entornos virtuales antes de implementarlos en el mundo real. De manera similar, Omniverse Replicator de Nvidia facilita la creación de datos sintéticos de alta calidad para entrenar modelos de IA.

Para la visión por computadora, el Jetson Orin Nano Super admite modelos basados en transformadores como modelo de transformador de visión autosupervisado DINOv2 de Meta y CLIP, que ofrecen precisión mejorada para tareas de reconocimiento de imágenes, clasificación y detección de objetos.

Estos modelos permiten que los sistemas analicen imágenes de alta resolución y secuencias de video con mayor eficiencia, lo que hace que el dispositivo sea ideal para aplicaciones como control de calidad automatizado, vigilancia y navegación autónoma.

Las cargas de trabajo de IA generativa también se benefician de las capacidades de la plataforma. Ejecutando LLM compactos localmente, como Llama-3.1 8B o Gemma-2: los desarrolladores pueden implementar aplicaciones como chatbots de generación aumentada de recuperación (RAG) o resumen de contenidos en tiempo real.

La combinación de baja latencia y consumo de energía reducido hace que Jetson Orin Nano Super sea ideal para entornos periféricos donde el ancho de banda y el acceso a la nube son limitados.

Ecosistema de desarrollador y largo plazo-Term Support

Nvidia dice que está comprometida a apoyar a la comunidad Jetson a través de recursos y herramientas integrales. Jetson AI Lab proporciona a los desarrolladores contenedores prediseñados, guías de implementación y tutoriales para implementar modelos de IA. Los ejemplos incluyen la integración de Ollama para la implementación de chatbot y el aprovechamiento de marcos de trabajo de Hugging Face, Google, Microsoft y Meta.

El kit para desarrolladores también cuenta con soporte para hasta cuatro cámaras, lo que permite el procesamiento de secuencias múltiples para tareas basadas en la visión, algo fundamental para la robótica y los sistemas autónomos.

Para garantizar la estabilidad a largo plazo, Nvidia ha ampliado el ciclo de vida del producto Jetson Orin a través de 2032, lo que brindará a los desarrolladores y empresas confianza en la disponibilidad de la plataforma para futuras implementaciones.

Un paso adelante para la IA perimetral

Con Jetson Orin Nano Super, Nvidia combina un rendimiento mejorado de la IA con asequibilidad, abordando la creciente necesidad de computación en el dispositivo en tiempo real. La capacidad de la plataforma para ejecutar modelos compactos de IA generativa, procesar imágenes de alta resolución y acelerar el desarrollo robótico la convierte en una herramienta esencial para los desarrolladores que trabajan en soluciones de vanguardia.

Al ofrecer mejoras de hardware junto con optimizaciones de software que se aplican a las soluciones existentes. dispositivos, Nvidia ha creado un ecosistema sólido para el desarrollo de IA perimetral.