El experto en tecnología y columnista de TI Mark Pesce ha identificado una falla importante que afecta a una amplia gama de grandes modelos de lenguaje (LLM), incluidos los utilizados en chatbots de IA populares como ChatGPT, Microsoft Copilot y Google Gemini. La falla, provocada por un mensaje aparentemente simple, hace que los modelos produzcan resultados incoherentes e interminables, lo que genera preocupaciones sobre la estabilidad y confiabilidad de estos sistemas de IA.

Resultados continuos y sin sentido

Como escribe Pesce en su artículo para The Register, el problema fue descubierto cuando intentó crear un mensaje para un Clasificador basado en IA. El clasificador estaba destinado a ayudar a un abogado de propiedad intelectual automatizando tareas que requerían juicios subjetivos. Cuando se probó en Microsoft Copilot Pro, que utiliza el modelo GPT-4 de OpenAI, el mensaje provocó que el chatbot generara resultados continuos y sin sentido. Se observó un comportamiento similar en otros modelos de IA, incluido Mixtral y varios otros, con la excepción de Claude 3 Sonnet de Anthropic. Pesce escribe:

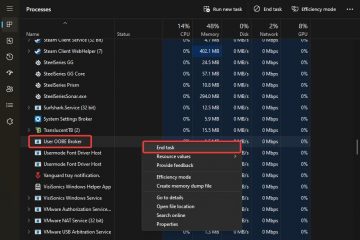

“Me puse a trabajar en la redacción de un mensaje para ese clasificador, comenzando con algo muy simple, no muy diferente de un mensaje que enviaría a cualquier chatbot. Para probarlo antes de comenzar a consumir costosas llamadas API, lo instalé en Microsoft Copilot Pro. Debajo de la marca Microsoft, Copilot Pro se encuentra encima del mejor modelo de su clase de OpenAI, GPT-4. Escribí el mensaje y presioné regresar.

El chatbot comenzó bien, durante las primeras palabras de su respuesta. Luego descendió a una locura parecida a un balbuceo”.

Respuesta y desafíos de la industria

Pesce informó el problema a varios proveedores de servicios de inteligencia artificial, incluidos Microsoft y xAI de Elon Musk, quienes están detrás de los productos de inteligencia artificial de Grok. xAI confirmó la replicación de. la falla en múltiples modelos, lo que indica un problema fundamental en lugar de un error aislado. Sin embargo, la respuesta de otras empresas fue menos alentadora. El equipo de seguridad de Microsoft descartó el problema como un error no relacionado con la seguridad, mientras que otras empresas destacadas de IA no respondieron. Algunas empresas no tenían información de contacto directo para informar problemas tan críticos, lo que destaca una brecha significativa en sus procesos de seguridad y atención al cliente.

Implicaciones para el desarrollo de la IA

El descubrimiento subraya los riesgos potenciales asociados con el rápido despliegue de tecnologías de IA sin mecanismos sólidos de apoyo y retroalimentación. La falta de un canal claro para informar y solucionar errores en estos sistemas representa una amenaza para su confiabilidad y seguridad. Los expertos de la industria enfatizan la necesidad de que las empresas de IA establezcan procesos eficientes para manejar los comentarios de los clientes y resolver los problemas con prontitud. Hasta que se implementen estas medidas, la seguridad y confiabilidad de las aplicaciones impulsadas por IA seguirán en duda.

La experiencia de Pesce apunta a un problema más amplio dentro de la industria de la IA: la necesidad de pruebas más rigurosas y una mejor comunicación entre los desarrolladores. y usuarios. A medida que la IA continúa integrándose en diversos aspectos de la vida diaria y los negocios, es primordial garantizar que estos sistemas sean efectivos y seguros.