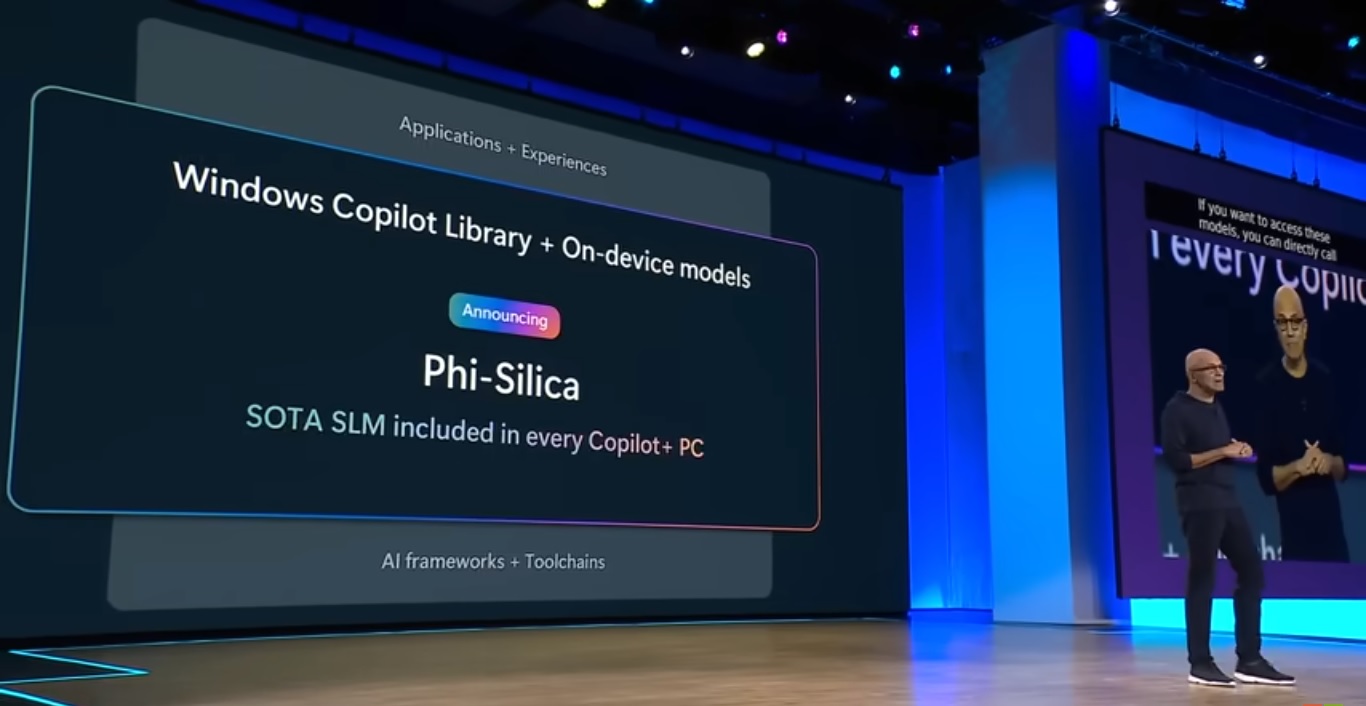

Como informamos ayer, Microsoft presentó Phi-3-Vision, una nueva incorporación a su familia de modelos de lenguaje pequeño Phi-3 AI, en la conferencia de desarrolladores Build 2024. Este modelo multimodal tiene como objetivo mejorar el conjunto de herramientas de inteligencia artificial de la empresa, proporcionando a los desarrolladores capacidades más sólidas. En otro anuncio, el director ejecutivo de Microsoft, Satya Nadella, reveló Phi Silica, otro miembro del lenguaje pequeño Phi. familia de modelos.

Con 3,3 mil millones de parámetros, Phi Silica es el modelo más pequeño de la familia, diseñado para un rendimiento óptimo en unidades de procesamiento neuronal (NPU) en las PC Copilot+. Este modelo permite la inferencia local y mejora el rendimiento de la latencia del primer token, ofreciendo a los desarrolladores una API para crear experiencias de usuario en todo el ecosistema de Windows.

Expansión de la biblioteca Copilot de Windows

El modelo Phi Silica está integrado en la nueva biblioteca Windows Copilot de Microsoft, un conjunto completo de API impulsadas por más de 40 modelos en el dispositivo incluidos con Windows. La biblioteca tiene como objetivo mejorar la capacidad de los desarrolladores para aprovechar la IA dentro del entorno Windows. Las API disponibles en el lanzamiento del SDK de aplicaciones de Windows en junio incluirán funcionalidades como efectos de estudio, traducciones de subtítulos en vivo, Phi Silica, reconocimiento óptico de caracteres (OCR) y recuperación de actividad del usuario. API adicionales, como resumen de texto, incrustaciones de vectores y generación aumentada de recuperación (RAG), están programadas para lanzamientos futuros.

PC Copilot+ y planes futuros

PC Copilot+, la marca de PC con Windows equipadas con una red neuronal especializada Los chips para ejecutar aplicaciones de inteligencia artificial como Copilot y Phi Silica comenzarán a enviarse a mediados de junio. Estos dispositivos contarán con chips Snapdragon X Elite y Plus basados en Arm de Qualcomm. Microsoft, junto con varios fabricantes importantes de PC, planea presentar estas computadoras portátiles este verano. Intel también se está preparando para lanzar su propio procesador Copilot+ basado en PC, cuyo nombre en código es Lunar Lake, previsto para el tercer trimestre de 2024.

Inicialmente, Microsoft se centró en modelos de lenguajes grandes (LLM) que operan en el nube. Sin embargo, en abril, la compañía presentó Phi-3-mini, un modelo más pequeño diseñado para ejecutarse localmente en PC. Phi Silica es un derivado de Phi-3-mini, diseñado específicamente para PC Copilot+. Este cambio hacia modelos de lenguaje pequeño (SLM) aborda las limitaciones de los LLM, que requieren memoria y almacenamiento sustanciales, lo que los hace poco prácticos para las PC típicas. Los SLM como Phi Silica equilibran la precisión y la velocidad con un modelo de 3.300 millones de parámetros.

Procesamiento local de IA para la privacidad

La mayoría de las interacciones de IA ocurren en la nube, con servicios como el Copilot existente de Microsoft que se comunica con servidores remotos. Sin embargo, el próximo motor de búsqueda Recall PC se ejecutará localmente en las NPU por razones de privacidad, evitando la indexación de búsquedas anónimas o de incógnito. Esta capacidad de procesamiento local es una característica clave de los nuevos modelos de IA, que proporciona privacidad y rendimiento mejorados.

Microsoft ha destacado que Windows es la primera plataforma que presenta un modelo de lenguaje pequeño personalizado para NPU e incluido.-De la caja. Aún no está claro si Phi Silica se preinstalará en las PC Copilot+ como una versión local de Copilot, una pregunta que Microsoft tiene hasta el 23 de junio para abordar. Este desarrollo subraya el compromiso de Microsoft de integrar capacidades avanzadas de IA directamente en su sistema operativo, ofreciendo a los usuarios funcionalidad y rendimiento mejorados.