El portal de noticias MSN de Microsoft está bajo escrutinio después de publicar un artículo generado por IA que etiquetaba al recientemente fallecido jugador de la NBA, Brandon Hunter, como”inútil”. El artículo original, que apareció en un sitio de noticias deportivas llamado”Race Track”, se volvió viral, lo que generó críticas generalizadas.

El artículo, que aparentemente fue generado por IA, describió el fallecimiento del exjugador de la NBA de 42 años de una manera desagradable, con frases como”falleció”y”realizado en 67 videojuegos.”Este incidente ha generado preocupación sobre la confiabilidad y sensibilidad del contenido generado por IA, especialmente cuando se trata de temas delicados como obituarios.

Un exjugador de la NBA muere joven y AI escribe este titular:

“Brandon Hunter es inútil en 42”

Y fíjate en esa prosa:

“El ex jugador de la NBA Brandon Hunter, que anteriormente jugó para los Boston Celtics y Orlando Magic, falleció a la edad de 42 años”. https://t.co/xEvVVHo9DP pic.twitter.com/EiKlZEhluS

— Joshua Benton (@jbenton) 14 de septiembre de 2023

Percances anteriores de IA en Microsoft

Esta no es la primera vez que las iniciativas de IA de Microsoft News han sido criticadas. En agosto de 2023, una guía de viajes generada por IA en el portal de noticias MSN recomendó de manera extraña un banco de alimentos local en Ottawa, Canadá, como atracción turística. A pesar de estos repetidos errores, Microsoft sigue dependiendo en gran medida del contenido generado por IA.

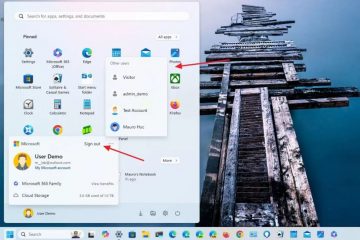

En 2020, la compañía incluso despidió a su equipo de periodistas de MSN, lo que provocó un aumento en los artículos generados por IA en la plataforma. Algunos de estos artículos han sido criticados por ser inexactos en cuanto a los hechos, estar mal redactados o incluso plagiados.

Las implicaciones más amplias de la IA en el periodismo

Las controversias recientes Los temas que rodean el contenido generado por IA de Microsoft resaltan los desafíos e implicaciones más amplios de la integración de la IA en el periodismo. Si bien la IA puede generar contenido rápidamente y a escala, carece del toque humano, la sensibilidad y el juicio necesarios para ciertos temas.

El incidente con el obituario de Brandon Hunter sirve como un claro recordatorio de los peligros potenciales de confiar demasiado en gran medida en la IA para la generación de contenido. A medida que la IA sigue desempeñando un papel más destacado en el periodismo, es crucial que los editores logren el equilibrio adecuado entre la automatización y la supervisión humana para mantener la confianza y la credibilidad.

Microsoft aprovecha la misma generación de contenido de IA que sustenta Bing. Chatbot de búsqueda de IA. Esto puede resultar problemático porque Bing Chat es una fuente de información muy poco fiable. Dejé de usar Bing Chat como cualquier tipo de herramienta de búsqueda/investigación adecuada. El chatbot de Microsoft simplemente es demasiado aleatorio con la verdad, lo que incluye proporcionar citas falsas, inventar nombres y, en general, equivocarse en detalles menores, pero importantes.

Bing Chat también duplica sus imprecisiones, discute y se confunde con mucha facilidad. Esto es importante porque significa que los usuarios deben microadministrar el bot, utilizar indicaciones muy claras y estar dispuestos a verificar todo lo que produce. Esto lleva mucho tiempo y no es muy eficiente para lo que se supone que es una herramienta de búsqueda.

Si no se puede confiar en los resultados de las búsquedas, ¿qué sentido tiene utilizar Bing Chat? Es una situación similar al usarlo para cualquier tipo de creación de contenido. Si es necesario verificar todo y utilizar múltiples indicaciones, ¿realmente nos están ayudando estas herramientas?