La reciente presentación de MLPerf Inference v3.1 ha generado nuevos puntos de referencia para grandes Modelos de lenguaje (LLM) y recomendaciones, lo que significa un avance significativo en las pruebas de IA. Los puntos de referencia de MLPerf, desarrollados por MLCommons, un consorcio de líderes académicos en IA, laboratorios de investigación y de toda la industria, están diseñados para proporcionar evaluaciones imparciales de rendimiento de entrenamiento e inferencia para hardware, software y servicios.

La nueva versión ha sido testigo de un nivel de participación sin precedentes, con más de 13.500 resultados de rendimiento, lo que supone una mejora del rendimiento de hasta un 40 %. La diversidad en la participación es evidente con 26 participantes distintos, incluidas importantes empresas tecnológicas como Google, Intel y NVIDIA, así como participantes nuevos como Connect Tech, Nutanix, Oracle y TTA.

David Kanter, director ejecutivo de MLCommons, enfatizó la importancia de esta contribución y afirmó:”Someterse a MLPerf no es trivial… Requiere trabajo de ingeniería real y es un testimonio al compromiso de nuestros remitentes con la IA, con sus clientes y con el ML.”

@MLCommons, ¡acabamos de lanzar! Nuevo @MLPerf Resultados de inferencia y almacenamiento. La participación récord en MLPerf Inference v3.1 y los primeros resultados de MLPerf Storage v0.5 resaltan la creciente importancia de GenAI y almacenamiento. Vea todos los resultados y obtenga más información https://t.co/7eycrrmOdw

— MLCommons (@ MLCommons) 11 de septiembre de 2023

Resultados de las pruebas comparativas

El objetivo principal de MLPerf Inference es medir la velocidad a la que los sistemas de IA pueden ejecutar modelos en diferentes escenarios de implementación. Estos van desde chatbots de IA generativa avanzada hasta funciones de seguridad de los vehículos como el mantenimiento automático de carril y las interfaces de voz a texto. El foco de atención en esta versión está en la introducción de dos puntos de referencia:

Un LLM que utiliza el modelo de referencia GPT-J para resumir artículos de noticias de CNN, lo que refleja la rápida adopción de la IA generativa con 15 participantes. Un punto de referencia de recomendación actualizado, más alineado con los estándares de la industria, que utiliza el modelo de referencia DLRM-DCNv2 y conjuntos de datos más grandes, y recibió nueve presentaciones.

Para ver los resultados de MLPerf Inference v3.1 y MLPerf Storage v0.5, y para encontrar información adicional sobre las pruebas comparativas, visite:

https://mlcommons.org/en/storage-results-05/

https://mlcommons.org/en/inference-edge-31/

https://mlcommons.org/en/inference-datacenter-31/

El dominio de NVIDIA y la estrecha persecución de Intel

Los chips avanzados de NVIDIA han surgido como los principales contendientes en las pruebas en un modelo de lenguaje grande, seguido de cerca por el hardware de Intel. MLCommons, conocido por su evaluación comparativa neutral del rendimiento del chipset de IA, anunció los resultados de sus nuevas evaluaciones comparativas MLPerf Inference 3.1.

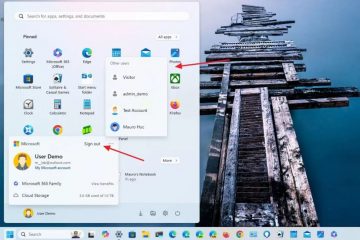

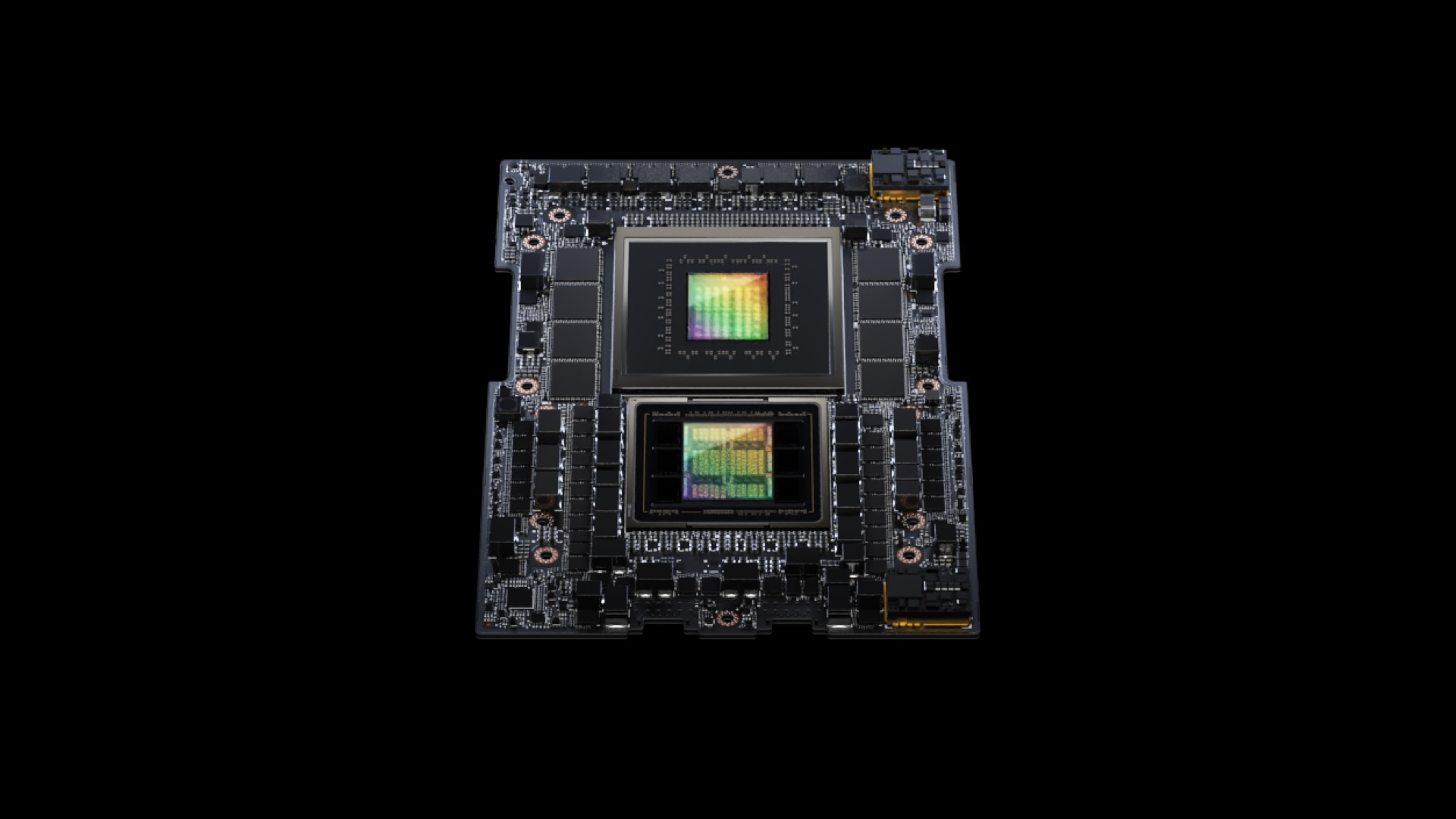

NVIDIA mostró su GH200 Grace Hopper Superchip, que fusiona una unidad de procesamiento gráfico Hopper con una unidad de procesamiento central Grace, ofreciendo memoria mejorada, ancho de banda y capacidades de transferencia de tareas entre los GPU y una CPU basada en Arm. Este conjunto de chips superó al sistema HGX 100 de NVIDIA en aproximadamente un 17 %. Sin embargo, los aceleradores Habana Gaudi2 de Intel no se quedaron atrás, mostrando un retraso en el rendimiento de sólo el 10 % en comparación con los sistemas de NVIDIA.

Esta semana, Nvidia anunció una nueva actualización de software que duplica de manera efectiva el rendimiento de su GPU H100 AI. El nuevo software de código abierto TensorRT-LLM de la compañía, cuyo lanzamiento está previsto para las próximas semanas, ha demostrado una mejora significativa en el rendimiento.

En pruebas utilizando el modelo GPT-J 6B, el sistema actualizado mostró una mejora de rendimiento ocho veces mayor que el A100, un salto significativo con respecto a la ventaja anterior de cuatro veces. Además, cuando se evaluó en Llama2 LLM de Meta, los H100 mejorados con TensorRT-LLM superaron a los A100 en un factor de 4,6, una mejora notable con respecto a las 2,6 veces anteriores a la actualización.