Un procesador de gráficos viene con memoria de acceso aleatorio de video (VRAM) que actúa de la misma manera que la RAM para una CPU. La VRAM carga texturas, sombreadores y otros datos gráficos directamente desde los discos de almacenamiento y los pasa a la GPU para renderizar la pantalla.

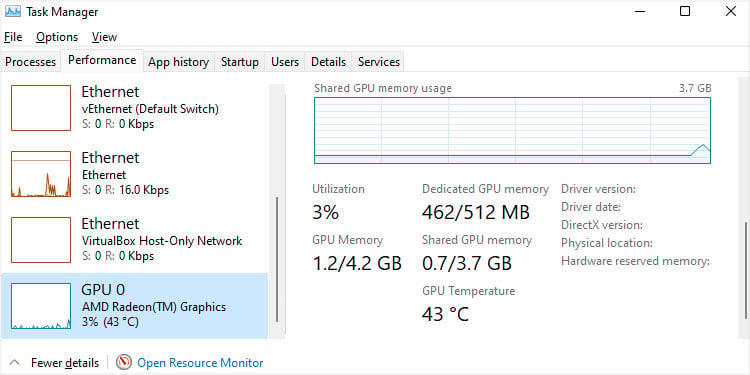

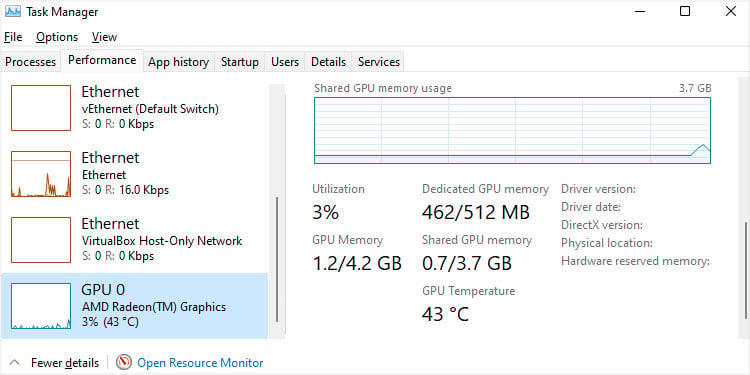

Sin embargo, las GPU tienen capacidades limitadas; si ejecuta tareas que requieren más memoria de video, el procesador se queda sin su VRAM disponible. En tales casos, comienza a usar algo de espacio (generalmente la mitad) de la RAM del sistema como memoria de video virtual, que es la memoria de GPU compartida.

¿Por qué la GPU necesita VRAM dedicada o memoria de GPU compartida?

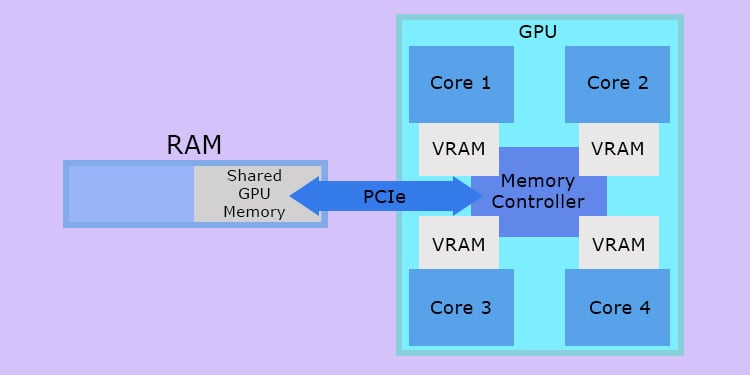

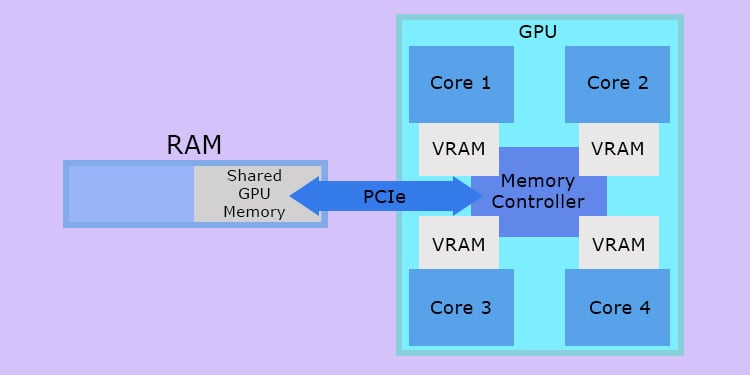

A diferencia de una CPU, que es un procesador en serie, una GPU necesita procesar muchas tareas gráficas en paralelo para representar los gráficos. Un solo renderizado necesitará múltiples texturas, sombreadores, elementos de iluminación, así como funciones de posprocesamiento como filtros. Procesar todos estos elementos para renderizar la pantalla de forma adecuada y rápida requiere numerosos núcleos que se ejecutan en paralelo.

Y antes de manipular estos elementos, necesita obtenerlos de los discos de almacenamiento donde están almacenados. Ahí es donde entra en uso la VRAM. Los módulos VRAM acceden a todos estos datos muy rápidamente desde el dispositivo de almacenamiento y crean conductos similares a búfer para enviarlos a la GPU.

Y si los módulos VRAM dedicados no están libres para realizar esta tarea, la computadora tiene que usar partes de la RAM del sistema como virtual VRAM en su lugar.

La mayoría de las GPU integradas (iGPU) no tienen VRAM dedicada o solo tienen una capacidad de VRAM limitada. Entonces, si solo tiene una iGPU en su computadora, su sistema definitivamente usará la memoria GPU compartida para la mayoría de los procesos gráficos.

Antes de que se utilizara esta tecnología, la ejecución de tareas gráficas intensivas con frecuencia provocaba errores de pantalla azul de muerte (BSOD) debido a la memoria de video insuficiente.

¿En qué se diferencia la memoria de GPU compartida de la memoria de video dedicada?

La VRAM del procesador de gráficos es el dispositivo más rápido en cualquier sistema informático (siempre que no use GPU extremadamente antiguas). Las RAM son las siguientes en la línea cuando se trata de velocidad. Por lo tanto, la memoria de GPU compartida nunca puede proporcionar un rendimiento tan bueno como la VRAM dedicada.

Aparte de eso, los módulos de VRAM son partes del procesador de gráficos y están estrechamente vinculados con los núcleos de GPU, mientras que las RAM deben usar la conexión PCIe para enviar datos a la GPU. Esto afecta aún más el rendimiento de la memoria GPU compartida.

Otra cosa es que siempre que su sistema necesite usar la memoria GPU compartida, necesita cortar la capacidad máxima de RAM. Esto puede conducir a más impactos en el rendimiento o incluso puede obstaculizar el funcionamiento de otros componentes como la CPU o la propia GPU con su máximo potencial.

¿Debo configurar la memoria GPU compartida?

Algunos los dispositivos incluyen la opción de configurar la memoria de GPU compartida en su BIOS. Sin embargo, no se recomienda cambiar esta configuración independientemente de si tiene suficiente VRAM dedicada o no.

Si tiene suficiente VRAM, su sistema no usará la memoria GPU compartida a menos que sea necesario. E incluso usar la memoria no reserva la mitad completa de la RAM, solo la parte que usa. Por lo tanto, no es necesario cambiar la configuración.

Y si consideramos un procesador de gráficos con VRAM insuficiente, su computadora asigna automáticamente el espacio necesario de la RAM como espacio de memoria GPU compartida. Las partes de este espacio actuarán como VRAM virtual cuando las reserve la GPU y, de lo contrario, como RAM.

La asignación automática tiene en cuenta el equilibrio entre la RAM requerida y la VRAM, por lo que es mejor no tocar esta configuración en absoluto. De lo contrario, puede encontrar bloqueos o retrasos al ejecutar aplicaciones con uso intensivo de gráficos.