TL;DR

Das Wesentliche: Google testet eine „Search Live“-Schnittstelle, die visuelle Zitatkarten in Echtzeit während gesprochener Sprachantworten anzeigt. Wichtige Details: Die von Gemini 3 unterstützte Funktion zeigt Quelllinks an, während die KI spricht, um eine sofortige Überprüfung von Ansprüchen zu ermöglichen. Warum es wichtig ist: Dieses Update zielt darauf ab, die durch KI-Halluzinationen verursachte „Vertrauenslücke“ zu schließen und Bedenken von Publishern hinsichtlich Zero-Click-Traffic auszuräumen.

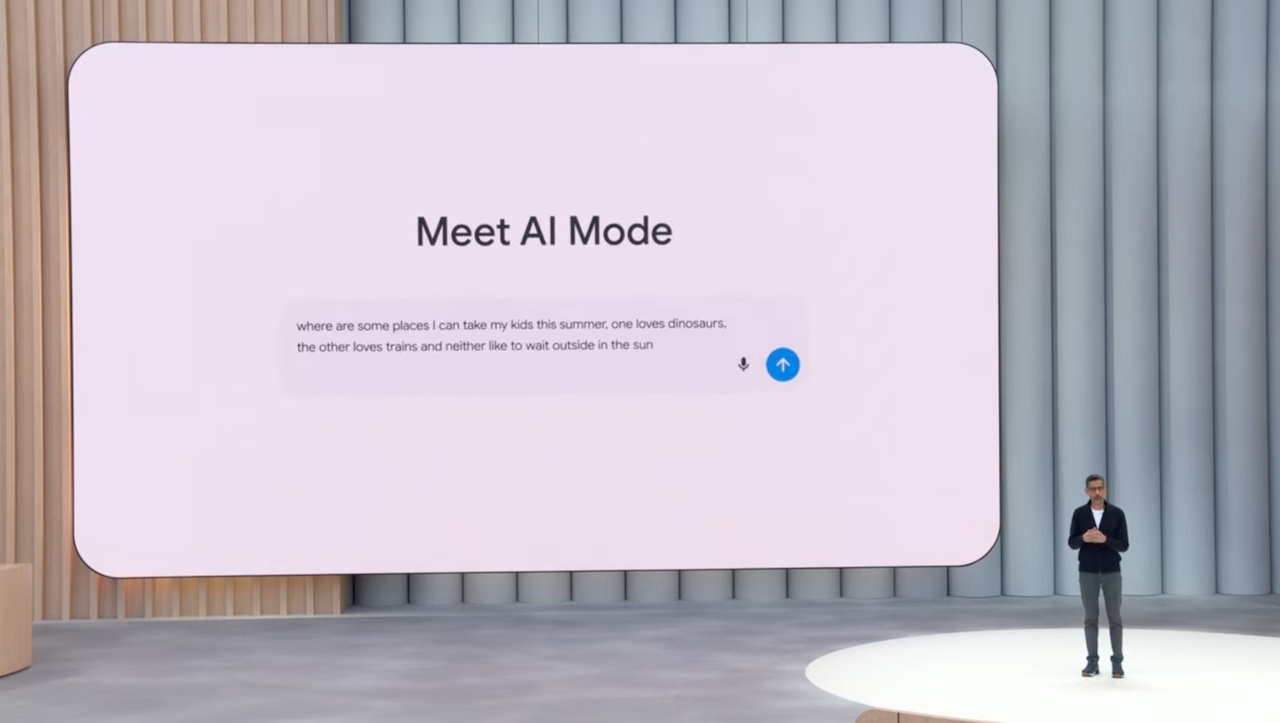

Um die Lücke zwischen konversationsbezogener Sprachsuche und Web-Attribution zu schließen, testet Google eine neue Benutzeroberfläche, die bei gesprochenen Antworten in Echtzeit visuelle Zitatkarten einblendet. Die experimentelle Funktion, die im KI-Modus des Unternehmens entdeckt wurde, zielt darauf ab, den „Black-Box“-Charakter von Audiointeraktionen zu mildern.

Durch das Auftauchen von Quelllinks, während die KI spricht, geht das Update auf anhaltende Kritik an „Halluzinationen“, bei denen Modelle Fakten erfinden, und der Erosion des Publisher-Verkehrs ein. Es integriert die Konversationsfunktionen von Gemini Live direkt in das Kernsuchprodukt.

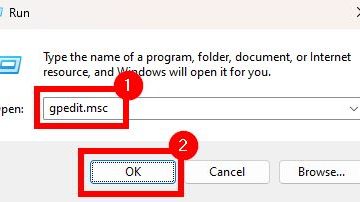

So funktioniert die neue Sprachschnittstelle

Das Update wurde vom SEO-Experten Sachin Patel während eines A/B-Tests entdeckt und bettet Search Live ein Funktion direkt in den Standard-KI-Modus-Schalter in der Google-App einbinden.

Im Gegensatz zu früheren Sprachassistenten, die oft als undurchsichtige „Black Boxes“ fungieren, generiert diese Schnittstelle visuelle Zitatkarten in Echtzeit. Während die KI eine Antwort vorträgt, werden relevante Quellenlinks auf dem Bildschirm angezeigt, sodass Benutzer bestimmte Behauptungen sofort überprüfen können.

Ist das neu im KI-Modus (meine Frage ist – was ist SEO darauf)? @brodieseo @rustybrick @gaganghotra_ pic.twitter.com/3N5hXtKmdm

– Sachin Patel (@SachuPatel53124) 6. Dezember 2025

Unter der Haube nutzt das System die multimodalen Fähigkeiten der kürzlich bereitgestellten Gemini 3-Integration. Dieses Modell-Upgrade wurde entwickelt, um komplexe, mehrstufige Abfragen zu verarbeiten, die die Synthese von Informationen aus unterschiedlichen Quellen erfordern.

Promo

Führungskräfte haben eine Veränderung in der Art und Weise festgestellt, wie Benutzer mit diesen leistungsfähigeren Modellen interagieren. Hema Budaraju, Senior Director of Product bei Google, bemerkte zuvor: „Mit dem KI-Modus tauchen Menschen bereits tiefer in komplexe Themen ein und stellen fast dreimal länger Fragen als bei herkömmlichen Suchen.“

Die Verlagerung dieser Funktionalität von der eigenständigen Gemini-App in die stark frequentierte Suchumgebung signalisiert einen großen strategischen Wandel. Es versucht, Konversations-KI als primäre Suchmethode und nicht als Neuheit zu normalisieren.

Die Vertrauenslücke: Halluzinationen mildern

Die Sprachsuche litt in der Vergangenheit unter einem Mangel an klaren Zuordnungen. Benutzer erhalten in der Regel eine synthetische Antwort, ohne zu wissen, woher die Informationen stammen, was die Überprüfung erschwert.

Strategisch gesehen folgt die Integration der Einführung der Deep Think Reasoning Engine von Google. Diese Architektur ermöglicht es dem Modell, innezuhalten und zu argumentieren, bevor es reagiert. Demis Hassabis, CEO von Google DeepMind, beschrieb es als „Googles fortschrittlichstes Modell für komplexe Aufgaben“, das „große Datensätze erfassen und Probleme aus verschiedenen Informationsquellen herausfordern kann“.

Trotz dieser Fortschritte bleibt die Zuverlässigkeit eine entscheidende Hürde für eine breite Akzeptanz. Unabhängige Untersuchungen deuten darauf hin, dass generative Suchergebnisse häufig erheblich von herkömmlichen Rankings abweichen.

Eine aktuelle Zuverlässigkeitsstudie quantifizierte diese Diskrepanz und kam zu dem Ergebnis, dass 53 % der Websites, die über die KI-Übersicht von Google verlinkt wurden, nicht in den Top-10-Ergebnissen einer herkömmlichen Suche auftauchten. Dies weist auf eine erhebliche Abweichung von den etablierten Ranking-Signalen der traditionellen Suche hin.

Solche Ergebnisse verdeutlichen die „Vertrauenslücke“, die visuelle Karten schließen sollen. Durch die Anzeige der spezifischen Quellen, die zur Generierung einer Antwort verwendet werden, versucht Google zu beweisen, dass seine KI seine Antworten auf tatsächliche Webinhalte stützt, anstatt Fakten zu erfinden.

Verkehr vs. Antworten

Für Medienunternehmen stellt die Umstellung auf „agentische“ Sprachsuche eine potenzielle Bedrohung für den Empfehlungsverkehr dar. Verleger befürchten, dass umfassende Sprachantworten das Klicken überflüssig machen, selbst wenn eine Zitierkarte sichtbar ist.

Plattformen wirken diesem Narrativ entgegen, indem sie versuchen, den Wert einer Suchinteraktion neu zu definieren. Sie argumentieren, dass das Volumen zwar sinken könnte, die Absicht des verbleibenden Datenverkehrs jedoch höher sei.

Microsoft hat sich besonders lautstark zu dieser Verschiebung der Kennzahlen geäußert. Fabrice Canel, Hauptproduktmanager bei Bing, argumentierte: „Für Vermarkter wird die Sichtbarkeit selbst zu einer Form der Währung. Wenn man Präferenzen formt, bevor überhaupt ein Klick erfolgt.“

Sowohl Microsoft als auch Google haben Daten veröffentlicht, die besagen, dass die Conversion-Rate-Ansprüche von KI-Empfehlungen bis zu dreimal höher sind als bei herkömmlichem Suchverkehr.

Medienmanager sind von dieser „Qualität vor Quantität“-Verteidigung nach wie vor nicht überzeugt. Viele betrachten das Scraping ihrer Daten für das KI-Training als einen grundlegenden Verstoß gegen den Werteaustausch im Internet.