Google DeepMind stellte am Donnerstag SIMA 2 vor, einen neuen KI-Agenten, der das Gemini-Modell nutzt, um in 3D-Videospielen zu lernen und zu agieren. Im Gegensatz zu seinem Vorgänger kann SIMA 2 über hochrangige Ziele nachdenken, mit Benutzern sprechen und sich selbst neue Fähigkeiten beibringen.

Es wurde in beliebten Spielen wie Goat Simulator 3 trainiert und kann sogar in Welten spielen, die es noch nie zuvor gesehen hat. Das Projekt von DeepMind ist ein wichtiger Schritt in Richtung seines Ziels, allgemeine KI aufzubauen. Das Labor hofft, dass in Spielen erlernte Fähigkeiten eines Tages hilfreiche Roboter in der realen Welt antreiben werden.

Vom Befehlsfolger zum Argumentationsbegleiter

Durch die Einbettung eines Gemini-Modells in den Kern geht SIMA 2 über einfache Befehle hinaus. Sein Vorgänger, das ursprüngliche SIMA, das im März 2024 eingeführt wurde, war ein entscheidender erster Schritt und erlernte die Ausführung von über 600 Sprachfolgefähigkeiten wie „die Leiter erklimmen“ in verschiedenen virtuellen Welten.

Dieser Agent operierte, indem er den Bildschirm beobachtete und eine virtuelle Tastatur und Maus verwendete, genau wie ein menschlicher Spieler. SIMA 2 baut auf dieser Grundlage auf, fügt jedoch eine entscheidende Ebene der Erkenntnis hinzu und entwickelt sich von einem Tool zu einem interaktiven Partner.

Jetzt kann der Agent das übergeordnete Ziel eines Benutzers und die Gründe für die Schritte verstehen, die zur Erreichung dieses Ziels erforderlich sind.

Dadurch wird die Interaktion von der Erteilung von Befehlen zur Zusammenarbeit mit einem Begleiter.

„Spiele sind seit geraumer Zeit eine treibende Kraft in der Agentenforschung“, sagt Joe Marino, ein Forschungswissenschaftler bei Google DeepMind, während einer Pressekonferenz.

Die Integration von Gemini ermöglicht es SIMA 2, seine Absichten zu beschreiben und seine Aktionen zu erklären, wodurch der Prozess für den Benutzer transparenter und interaktiver wird.

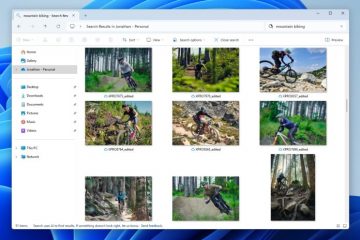

[eingebetteter Inhalt]

Die Schulung umfasste eine Mischung aus menschlichen Demonstrationsvideos und von Gemini generierten Etiketten. DeepMind hat mit zahlreichen Spieleentwicklern zusammengearbeitet, darunter Coffee Stain (Valheim, Satisfactory, Goat Simulator 3), Hello Games (No Man’s Sky) und Tuxedo Labs (Teardown), um ein vielfältiges Spiel aufzubauen Trainingsgelände.

Die Auseinandersetzung mit verschiedenen Genres und Spielmechaniken ist der Schlüssel zur Entwicklung eines generalistischen Agenten, der nicht an die Regeln einer einzelnen Umgebung gebunden ist.

Ein tugendhafter Kreislauf: Selbstverbesserung in generierten Welten

Einer der bedeutendsten Fortschritte von SIMA 2 ist seine Fähigkeit, sich selbst zu verbessern. Nach einer ersten Phase des Lernens durch menschliche Demonstrationen kann der Agent in eine Selbstverbesserungsschleife eintreten.

Er übt sich in neuen Spielen durch selbstgesteuertes Spielen, nutzt Versuch und Irrtum und erhält Feedback vom Gemini-Modell, um seine Fähigkeiten zu verfeinern.

Dieser Prozess ermöglicht es ihm, neue Aufgaben zu meistern, ohne dass zusätzliche von Menschen generierte Daten erforderlich sind, ein wichtiger Meilenstein auf dem Weg zum skalierbaren Lernen.

Um die Grenzen dieser Fähigkeit zu erweitern, kombinierte DeepMind SIMA 2 mit einem anderen eines seiner ehrgeizigen Projekte: Genie 3.

Genie 3 ist ein Weltmodell, das aus einer einfachen Texteingabe neue, spielbare 3D-Umgebungen generieren kann. Seine Architektur ist auf Konsistenz ausgelegt und, wie Forschungsdirektorin Shlomi Fruchter erklärte, „autoregressiv, das heißt, es generiert jeweils einen Frame. Es muss auf das zurückblicken, was zuvor generiert wurde, um zu entscheiden, was als nächstes passieren wird.“

Sequentielle Generierung ist entscheidend für die Schaffung stabiler Welten, in denen ein Agent lernen kann.

Als SIMA 2 in diese völlig neuartigen, KI-generierten Welten eingesetzt wurde, zeigte es eine bemerkenswerte Fähigkeit, sich anzupassen, sich zu orientieren und auszuführen Benutzeranweisungen.

Diese Synergie schafft ein leistungsstarkes Trainings-Dojo. Genie 3 kann eine nahezu unbegrenzte Vielfalt an Szenarien generieren und stellt einen endlosen Lehrplan für SIMA 2 dar, aus dem man lernen kann.

DeepMinds Strategie zum Aufbau robusterer und anpassungsfähigerer KI basiert auf diesem Ansatz.

„Wir glauben, dass Weltmodelle der Schlüssel auf dem Weg zu AGI sind, insbesondere für verkörperte Agenten, bei denen die Simulation realer Szenarien eine besondere Herausforderung darstellt“, erklärte Jack Parker-Holder, ein Forschungswissenschaftler im Team.

Die Simulation unzähliger Situationen ist eine sicherere und effizientere Möglichkeit, einer KI die Komplexität von Interaktionen beizubringen.

Jenseits des Spiels: Der Weg zur verkörperten AGI und ihre Hürden

Während der unmittelbare Kontext Videospiele sind, liegt DeepMinds ultimatives Ziel in der physischen Welt. Fähigkeiten, die SIMA 2 lernt – Navigation, Werkzeugnutzung, Planung und Zusammenarbeit – sind grundlegende Bausteine für verkörperte Intelligenz.

Das Unternehmen sieht diese Forschung als einen direkten Weg zur Schaffung leistungsfähiger KI-Assistenten und Roboter, die in menschlichen Umgebungen sicher und effektiv arbeiten können.

„SIMA 2 bestätigt, dass eine auf breite Kompetenz trainierte KI … die Fähigkeiten vieler spezialisierter Systeme erfolgreich in einem kohärenten, generalistischen Agenten vereinen kann“, erklärte das SIMA-Team in ihrem Bericht Ankündigung, in der das Projekt als Vereinigung spezialisierter Systeme zu einem einzigen, kohärenten Agenten dargestellt wird.

Der Weg von virtuellen Welten in die Realität ist jedoch mit Herausforderungen behaftet. Experten auf diesem Gebiet erkennen zwar die technische Errungenschaft an, mahnen jedoch zur Vorsicht hinsichtlich der direkten Anwendbarkeit dieser Fähigkeiten.

Julian Togelius, ein KI-Forscher an der New York University, betonte die Schwierigkeit des Ansatzes und stellte fest, dass „das Spielen in Echtzeit nur anhand visueller Eingaben ein ‚harter Modus‘ ist.“ Der Agent muss Rohpixel ohne zugrunde liegende Spieldaten interpretieren, eine Aufgabe, die rechenintensiv und fehleranfällig ist.

Darüber hinaus gibt es Fragen dazu, wie gut sich diese erlernten Verhaltensweisen auf die Robotik übertragen lassen.