OpenAI hat sein Entwicklerangebot durch die Einführung der Vollversion seines o1-Modells über seine API erweitert. Dieses fortschrittliche Argumentationsmodell, das sich hervorragend für komplexe, mehrstufige Aufgaben eignet, führt neue Funktionen ein, die versprechen, die Art und Weise, wie Entwickler KI-gestützte Anwendungen erstellen, neu zu gestalten.

Das Update ist Teil der Ankündigungsreihe „12 Days of OpenAI“, in der das Unternehmen neue Funktionen und Updates für seine Hauptprodukte veröffentlicht.

Neben dem o1-Modell hat OpenAI Folgendes veröffentlicht kündigte außerdem Verbesserungen seiner Echtzeit-API für Sprachinteraktionen und eine neue Methode zur Feinabstimmung von Präferenzen an, die Entwicklern beispiellose Flexibilität bietet.

Das Modell o1-2024-12-17 ersetzt die Anfang des Jahres eingeführte o1-Preview-Version. Das aktualisierte Modell bietet „umfassender“. und genaue Antworten, insbesondere auf Fragen im Zusammenhang mit der Programmierung und dem Geschäft, und es ist weniger wahrscheinlich, dass Anfragen fälschlicherweise abgelehnt werden.“ Diese Verbesserungen, gepaart mit einer Reduzierung der Reasoning-Token-Nutzung um 60 %, machen das o1-Modell schneller, effizienter und vielseitiger.

Fortschrittliches Reasoning über API mit dem o1-Modell

Das o1-Modell von OpenAI ist für die Bewältigung von Aufgaben konzipiert, die logische Konsistenz und analytische Tiefe erfordern, und übertrifft frühere Iterationen bei Benchmarks wie SWE-Bench Verified und AIME.

OpenAI berichtet, dass die Genauigkeit bei Programmieraufgaben von 52,3 % auf 76,6 % gestiegen ist, während die Leistung bei mathematischen Problemen von 42 % auf fast 80 % gestiegen ist.

Quelle: OpenAI

Eine herausragende Funktion ist die strukturierte Ausgabeunterstützung, die es Entwicklern ermöglicht, Antworten zu generieren in vordefinierten Formaten wie JSON.

Dies gewährleistet eine nahtlose Integration mit externen Systemen wie APIs und Datenbanken und macht das Modell ideal für Anwendungen in der Kundenbetreuung, Logistik und Datenanalyse.

Das Modell führt außerdem visuelle Argumentationsfunktionen ein, Ermöglicht die Analyse von Bildern für Aufgaben wie Debugging oder wissenschaftliche Forschung. Beispielsweise können Entwickler jetzt visuelle Daten wie gescannte Dokumente oder Baupläne eingeben und kontextbezogene Antworten erhalten.

Darüber hinaus können Entwickler mit einem neuen Parameter „Begründungsaufwand“ steuern, wie lange das Modell für jede Aufgabe aufwendet, und so Präzision und Effizienz in Einklang bringen.

OpenAI erklärte in seinem Blog: „Wir sind am Laufen Den Zugriff schrittweise ausbauen und gleichzeitig daran arbeiten, den Zugriff auf zusätzliche Nutzungsebenen zu erweitern und die Ratenlimits zu erhöhen Updates zu seiner Echtzeit-API, die Sprachinteraktionen in Echtzeit ermöglicht. Durch die Hinzufügung von WebRTC, Web Real-Time Communication – einem Protokoll für Kommunikation mit geringer Latenz – können Entwickler nahtlose Sprachanwendungen für virtuelle Tutoren, Assistenten und Übersetzungstools erstellen. Es ermöglicht Peer-to-Peer-Verbindungen (P2P), ohne dass zusätzliche Plugins oder Software erforderlich sind.

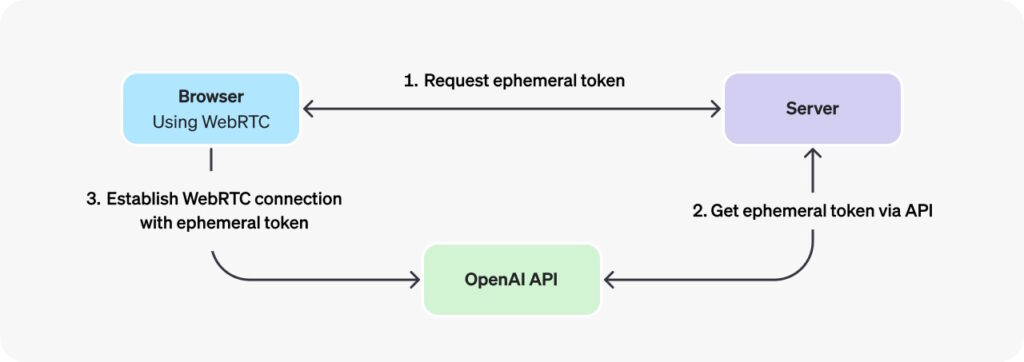

OpenAI hob die Vorteile von WebRTC hervor, sagt: „In Szenarien, in denen Sie von einem unsicheren Client über das Netzwerk (wie einem Webbrowser) eine Verbindung zu einem Echtzeitmodell herstellen möchten, empfehlen wir die Verwendung der WebRTC-Verbindungsmethode. WebRTC ist besser für den Umgang mit variablen Verbindungszuständen gerüstet und bietet eine Reihe praktischer APIs zum Erfassen von Benutzer-Audioeingaben und zum Abspielen von Remote-Audiostreams aus dem Modell.“

Die Implementierung von WebRTC verwendet sogenannte ephemere Token. Temporäre API-Schlüssel, die speziell für die sichere Authentifizierung clientseitiger Anwendungen bei der Verbindung mit der OpenAI Realtime API über WebRTC entwickelt wurden. Ihr Zweck besteht darin, einen sicheren, kurzlebigen Authentifizierungsmechanismus sicherzustellen, der verhindert, dass sensible Standard-API-Schlüssel direkt in Client-Umgebungen wie Webbrowsern offengelegt werden.

Bild: OpenAI

Bild: OpenAI

Die Upgrades der Realtime API vereinfachen den Entwicklungsprozess, reduzieren den für Sprachanwendungen erforderlichen Code und verbessern gleichzeitig die Audioqualität und Antwortgenauigkeit. Entwickler können jetzt Anwendungen erstellen, die mit der Formulierung von Antworten beginnen, während die Benutzer noch sprechen, und so die Reaktionsfähigkeit verbessern.

Preisanpassungen machen Sprachanwendungen zugänglicher. Die Kosten für GPT-4o-Audio-Tokens wurden um 60 % gesenkt, während zwischengespeicherte Eingabe-Tokens jetzt 87,5 % günstiger sind. OpenAI hat außerdem GPT-4o mini eingeführt, eine kostengünstige Option für Entwickler, die erschwingliche Alternativen suchen, zum Preis von 10 US-Dollar pro Million Eingabe-Token.

Verfeinerung des KI-Verhaltens durch Feinabstimmung der Präferenzen

Präferenz-Feinabstimmung ist eine neue Anpassungsmethode, die es Entwicklern ermöglicht, das Modellverhalten basierend auf paarweisen Vergleichen von Antworten zu verfeinern. Im Gegensatz zur herkömmlichen Feinabstimmung, die auf exakten Eingabe-Ausgabe-Paaren beruht, lehrt die Präferenz-Feinabstimmung das Modell, zwischen bevorzugten und weniger wünschenswerten Reaktionen zu unterscheiden.

OpenAI beschreibt diese Methode als besonders effektiv für subjektive Aufgaben, wie z B. die Anpassung von Ton und Stil beim kreativen Schreiben oder die Sicherstellung der Einhaltung spezifischer Formatierungsanforderungen. Laut OpenAI berichteten Frühanwender wie ein Finanzanalyseunternehmen, dass die Feinabstimmung der Präferenzen die Antwortgenauigkeit bei komplexen, nicht verteilten Abfragen um 5 % verbesserte.

„Wir haben mit dem Testen der Feinabstimmung der Präferenzen begonnen vertrauenswürdige Partner, die bisher vielversprechende Ergebnisse erzielt haben. Rogo AI(opens in a new window) entwickelt beispielsweise einen KI-Assistenten für Finanzanalysten, der komplexe Abfragen in Unterabfragen zerlegt.

Anhand ihres von Experten erstellten Benchmarks Rogo-Golden stellten sie fest, dass Supervised Fine-Tuning zwar mit Herausforderungen durch eine Abfrageerweiterung außerhalb der Verteilung konfrontiert war – etwa fehlende Metriken wie ARR für Abfragen wie „Wie schnell ist?“. Unternehmen Entwickler

Um ein breiteres Spektrum an Programmierumgebungen zu unterstützen, hat OpenAI auch offizielle SDKs für Go und Java, danebens vorhandene Bibliotheken für Python, Node.js und.NET. Diese SDKs vereinfachen die Integration und ermöglichen Entwicklern die Bereitstellung von KI-Modellen in skalierbaren Backend-Systemen oder Unternehmen Anwendungen.

Das Go SDK ist für leichte und effiziente serverseitige Anwendungen konzipiert, während das Java SDK für Lösungen der Enterprise-Klasse konzipiert ist und starke Typisierung und robuste Unterstützung für Großprojekte bietet. Die Dokumentation von OpenAI bietet detaillierte Anleitungen zur Nutzung dieser neuen Tools.