Anthropic hat heute Claude Opus 4.5 herausgebracht und damit den branchenweit besten Coding-Score erreicht und einen bedeutenden Architekturwechsel zur Senkung der Kosten eingeleitet.

Durch die Senkung der Preise um 66 % auf 5 US-Dollar pro Million Eingabe-Tokens und den Einsatz von „Tool Search“, um den Kontext-Overhead um 85 % zu reduzieren, greift das Unternehmen direkt das wichtigste wirtschaftliche Hindernis für autonome KI-Agenten an.

Das Modell erreicht einen Score von 80,9 % Von der SWE-Benchmark bestätigt, verdrängte er die jüngsten Versionen von Google und OpenAI knapp und eroberte sich die Leistungskrone für komplexe Softwareentwicklungsaufgaben zurück.

The Benchmark Wars: Reclaiming the Crown

Opus 4.5 erreicht eine Punktzahl von 80,9 % im SWE-Bench Verified, dem aktuellen Goldstandard für die Bewertung autonomer Software-Engineering-Fähigkeiten. Damit übertrifft es die Konkurrenz und übertrifft die Markteinführung von Googles Gemini 3 Pro mit 76,2 % und GPT-5.1-Codex-Max mit 77,9 %.

Interne Bewertungen deuten darauf hin, dass das Modell bei Anthropics eigenen technischen Take-Home-Tests nun besser abschneidet als menschliche Kandidaten. „Opus 4.5 ist ein Fortschritt in der Leistungsfähigkeit von KI-Systemen und eine Vorschau auf größere Änderungen bei der Art und Weise, wie Arbeit erledigt wird“, erklärte das Unternehmen in seiner Ankündigung.

Um Kosten und Leistungsfähigkeit in Einklang zu bringen, ermöglicht ein neuer „Aufwand“-Parameter Entwicklern, die Argumentationstiefe des Modells während API-Aufrufen dynamisch anzupassen. Bei „mittlerem“ Aufwand erreicht Opus 4.5 die Spitzenleistung des vorherigen Sonnet 4.5-Modells, verbraucht jedoch 76 % weniger Ausgabetoken.

Die Einstellung „hoher“ Aufwand übertrifft die Möglichkeiten von Sonnet 4.5 um 4,3 Prozentpunkte und verschiebt die Grenze der automatisierten Problemlösung. Der November hat sich als aktiver Monat in der KI erwiesen, da alle drei großen Labore zwischen dem 18. und 24. ihre Flaggschiff-Codierungsmodelle einsetzen.

The Economic Shift: Pricing and Architecture

Anthropic hat die Bedenken der Unternehmen hinsichtlich der Realisierbarkeit teurer „Argumentations“-Modelle berücksichtigt und das Modell aggressiv auf 5 US-Dollar pro Million Input-Tokens und 25 US-Dollar pro Million Output-Tokens angehoben.

Im Vergleich zur vorherigen Opus-Generation (15 $/75 $) bietet der neue Tarif einen Rabatt von 66 %, wie in Einführung von Claude Opus 4.5 beschrieben.

Unter der Haube geht die Architektur das Problem des „Context Bloat“ an. Traditionell konnte das Laden von mehr als 50 Werkzeugdefinitionen etwa 55.000 Token verbrauchen, bevor eine einzelne Benutzerabfrage verarbeitet wurde.

Laut der Dokumentation zur erweiterten Werkzeugverwendung ändert das neue System diese Dynamik grundlegend:

„Anstatt alle Werkzeugdefinitionen im Voraus zu laden, wird das Tool Search Tool verwendet erkennt Tools bei Bedarf. Claude sieht nur die Tools, die er tatsächlich für die aktuelle Aufgabe benötigt

In der technischen Dokumentation werden die Mechanismen von PTC weiter erläutert:

„Anstatt dass Claude jedes einzelne Werkzeug einzeln anfordert und jedes Ergebnis in seinen Kontext zurückgibt, schreibt Claude Code, der mehrere Werkzeuge aufruft, deren Ausgaben verarbeitet und steuert, welche Informationen tatsächlich in das Kontextfenster gelangen.“

„Claude zeichnet sich durch das Schreiben von Code aus, und indem er Orchestrierungslogik in Python statt durch Werkzeugaufrufe in natürlicher Sprache ausdrücken lässt, erhalten Sie einen zuverlässigeren und präziseren Kontrollfluss.“

PTC macht Round-Trip-Inferenzschritte für jeden einzelnen Tool-Aufruf überflüssig und reduziert so die Latenz erheblich. Die Verarbeitung umfangreicher Datensätze, wie z. B. 200 KB roher Ausgabendaten, wird realisierbar, da das Modell nur das 1 KB große Endergebnis an das Kontextfenster zurückgibt.

„Um effektive Agenten zu entwickeln, müssen sie mit unbegrenzten Werkzeugbibliotheken arbeiten, ohne jede Definition im Voraus in den Kontext zu stopfen“, bemerkte das Anthropic Engineering-Team.

Ökosystemerweiterung: Chrome, Excel und Sicherheit

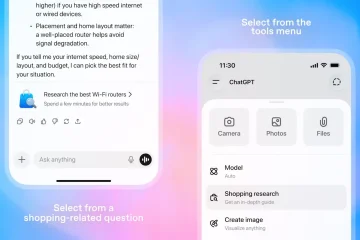

Über das Kernmodell hinaus „Claude Code“ ist von der Betaversion zur allgemeinen Verfügbarkeit übergegangen und bietet eine vollständige Desktop-Anwendung für Entwickler-Workflows. Durch neue Integrationen kann das Modell den Chrome-Browser direkt steuern und geht über die Textgenerierung hinaus auf aktive Recherche und Aufgabenausführung.

[eingebetteter Inhalt]

Eine dedizierte Excel-Integration ist auf die Finanzmodellierung ausgerichtet und ermöglicht es dem Modell, Tabellenkalkulationen mit Tausenden von Zeilen zu bearbeiten.

Dianne Na Penn, Leiterin des Produktmanagements für Forschung bei Anthropic, betonte die Bedeutung dieser Fähigkeit: „Die richtigen Details zu kennen, die man sich merken muss, ist wirklich wichtig, zusätzlich zu einem längeren Kontextfenster.“

[eingebetteter Inhalt]

Sicherheit bleibt eine zentrale Säule der Veröffentlichung. Die Systemkarte Claude Opus 4.5 hebt bedeutende Investitionen in die Minderung chemischer, biologischer, radiologischer und nuklearer (CBRN) Risiken hervor.

Die Systemkarte beschreibt explizit den Ausrichtungsstatus des Modells:

„Opus 4.5 ist das am stärksten ausgerichtete Modell, das wir haben.“ Bisher veröffentlicht und wir vermuten, dass es das am besten abgestimmte Grenzmodell aller Entwickler ist.“

„Opus 4.5 lässt sich mit Prompt-Injection schwerer austricksen als jedes andere Grenzmodell in der Branche.“

Marktrealität: Das Zeitalter der Agenten

Im Kontext der Markteinführung hat der „November AI Rush“ dazu geführt, dass Google, OpenAI und Anthropic gleichzeitig auf autonome Agenten umgestiegen sind. Die Narrative haben sich von „Chatbots“ zu „Agenten“ gewandelt, die in der Lage sind, Aufgaben über 24 Stunden lang aufrechtzuerhalten.

Während Anthropic bei Roh-Benchmarks führend ist (80,9 %), ist der Abstand hauchdünn, wobei weniger als 5 Prozentpunkte zwischen den drei Spitzenkandidaten liegen. Ein wichtiger Kompromiss besteht in der neuen Architektur: „Tool Search“ führt einen Suchschritt ein, der die Latenz erhöhen kann, verglichen mit dem Vorladen aller Tools im Kontext.

Im Gegensatz zur Windows-nativen Optimierung von OpenAI mit Codex-Max setzt Anthropic auf einen plattformunabhängigen Desktop-Ansatz. Als neues Schlachtfeld hat sich die Speicherverwaltung herausgestellt, wobei OpenAI „Komprimierung“ nutzt und Anthropic „Tool Search“ einsetzt, um denselben Kontextfenster-Engpass zu lösen.