Während die Google-Führung öffentlich vor „Irrationalität“ auf dem KI-Markt warnt, hat sie privat eine aggressive Erweiterung der Infrastruktur angeordnet, um die KI-Bereitstellungskapazität alle sechs Monate zu verdoppeln.

Laut eine Präsentation, die CNBC diese Woche gesehen hat, zielt die Richtlinie auf eine 1.000-fache Vergrößerung innerhalb von fünf Jahren ab, um das rechenlastige „Zeitalter der Inferenz“ zu unterstützen.

Dieser interne Auftrag, der vom Vizepräsidenten für Infrastruktur, Amin Vahdat, erteilt wurde, steht in krassem Gegensatz zu den jüngsten Kommentaren von CEO Sundar Pichai zu ein Interview mit der BBC über eine mögliche Blase.

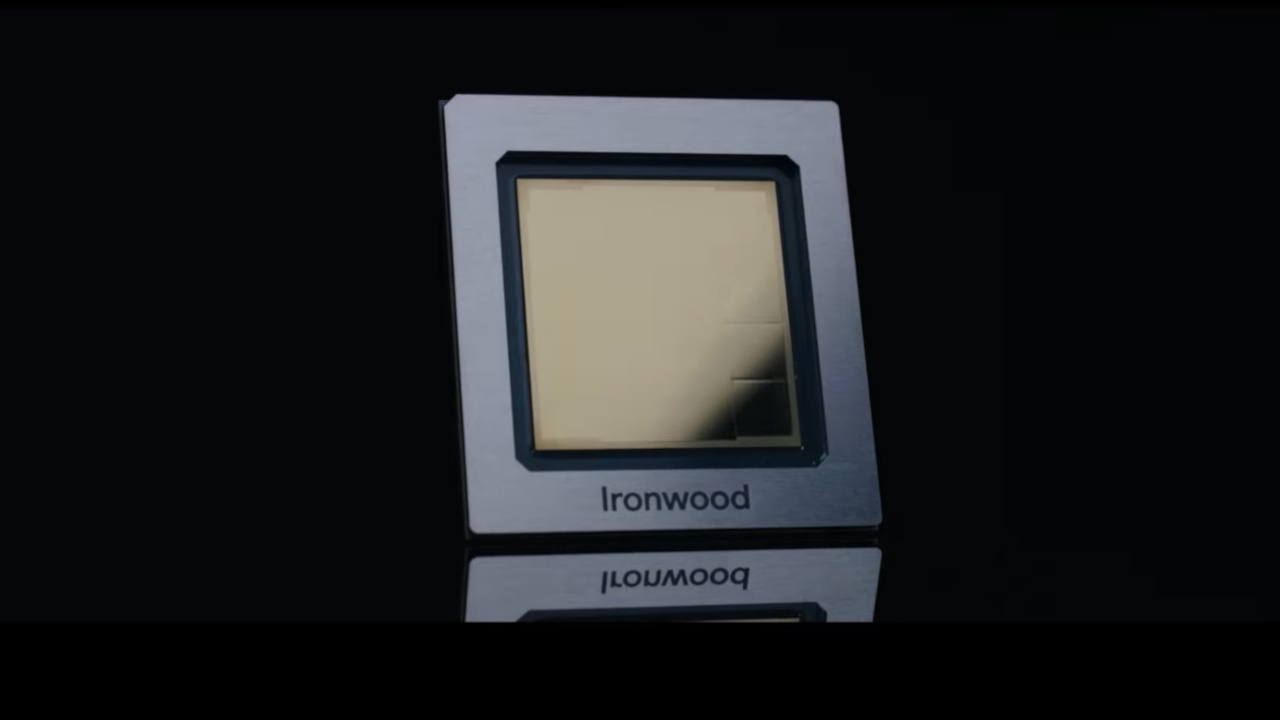

Angetrieben von existenzieller Angst Aufgrund von Unterinvestitionen setzt die Strategie auf kundenspezifische Chips wie die Ironwood TPU-Chips von Google, um zu verhindern, dass die Kosten mit dem Kapazitätswachstum in die Höhe schießen.

Das 1.000-fache Mandat: Im War Room von Google

Details, die aus dem All-Hands-Meeting am 6. November hervorgehen, zeichnen das Bild eines Unternehmens, das sich in Kriegszeiten befindet.

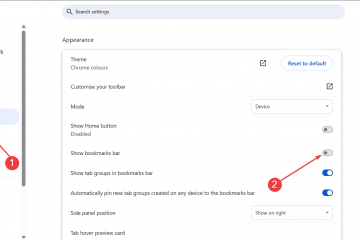

Infrastruktur-Vizepräsident Amin Vahdat präsentierte eine Roadmap mit dem Titel „KI-Infrastruktur“, die die exponentiellen Wachstumsanforderungen darlegt, die notwendig sind, um mit der Nachfrage Schritt zu halten. Ausdrücklich verlangt die Richtlinie von Google, seine KI-Bereitstellungskapazität alle sechs Monate zu verdoppeln, um seine Wettbewerbsposition zu behaupten.

Langfristige Prognosen zielen auf eine unglaubliche Steigerung der Kapazität um das Tausendfache innerhalb von nur vier bis fünf Jahren. Diese Beschleunigung wird nicht durch Modelltraining vorangetrieben, das in der Vergangenheit den Großteil der Rechenressourcen verbraucht hat, sondern durch einen grundlegenden Wandel hin zum „Zeitalter der Inferenz“.

Modelle wie das kürzlich eingeführte Gemini 3 Pro erfordern enorme, kontinuierliche Rechenleistung, um Argumentationsaufgaben auszuführen und Code auszuführen.

Vahdat warnte, dass „der Wettbewerb in der KI-Infrastruktur der kritischste und auch teuerste Teil des KI-Wettlaufs ist.“

Dieses Gefühl wurde durch CEO Sundar Pichai bekräftigt, der Fehlschläge zitierte Aufgrund von Hardwareeinschränkungen gibt es mit dem Videogenerierungstool des Unternehmens, Veo, keine Möglichkeiten. Pichai gab zu, dass trotz des starken Cloud-Wachstums „diese Zahlen viel besser ausgefallen wären, wenn wir mehr Rechenleistung gehabt hätten.“

Weit davon entfernt, angesichts der Skepsis des Marktes nachzugeben, wird 2026 in der internen Stimmung als ein „intensives“ Jahr mit „Aufs und Abs“ beschrieben. Die Botschaft der Führung ist klar: Das Haupthindernis für Wachstum ist nicht mehr die Softwarefähigkeit, sondern die physische Verfügbarkeit von Rechenleistung.

Der Silicon Shield: Ironwood, Axion und die Effizienzfalle

Eine Kapazitätsskalierung um das 1.000-fache mit handelsüblicher Hardware wäre finanziell ruinös. Die Strategie von Google basiert auf der Entkopplung von Leistungssteigerungen und linearen Kostensteigerungen. Vahdat skizzierte die technischen Anforderungen:

„Google muss in der Lage sein, 1.000-mal mehr Kapazität, Rechenleistung und Speichernetzwerke für im Wesentlichen die gleichen Kosten und zunehmend die gleiche Leistung und das gleiche Energieniveau bereitzustellen“, sagte Vahdat.“

Diesem massiven Ausbau liegt eine einfache, aber brutale wirtschaftliche Realität zugrunde: Effizienz ist der einzige Weg zur Nachhaltigkeit. Der Rückgriff auf die Ironwood TPU, die erst seit Kurzem allgemein verfügbar ist, ist von zentraler Bedeutung für diese Strategie.

Dieser Chip der siebten Generation verspricht eine zehnfache Spitzenleistungsverbesserung gegenüber dem v5p und bietet im Vergleich zur vorherigen Trillium-Generation die doppelte Leistung pro Watt.

Allzweck-Workloads werden auf die neuen Arm-basierten Axion-CPUs verlagert, um Strom und thermischen Spielraum für KI-Aufgaben freizugeben. Durch die Verlagerung von Standard-Rechenaufgaben auf effizientere Prozessoren möchte Google die für seine stromhungrigen TPUs verfügbare Energie maximieren.

In einer „Co-Design“-Philosophie integrieren Ingenieure Software direkt in die Hardware-Architektur. Untersuchungen von Google DeepMind fließen in das Chip-Design ein und ermöglichen es dem Unternehmen, dort Vorteile zu erzielen, wo Standard-Hardware nicht möglich ist. Vahdat bemerkte: „Es wird nicht einfach sein, aber durch Zusammenarbeit und Co-Design werden wir dorthin gelangen.“

Die „Effizienzfalle“ zeichnet sich jedoch ab. Jevons Paradoxon legt nahe, dass mit zunehmender Recheneffizienz die Nachfrage steigt, um den Überschuss zu verbrauchen, was Kosteneinsparungen zunichte macht. Sollten die Inferenzkosten sinken, wird erwartet, dass das Volumen der Abfragen – angetrieben durch Agenten-Workflows und „Deep Think“-Argumentation – explodiert und der Gesamtenergieverbrauch hoch bleibt.

Das Blasenparadoxon: Wetten gegen „Irrationalität“

Inmitten wachsender externer Skepsis hinsichtlich der Kapitalrendite (ROI) für generative KI schreitet diese aggressive interne Expansion voran.

In einem Interview mit der BBC: Pichai räumte ein, dass die aktuelle Marktbewertung von KI „Elemente der Irrationalität“ aufweist. Trotz dieser öffentlichen Vorsicht hat Alphabet seine Investitionsprognose für 2025 auf 93 Milliarden US-Dollar angehoben, wobei für 2026 eine „deutliche Steigerung“ geplant ist.

Mitarbeiter stellten die Führung zu dieser Diskrepanz während der Frage-und-Antwort-Runde direkt in Frage. Eine Frage befasste sich speziell mit der Spannung zwischen steigenden Ausgaben und der Angst vor einer Marktkorrektur:

„Wie denken wir angesichts erheblicher Al-Investitionen und Marktgesprächen über ein mögliches Platzen der Al-Blase darüber nach, langfristige Nachhaltigkeit und Rentabilität sicherzustellen, wenn der Al-Markt nicht wie erwartet reift?“

Pichais Verteidigung stützt sich auf die Bilanz des Unternehmens. Er argumentierte: „Wir sind besser in der Lage, Fehlschlägen standzuhalten als andere Unternehmen.“

Defensiv geht die Logik davon aus, dass das Risiko, zu wenig zu investieren – und möglicherweise irrelevant zu werden – existenziell ist, wohingegen Überinvestitionen lediglich teuer sind.

Solche Überlegungen treiben derzeit den anhaltenden KI-Capex-Boom voran, bei dem der Ausbau der Infrastruktur von der unmittelbaren Umsatzrealität abgekoppelt ist. Google setzt faktisch darauf, dass es die Konkurrenz in einem kapitalintensiven Zermürbungskrieg überdauern kann.

Marktrealität: Das Gefangenendilemma der KI

Gemeinsam werden die „Großen Vier“ – Google, Microsoft, Amazon und Meta – laut Von CNBC zitierte Zahlen. Jensen Huang, CEO von Nvidia, wies diese Woche das „Blasen“-Narrativ ausdrücklich zurück und verwies auf eine konkrete Nachfrage, eine Ansicht, gegen die sich Google absichern muss.

Der Konkurrent OpenAI steht vor seinen eigenen Problemen. Ein internes Memo von Sam Altman, das diese Woche aufgetaucht ist, deutet darauf hin, dass sich der Branchenführer zunehmend mit den wirtschaftlichen Realitäten der Skalierung auseinandersetzt. Dies eröffnet Google die Möglichkeit, seine vertikale Integration zu nutzen.

Die Verlagerung des Engpasses von der Datenverfügbarkeit hin zur reinen Geschwindigkeit und Kosten der Token-Generierung ist das „Zeitalter der Inferenz“. Der besondere Vorteil von Google liegt in seinem maßgeschneiderten Silizium-Stack, der es dem Unternehmen möglicherweise ermöglicht, einen margenvernichtenden Preiskampf besser zu überstehen als Unternehmen, die ausschließlich auf Nvidia-Hardware angewiesen sind.

Jüngste Produkteinführungen wie Gemini 3 Pro und Gemini 3 Pro Image treiben diese Nachfrage weiter an. Letztendlich hängt das Ergebnis davon ab, ob Premium-Funktionen wie „Deep Think“ und Agenten-Workflows schneller Umsatz generieren können, als die Hardware an Wert verliert.

Trotz der damit verbundenen enormen Kosten scheint Google bisher einer „Bauen Sie es und sie werden kommen“-Strategie verpflichtet zu sein.