Weniger als vier Monate nach der Vorstellung seines videofokussierten Segment Anything Model 2 hat Meta SAM 3 und SAM 3D veröffentlicht und die fortschrittlichen Computer-Vision-Modelle sofort in Verbraucherprodukten wie Facebook Marketplace und Instagram eingesetzt.

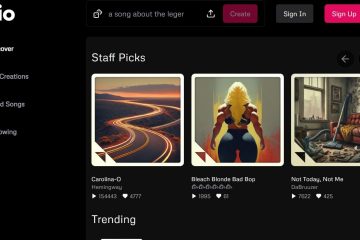

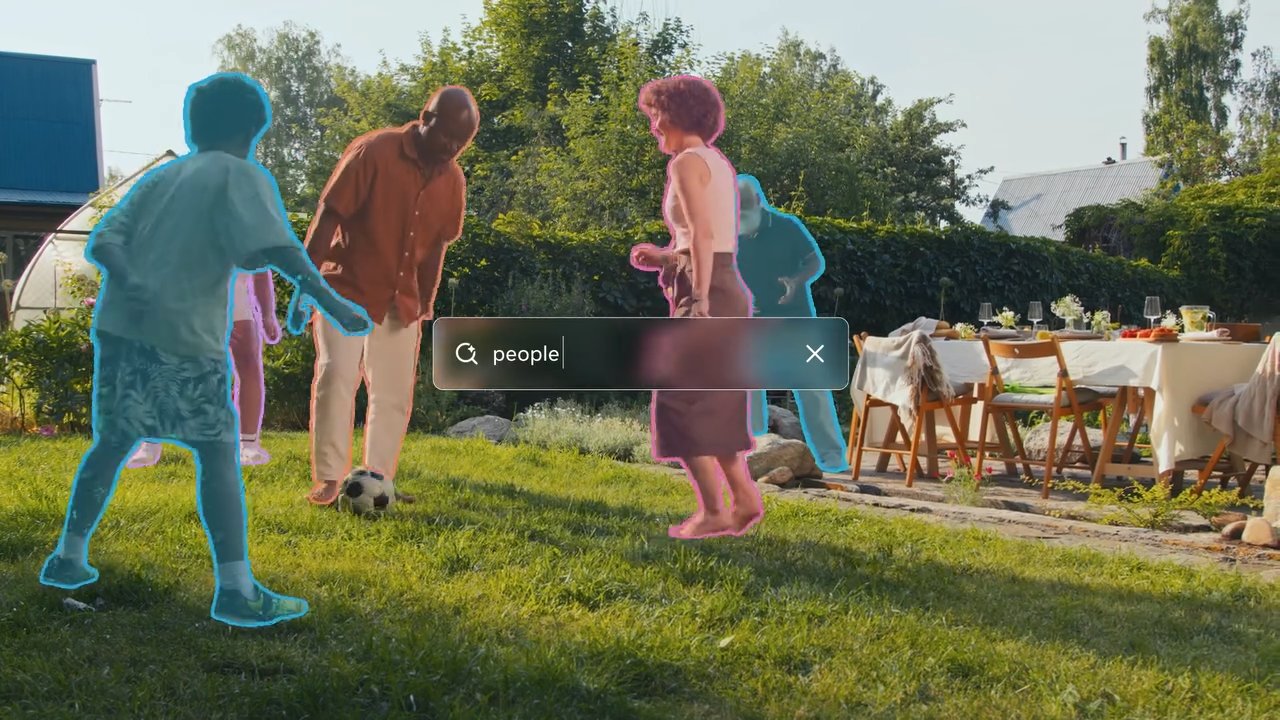

Beide Tools geben Computern ein viel besseres Verständnis dessen, was sie sehen. Mit SAM 3 können Benutzer eine Beschreibung eingeben und die KI sofort jedes passende Objekt in einem Foto oder Video finden und hervorheben lassen.

SAM 3D geht noch einen Schritt weiter, indem es ein flaches, zweidimensionales Bild aufnimmt und vorhersagt, wie das Objekt aus anderen Blickwinkeln aussieht, wodurch ein Standardfoto effektiv in ein drehbares 3D-Modell umgewandelt wird.

Während frühere Iterationen größtenteils im Forschungsbereich blieben, markiert dieses Update einen schnellen Übergang zu angewandtem Nutzen und ermöglicht Funktionen, die es Benutzern ermöglichen, Möbel in ihren Häusern zu visualisieren oder Effekte auf bestimmte Objekte in Videos anzuwenden.

Die neuen Modelle führen das „Promptable Concept“ ein „Segmentierung“, die eine textgesteuerte Identifizierung aller übereinstimmenden Objekte in einer Szene ermöglicht, und eine hochauflösende 3D-Rekonstruktion aus einzelnen 2D-Bildern – Fähigkeiten, die Meta-Claims bestehende Benchmarks bei weitem übertreffen.

Die Veröffentlichung von SAM 2 im Jahr 2024 konzentrierte sich stark auf die Effizienz der Videosegmentierung, aber die heutige Ankündigung erweitert den Anwendungsbereich erheblich, um semantisches Verständnis und 3D-Generierung einzubeziehen.

Von der Forschung zum Produkt: Sofort Integration

Meta durchbricht den traditionellen Zyklus von der Forschung bis zum Produkt und umgeht die typische Inkubationsphase, um SAM 3 direkt in seine Flaggschiff-Anwendungen zu integrieren.

Benutzer des Facebook-Marktplatzes werden jetzt auf eine von SAM 3D unterstützte „View in Room“-Funktion stoßen, mit der potenzielle Käufer visualisieren können, wie Möbelstücke in ihren eigenen Wohnräumen aussehen würden, bevor sie einen Kauf tätigen.

Diese Anwendung nutzt die Fähigkeit des Modells dazu Rekonstruieren Sie 3D-Objekte aus einzelnen 2D-Bildern und beheben Sie so einen häufigen Reibungspunkt im Online-Handel.

Gleichzeitig nutzen die „Edits“-App von Instagram und die „Vibes“-Funktion in Meta AI SAM 3, um präzise, objektspezifische Videoeffekte zu ermöglichen. Ersteller können jetzt Modifikationen wie Spotlighting oder Bewegungsspuren auf bestimmte Motive innerhalb eines Videobilds anwenden, Aufgaben, die zuvor eine komplexe Maskierung in professioneller Bearbeitungssoftware erforderten.

Ansicht in Threads

Durch die Automatisierung dieser Prozesse zielt Meta darauf ab, fortgeschrittene visuelle Effekte kommerziell zu machen und sie als Standard-Dienstprogramme für Gelegenheitsbenutzer zugänglich zu machen.

Um umfassendere Experimente zu ermöglichen, hat das Unternehmen die Funktion „Segment Anything Playground“, eine webbasierte Schnittstelle, die es der Öffentlichkeit ermöglicht, diese Modelle ohne technisches Fachwissen zu testen.

Benutzer können Bilder oder Videos hochladen und das System mit Textbeschreibungen auffordern, um die Segmentierungsfunktionen in Echtzeit anzuzeigen. Diese Strategie steht in krassem Gegensatz zur Einführung von SAM 2, das nach wie vor in erster Linie ein Werkzeug für die Computer-Vision-Forschungsgemeinschaft war.

Der sofortige Einsatz in Verbraucher-Apps deutet auf einen strategischen Dreh-und Angelpunkt hin, um KI-Fortschritte zur Benutzerbindung und-einbindung im gesamten sozialen Ökosystem von Meta zu nutzen.

Technischer Sprung: Konzeptsegmentierung und 3D

SAM 3 führt eine wichtige Funktion namens „Promptable Concept Segmentation“ (PCS) ein. Im Gegensatz zu seinen Vorgängern, die sich auf die Segmentierung einzelner Objekte anhand visueller Eingabeaufforderungen wie Klicks oder Kästchen konzentrierten, kann SAM 3 alle Instanzen eines durch Text beschriebenen Konzepts identifizieren und maskieren.

Zum Beispiel kann ein Benutzer das Modell mit einer „roten Baseballkappe“ auffordern und es segmentiert jedes passende Element im Rahmen. Diese Verschiebung erfordert, dass das Modell sowohl über semantisches Verständnis des Textes als auch über präzise Lokalisierungsfähigkeiten verfügt.

Um dies zu erreichen, entkoppelt die Architektur die Erkennung von der Lokalisierung mithilfe eines „Präsenz-Tokens“. Dieser Mechanismus ermittelt zunächst, ob ein Konzept innerhalb des Frames vorhanden ist, bevor das Modell versucht, es zu segmentieren. Dadurch werden Fehlalarme reduziert und die Erkennungsgenauigkeit insgesamt verbessert.

Laut dem Meta Research Team „verdoppelt SAM 3 die Genauigkeit bestehender Systeme sowohl im Bild-als auch im Video-PCS und verbessert frühere SAM-Funktionen bei visuellen Segmentierungsaufgaben.“

Dieser duale Ansatz ermöglicht es dem Modell, komplexe Abfragen zu verarbeiten und gleichzeitig eine hohe Leistung bei Standardsegmentierungsaufgaben aufrechtzuerhalten.

Meta Sam 3 Segmentiert alles mit Konzepte

Bei der 3D-Generierung ermöglicht SAM 3D die Rekonstruktion von Objekten und Szenen aus einem einzigen 2D-Bild, eine Aufgabe, die traditionell mehrere Blickwinkel oder Tiefendaten erforderte. Meta behauptet, dass dieses neue Modell bestehende Methoden deutlich übertrifft.

Das Meta AI-Team stellt fest, dass „es in direkten Vergleichstests zu menschlichen Präferenzen eine Siegesquote von mindestens 5:1 gegenüber anderen führenden Modellen erzielt.“ Dies ist besonders relevant für Anwendungen in Augmented Reality und Gaming, bei denen eine schnelle Asset-Generierung von entscheidender Bedeutung ist.

In Threads anzeigen

Von Meta veröffentlichte Leistungsmetriken zeigen, dass SAM 3 hocheffizient ist. Das Meta Research Team gibt außerdem an, dass „SAM 3 für ein einzelnes Bild mit mehr als 100 erkannten Objekten auf einer H200-GPU in 30 Millisekunden ausgeführt wird.“ Diese Geschwindigkeit ist für Echtzeitanwendungen auf Verbrauchergeräten unerlässlich, bei denen Latenz das Benutzererlebnis beeinträchtigen kann.

Für die menschliche Rekonstruktion verwendet SAM 3D Body ein neues Open-Source-Format.

„SAM 3D Body… nutzt ein neues Open-Source-3D-Mesh-Format namens Meta Momentum Human Rig (MHR), das eine verbesserte Interpretierbarkeit durch die Trennung der Skelettstruktur und der Weichteilform bietet.“

Diese Trennung ermöglicht eine realistischere Darstellung und anpassbare menschliche Modelle, die Auswirkungen auf virtuelle Avatare und Animationen haben könnten.

Trotz dieser Fortschritte ist das Modell nicht ohne Einschränkungen. Das Meta AI-Team gibt zu, dass „SAM 3 Schwierigkeiten hat, auf feinkörnige Konzepte außerhalb der Domäne im Nullpunkt zu verallgemeinern, wie z. B. die Identifizierung spezifischer Begriffe, die Domänenwissen erfordern, wie etwa ‚Plättchen‘.“

Dies deutet darauf hin, dass das Modell zwar robust für allgemeine Objekte ist, aber möglicherweise eine Feinabstimmung oder zusätzliche Daten erfordert, um spezielle oder seltene Kategorien effektiv zu handhaben.

Daten-Engine und Benchmarking

Durch die Nutzung eines Hybrids Daten-Engine konnte Meta seine Trainingsdaten deutlich skalieren. Das Unternehmen entwickelte ein System mit Lama-basierten „KI-Annotatoren“, um Masken zu verifizieren und auf Vollständigkeit zu prüfen, eine Aufgabe, die für Menschen allein unerschwinglich langsam wäre.

Meta erklärt, dass „durch die Delegation bestimmter Aufgaben an KI-Annotatoren – Modelle, die der menschlichen Genauigkeit entsprechen oder diese übertreffen – wir den Durchsatz im Vergleich zu einer Annotationspipeline nur für Menschen mehr als verdoppeln.“

Dieser Ansatz ermöglichte die Erstellung des SA-Co-Datensatzes, der über 4 Millionen enthält einzigartige Konzepte und 52 Millionen Masken, die ein reichhaltiges Trainingsgelände für die neuen Modelle bieten.

Neben den Modellen hat Meta den Benchmark „Segment Anything with Concepts“ (SA-Co) veröffentlicht. Dieser Datensatz enthält 207.000 einzigartige Konzepte, die zum Testen von Erkennungsfunktionen für offenes Vokabular entwickelt wurden und damit den Industriestandard für die Bewertung vorantreiben.

Die Daten-Engine ermittelt außerdem iterativ „harte Negative“ – Phrasen, die nicht in einem Bild vorkommen, aber im Widerspruch zum Modell stehen –, um die Robustheit gegenüber Fehlalarmen zu verbessern.

Über Verbraucher-Apps hinaus findet die Technologie Anwendung in der wissenschaftlichen Forschung. Eine Partnerschaft mit Conservation X Labs hat SAM 3 auf den SA-FARI-Datensatz angewendet und so die automatisierte Überwachung von Wildtieren durch Videosegmentierung unterstützt. Dieser Anwendungsfall zeigt den potenziellen Nutzen des Modells bei der Verarbeitung großer Mengen nicht kuratierter Videodaten für Forschungszwecke.

Die Veröffentlichung umfasst Modellgewichte, Code und Bewertungsdatensätze und führt damit Metas Strategie der Open-Source-Lösung wichtiger KI-Technologien fort. Durch die Bereitstellung dieser Tools möchte Meta Branchenstandards setzen und die weitere Entwicklung innerhalb der KI-Community fördern.

Zukünftige Arbeiten werden sich darauf konzentrieren, die Fähigkeit des Modells zur Verarbeitung komplexer Argumentationsabfragen zu verbessern, indem SAM 3 mit Multimodal Large Language Models (MLLMs) kombiniert wird, was möglicherweise noch anspruchsvollere Interaktionen ermöglicht.