IBM stellte heute seine Quantenprozessoren der nächsten Generation vor und beschleunigte damit seinen Zeitplan für die Entwicklung eines nützlichen Quantencomputers.

Auf seiner jährlichen Entwicklerveranstaltung am Dienstag stellte das Unternehmen den 120-Qubit-Nighthawk-Prozessor vor, der zur Lösung komplexerer Probleme entwickelt wurde. Außerdem wurde der experimentelle Loon-Chip enthüllt, ein wichtiger Schritt hin zu fehlersicheren Systemen.

Diese Hardware-Verbesserungen sowie neue Fortschritte bei der Fehlerkorrektur halten IBM auf dem Weg, bis 2026 einen „Quantenvorteil“ und bis 2029 eine fehlertolerante Maschine zu erreichen. Die Nachricht heizt den Quantenwettlauf an, nachdem der Rivale Google kürzlich einen großen Durchbruch erzielt hat.

Nighthawk und Loon: Ein zweigleisiger Sprung im Prozessordesign

Mit seiner neuesten Hardware setzt IBM darauf, dass komplexe Konnektivität und robuste Fehlerkorrektur die reinen Qubit-Anzahlen der Konkurrenten übertreffen werden. IBM stellte zwei unterschiedliche Prozessoren vor, die jeweils einen anderen Teil der Quantenherausforderung angehen.

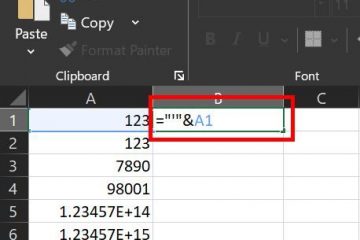

Erstens der IBM Quantum Nighthawk soll innerhalb der nächsten zwei Jahre Quantenvorteile liefern. Voraussichtlich bis Ende 2025 wird es über 120 Qubits verfügen, die durch 218 abstimmbare Koppler der nächsten Generation verbunden sind.

IBM Nighthawk Quantum Processor (Quelle: IBM)

Laut IBM wird diese Architektur es Benutzern ermöglichen, Schaltkreise mit einer um 30 Prozent höheren Komplexität als der aktuelle Heron-Prozessor auszuführen und gleichzeitig niedrige Fehlerraten beizubehalten.

IBM hat außerdem eine ehrgeizige Leistungs-Roadmap für Nighthawk-basierte Systeme entworfen, die darauf abzielt, dies zu erreichen Bis 2026 können bis zu 7.500 Zwei-Qubit-Gates und bis 2028 15.000 Gatter verwaltet werden.

Während Nighthawk die Grenzen des kurzfristigen Nutzens verschiebt, legt der experimentelle Loon-Prozessor den Grundstein für die Zukunft des fehlertoleranten Rechnens.

Loon stellt eine neuartige Architektur vor, bei der jedes Qubit mit sechs anderen verbunden ist, auch vertikal, eine Fähigkeit, die kein anderer supraleitender Quantencomputer gezeigt hat. Eine solche dichte, dreidimensionale Konnektivität ist entscheidend für die Implementierung der effizienten Fehlerkorrekturcodes, die für wirklich skalierbare Maschinen erforderlich sind.

IBM Loon-Quantenprozessor (Quelle: IBM)

Jahrelang fragten sich einige Forscher, ob solch komplexe Verbindungen machbar seien. Jay Gambetta von IBM bemerkte die Skepsis, erklärte gegenüber New Scientist, es sei, als ob die Leute sagen würden: „Sie befinden sich im Land der Theorie, das können Sie nicht realisieren.“ Und [jetzt] werden wir das zeigen [sich] irren.“

Beschleunigung der Roadmap: Fehlerkorrektur und Fertigung im industriellen Maßstab

Unter den Prozessorankündigungen verbirgt sich ein entscheidender Fertigungsmeilenstein. IBM hat seine primäre Quantenwaferproduktion in eine moderne 300-mm-Fertigungsanlage im Albany NanoTech Complex verlagert.

Durch die Umstellung auf branchenübliche Werkzeuge hat sich die Geschwindigkeit seiner Forschungs-und Entwicklungszyklen bereits verdoppelt. Es ermöglicht komplexere Chipdesigns und signalisiert den Übergang von spezialisierter Laborarbeit zur Fertigung im industriellen Maßstab, ein wichtiger Schritt für den Bau größerer Systeme.

Die Anpassung an dieses industrielle Tempo ist ein bedeutender Durchbruch bei Software und Fehlerkorrektur. IBM gab bekannt, dass es die Echtzeit-Dekodierung von Quantenfehlern mit fortschrittlichen qLDPC-Codes auf klassischer Hardware erfolgreich demonstriert hat. Dies ist ein entscheidender Schritt für die Fehlertoleranz, der ein ganzes Jahr früher als geplant erreicht wurde.

Um diese Hardwaregewinne zugänglich zu machen, verbessert IBM seinen Qiskit-Software-Stack. Eine neue C++-Schnittstelle wird dazu beitragen, die Lücke zwischen Quanten-und Hochleistungscomputerumgebungen (HPC) zu schließen.

Darüber hinaus können neue HPC-gestützte Fehlerminderungstechniken die Kosten für die Extraktion genauer Ergebnisse um mehr als das Hundertfache senken. Der Fokus auf einen kompletten Hardware-und Software-Stack steht im Mittelpunkt der Vision des Unternehmens.

Jay Gambetta, Direktor von IBM Research und IBM Fellow, erklärte: „Wir glauben, dass IBM das einzige Unternehmen ist, das in der Lage ist, schnell Quantensoftware, Hardware, Fertigung und Fehlerkorrektur zu erfinden und zu skalieren, um transformative Anwendungen freizuschalten.“

Der Quantenwettlauf heizt sich auf: IBMs Strategie in einem überfüllten Feld

In einem überfüllten Feld Bei konkurrierenden Architekturen zielt der modulare Ansatz von IBM darauf ab, zunächst eine zuverlässige Grundlage zu schaffen. Die Ankündigungen von IBM fallen in ein hart umkämpftes Umfeld.

Erst letzten Monat behauptete Google, es habe einen „überprüfbaren Quantenvorteil“ erzielt, während Konkurrent Quantinuum kürzlich seinen 98-Qubit-Helios vorgestellt hat System, das es als den genauesten kommerziellen Quantencomputer der Welt bezeichnet.

Die Strategie von IBM steht in scharfem Kontrast zu diesen Konkurrenten und anderen wie Microsoft und Amazon, die insgesamt andere Qubit-Technologien verfolgen.

Big Blue konzentriert sich auf die Perfektionierung seiner supraleitenden Qubits durch die Entwicklung besserer Konnektivität und die Entwicklung eines robusten Fehlerkorrektur-Frameworks, das auf hybriden klassischen Quantensystemen ausgeführt werden kann.

Bewältigung der grundlegenden Herausforderung von Qubits Instabilität ist eine branchenweite Anstrengung. Ein aktueller Durchbruch der Princeton University, der nichts mit der Arbeit von IBM zu tun hat, verdeutlicht die Bedeutung dieses Problems.

Dort haben Forscher ein neues Qubit-Design entwickelt, das 15-mal länger stabil bleibt als aktuelle Industriestandards.

Andrew Houck aus Princeton kommentierte den allgemeinen Fortschritt mit den Worten: „Dieser Fortschritt bringt Quantencomputer aus dem Bereich des bloß Möglichen in den Bereich des Praktischen. Jetzt können wir beginnen, viel schneller Fortschritte zu machen.“

Letztendlich Der jüngste Erfolg von IBM stellt einen wichtigen Teil des Quantenwettbewerbs neu dar. Der Schwerpunkt verlagert sich von der Rohzahl der Qubits hin zur Entwicklung überprüfbarer, wiederholbarer und praktischer Systeme. Stephen Bartlett von der University of Sydney bot eine maßvolle Perspektive auf die neuen Prozessoren und erklärte: „Es ist kein Allheilmittel, das alle Probleme löst … aber es ist dennoch ein bedeutender großer Schritt in Richtung.“ Dies.“

Indem IBM gezeigt hat, dass Kernkomponenten für eine fehlertolerante Zukunft gebaut und skaliert werden können, ist es dieser Zukunft deutlich näher gekommen.