Eine neue wissenschaftliche Studie wirft ernsthafte Zweifel an der Zuverlässigkeit der KI-gestützten Suche von Google und OpenAI auf. In einem kürzlich veröffentlichten Forschungsbericht wurde festgestellt, dass generative Suchtools häufig weniger oder weniger beliebte Quellen verwenden als die herkömmliche Google-Suche.

Die KI-Systeme haben auch mit zeitkritischen Themen zu kämpfen und zeigen innerhalb weniger Monate erhebliche Inkonsistenzen. Diese Ergebnisse deuten darauf hin, dass KI zwar schnelle Antworten liefern kann, bei Genauigkeit und Quellenqualität jedoch häufig hinterherhinkt, was eine Herausforderung für Benutzer darstellt, die auf die Suche nach aktuellen Informationen angewiesen sind.

KI-Suche setzt auf weniger, weniger beliebte Quellen

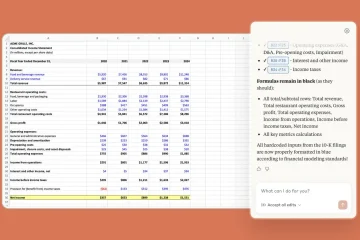

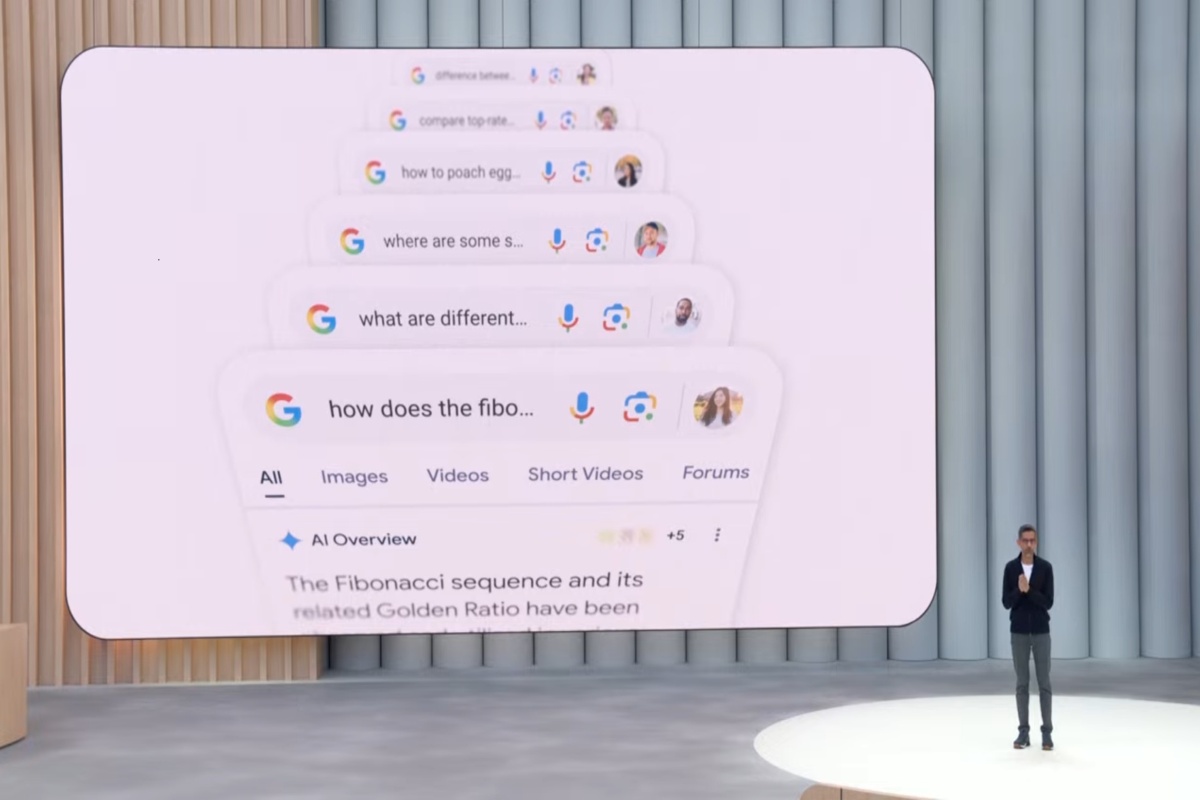

Das neue auf arXiv veröffentlichtes Papier zeigt einen grundlegenden Wandel in der Art und Weise, wie Informationen beschafft werden. Die Forscher Elisabeth Kirsten und ihre Kollegen verglichen die traditionelle Google-Suche mit vier generativen KI-Systemen – Googles AI Overview, Gemini 2.5 Flash, GPT-4o Search und GPT-4o mit einem Suchtool.

Ihre Analyse von über 4.600 Suchanfragen aus den Bereichen Allgemeinwissen, Politik, Wissenschaft und Shopping ergab, dass KI-generierte Ergebnisse häufig aus einem anderen und oft weniger prominenten Teil des Webs stammen.

Erstaunliche 53 % der Websites, die über die KI-Übersicht von Google verlinkt wurden, erschienen nicht in den Top-10-Ergebnissen einer herkömmlichen Suche. Dies weist auf eine deutliche Abweichung von den etablierten Ranking-Signalen der traditionellen Suche hin.

GPT-4o von OpenAI mit einem Suchtool zitierte deutlich weniger Quellen als seine Gegenstücke und stützte sich im Durchschnitt auf nur 0,4 Webseiten pro Abfrage und stützte sich dabei stark auf sein internes, vorab trainiertes Wissen.

Im Gegensatz dazu zitierten Googles AI Overview und Gemini beide im Durchschnitt über 8,5 Seiten, was eine größere Zahl darstellt Abhängigkeit vom externen Webabruf. Bei mehrdeutigen Suchanfragen stellte die Studie fest, dass die herkömmliche Suche immer noch eine bessere Abdeckung mehrerer Standpunkte bietet.

Instabil und unzuverlässig: KI-Antworten ändern sich von Tag zu Tag

Über die Beschaffung hinaus deckt die Studie einen kritischen Fehler in der Konsistenz auf. Generative Suchmaschinen scheinen sehr volatil zu sein, da sich ihre Antworten und Quellen in kurzen Zeiträumen dramatisch ändern.

Um dies zu testen, wiederholten die Forscher ihre Abfragen im Abstand von zwei Monaten und maßen die Stabilität der Ergebnisse. Für Benutzer, die zuverlässige und wiederholbare Informationen erwarten, war das Ergebnis besorgniserregend.

Die Ergebnisse des erneuten Tests waren enttäuschend. Die herkömmliche Google-Suche behielt eine Konsistenz von 45 % bei den präsentierten Quellen bei. Googles KI-Übersicht zeigte im Vergleich nur eine Konsistenz von 18 %, was bedeutet, dass die zugrunde liegenden Quellen von Test zu Test fast völlig unterschiedlich waren.

Diese Instabilität deutet darauf hin, dass sich die synthetisierten Antworten, die Benutzer erhalten, nicht nur von der herkömmlichen Suche unterscheiden, sondern auch von einem Tag auf den anderen unvorhersehbar sind, was ihre Zuverlässigkeit für ernsthafte Recherche-oder Überprüfungsaufgaben untergräbt.

Kampf mit dem „Jetzt“: KI scheitert bei zeitkritischen Nachrichten

Bei zeitkritischen Anfragen zu aktuellen Ereignissen deckte die Studie kritische Fehler auf, die die Gefahr verdeutlichen, sich auf KI-Modelle mit veraltetem internem Wissen zu verlassen. Die Forscher testeten die Systeme anhand von Trendthemen, darunter eine Abfrage zur „Todesursache von Ricky Hatton“, einem ehemaligen Boxer, der im September 2025 verstorben war.

Beide GPT-Modelle haben den Test nicht bestanden, wenn sie sich nicht stark auf Echtzeitabrufe aus dem Internet verlassen haben. Sie berichteten fälschlicherweise, dass Hatton noch am Leben sei, ein erheblicher sachlicher Fehler, der auf den fehlenden Zugang zu aktuellen Informationen zurückzuführen ist.

Dieser konkrete Fehler zeigt eine Kernschwäche: Ohne robuste, dynamische Abfrage kann die KI-Suche gefährlich veraltete Informationen sicher als Tatsachen darstellen. Während abrufgestützte Systeme wie Gemini eine bessere Leistung erbrachten, unterstreicht der Vorfall die Risiken für aktuelle Nachrichten oder sich entwickelnde Ereignisse.

Eine wachsende Vertrauenslücke im KI-Informationskrieg

Solche Muster der Unzuverlässigkeit spiegeln aktuelle Ergebnisse einer bahnbrechenden BBC-Studie wider, in der erhebliche Fehler in 45 % der nachrichtenbezogenen Antworten von KI-Assistenten festgestellt wurden. In diesem Bericht wurde auf die Verwendung von „zeremoniellen Zitaten“ hingewiesen – Links, die maßgeblich wirken, die aufgestellten Behauptungen jedoch nicht wirklich stützen.

Jean Philip De Tender, Mediendirektor der EBU, wies auf den systemischen Charakter des Problems hin. „Diese Untersuchung zeigt schlüssig, dass diese Versäumnisse keine Einzelfälle sind. Sie sind systemisch, grenzüberschreitend und mehrsprachig, und wir glauben, dass dies das Vertrauen der Öffentlichkeit gefährdet.“

Eine wachsende Zahl von Beweisen schürt einen bereits angespannten Konflikt zwischen Technologieplattformen und Nachrichtenverlegern. Verleger argumentieren, dass KI-Suchmaschinen nicht nur unzuverlässig sind, sondern ihr Geschäft aktiv schädigen, indem sie Inhalte aussortieren, um direkte Antworten zu liefern, sodass Benutzer nicht mehr zur Originalquelle durchklicken müssen.

Dieser Trend, der durch eine Studie des Pew Research Center bestätigt wurde, die zeigt, dass die Klicks sinken, wenn KI-Übersichten erscheinen, unterbricht den seit langem bestehenden Werteaustausch des offenen Webs.

Wie Danielle Coffey, CEO von News/Media Alliance drückte es so aus: „Links waren die letzte erlösende Qualität der Suche, die den Verlagen Traffic und Einnahmen bescherte. Jetzt nimmt Google Inhalte einfach mit Gewalt und verwendet sie ohne Gegenleistung.“

Letztendlich argumentieren die Autoren des Papiers, dass der gesamte Rahmen zur Beurteilung der Suchqualität für das KI-Zeitalter überarbeitet werden muss. Aktuelle Metriken, die für Ranglisten von Links entwickelt wurden, reichen für die Bewertung dieser neuen Systeme nicht aus.

„Unsere Arbeit zeigt den Bedarf an neuen Bewertungsmethoden, die gemeinsam Quellenvielfalt, konzeptionelle Abdeckung und Syntheseverhalten in generativen Suchsystemen berücksichtigen.“

Die Autoren betonen auch die Notwendigkeit besserer Mechanismen, um mit der Schnelllebigkeit von Online-Informationen umzugehen.

„Diese Ergebnisse unterstreichen dies.“ Es ist wichtig, zeitliches Bewusstsein und dynamisches Abrufen in generative Suchbewertungsrahmen zu integrieren.“

Bis solche Standards entwickelt und übernommen werden, bleibt das Versprechen einer intelligenteren, schnelleren KI-Suche durch anhaltende Probleme mit Zuverlässigkeit, Konsistenz und Vertrauen getrübt.