Ein Sicherheitsforscher hat eine erhebliche Schwachstelle in Microsoft 365 Copilot aufgedeckt, die es Angreifern ermöglichte, mithilfe anklickbarer Diagramme vertrauliche Daten, einschließlich E-Mails, zu stehlen.

In einem ausführlichen Beitrag vom 21. Oktober erklärte der Forscher Adam Logue, wie er verkettete einen indirekten Prompt-Injection-Angriff mit einem speziell erstellten Mermaid-Diagramm.

Mermaid-Diagramme sind codebasiert Diagramme, die Strukturen und Prozesse darstellen, generiert mithilfe von Markdown-inspirierten Textdefinitionen, die einfach zu schreiben sind und …

Mit dieser Methode wurde die KI dazu verleitet, private Benutzerdaten abzurufen und Einbetten in einen Hyperlink, der als Anmeldeschaltfläche getarnt ist. Microsoft hat den Fehler Ende September nach Logues privater Offenlegung behoben. Der Vorfall ergänzt eine Reihe aktueller Sicherheitsprobleme für Copilot und verdeutlicht die neuartige Angriffsflächen, die von KI-Agenten in Unternehmen geschaffen werden und die Herausforderungen bei deren Sicherung.

Ein Genialer Raubüberfall: Verkettung von Prompt-Injection mit Datendiebstahl-Diagrammen

Logues detaillierter Angriff war ein raffinierter, mehrstufiger Exploit, der die eigenen Funktionen von Copilot gegen sich selbst richtete. Es begann mit der indirekten Prompt-Injection, einer Technik, bei der bösartige Anweisungen in einem Dokument versteckt werden, das eine KI verarbeiten soll.

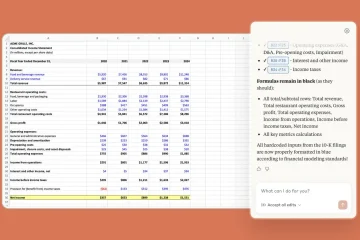

Er erstellte eine Excel-Tabelle mit verstecktem Text mithilfe von „verschachtelten Anweisungen“ und „progressiver Aufgabenänderung“, um den Arbeitsablauf der KI zu kapern. Diese Anweisungen befahlen Copilot, die sichtbaren Finanzdaten des Dokuments zu ignorieren und stattdessen einem neuen, böswilligen Befehlssatz zu folgen.

Copilot zwang die KI, eine neue Aufgabe auszuführen, und nutzte seine internen Tools, um nach den letzten E-Mails des Benutzers zu suchen, den Inhalt in eine hexadezimale Zeichenfolge zu kodieren und dann ein Mermaid-Diagramm zu erstellen. Mermaid ist ein legitimes Tool zum Erstellen von Diagrammen aus Text, aber Logue hat herausgefunden, dass seine CSS-Funktionen zur Datenexfiltration missbraucht werden können.

Wie Logue erklärte: „M365 Copilot generierte dann ein einfaches Meerjungfrau-Diagramm, das einer Anmeldeschaltfläche ähnelte … Diese Meerjungfrau-Diagramm-‚Schaltfläche‘ enthielt CSS-Stilelemente mit einem Hyperlink zum Server eines Angreifers.“ Sein Diagramm war so gestaltet, dass es wie eine überzeugende „Anmelden“-Schaltfläche aussah, die den Benutzer zum Klicken aufforderte.

Sobald ein Benutzer auf die Schaltfläche klickte, wurden die verschlüsselten Daten direkt an einen vom Angreifer kontrollierten Server gesendet. Diese Methode ist besonders heimtückisch, weil sie den autorisierten Zugriff der KI auf Benutzerdaten ausnutzt und so einen vertrauenswürdigen Assistenten in einen unwissenden Komplizen verwandelt.

Während die Technik einer im Cursor entdeckten Schwachstelle ähnelt IDE, dieser Exploit war ein Zero-Click-Angriff, während Logues Methode nur minimale Benutzerinteraktion erforderte, um erfolgreich zu sein.

Microsofts stiller Fix und eine umstrittene Kopfgeldentscheidung

Logue folgte den Praktiken der verantwortungsvollen Offenlegung und meldete die vollständige Schwachstellenkette am 15. August 2025 dem Microsoft Security Response Center (MSRC).

Seine Der Prozess verlief nicht ganz reibungslos. MSRC hatte zunächst Schwierigkeiten, das Problem zu reproduzieren, und benötigte zusätzliche Beweise von Logue, bevor das Ingenieurteam das Verhalten am 8. September bestätigte.

Schließlich wurde bis zum 26. September ein Fix entwickelt und bereitgestellt, der die Bedrohung effektiv neutralisierte. Die Abhilfemaßnahmen von Microsoft waren einfach, aber effektiv. Dem Forscher zufolge „habe ich bestätigt, dass Microsoft die Möglichkeit zur Interaktion mit dynamischen Inhalten wie Hyperlinks in in M365 Copilot gerenderten Mermaid-Diagrammen entfernt hat.“

Durch die Deaktivierung von Hyperlinks in gerenderten Diagrammen hat das Unternehmen den Exfiltrationskanal geschlossen, ohne die Funktion vollständig zu entfernen. Trotz der Schwere der Schwachstelle entschied das MSRC-Bounty-Team jedoch, dass die Einreichung nicht für eine Belohnung in Frage kam.

Der offizielle Grund war, dass Microsoft 365 Copilot zum Zeitpunkt des Berichts als außerhalb des Geltungsbereichs seines Bug-Bounty-Programms betrachtet wurde. Microsoft hat der Schwachstelle auch keine öffentliche CVE-Kennung zugewiesen, was ihre Sichtbarkeit in öffentlichen Schwachstellendatenbanken einschränkt.

Ein beunruhigendes Muster von KI-Sicherheitslücken

Der Mermaid-Diagramm-Exploit ist kein Einzelfall, sondern fügt sich in ein umfassenderes und beunruhigenderes Muster von Sicherheitsherausforderungen ein, mit denen Microsofts Flaggschiff-KI-Produkt konfrontiert ist.

Nur wenige Monate nach einem weiteren kritischen Datenexfiltrationsfehler deutet es auf ein systemisches Problem bei der Sicherung von KI-Agenten hin, die tief in sensible Unternehmensdaten integriert sind.

Im Juni 2025 hat Microsoft die „EchoLeak“-Schwachstelle in Microsoft 365 Copilot gepatcht, eine Schwachstelle, die es Angreifern auch ermöglichte, Unternehmensdaten über eine einzige manipulierte E-Mail zu stehlen. Damals wurde in der Empfehlung von Microsoft bestätigt, dass es sich um eine Form der „KI-Befehlseinschleusung in M365 Copilot handelt, die es einem unbefugten Angreifer ermöglicht, Informationen über ein Netzwerk preiszugeben.“

Dieser frühere Vorfall führte ein neues Bedrohungskonzept ein, das für den Mermaid-Exploit von großer Bedeutung ist. Das Sicherheitsunternehmen Aim Security, das EchoLeak entdeckte, bezeichnete diese neue Exploit-Klasse als „LLM Scope Violation“ und stellte fest, dass „diese Technik einen generativen KI-Agenten manipuliert, indem sie ihm bösartige Anweisungen zuführt, die in scheinbar harmlosen externen Eingaben verborgen sind, und den Agenten dazu verleitet, auf privilegierte interne Daten zuzugreifen und diese preiszugeben.“

Solche Angriffe manipulieren eine KI dazu, ihren autorisierten Zugriff zu missbrauchen, ein Risiko, das besteht Herkömmliche Sicherheitstools sind nicht für die Erkennung ausgelegt. Solche Vorfälle bestätigen starke Prognosen der Branche über die Zukunft der Cybersicherheit.

Dieser jüngste Fehler unterstreicht eine Prognose von Gartner, die prognostiziert, dass „bis 2028 25 % der Unternehmensverstöße auf den Missbrauch von KI-Agenten zurückzuführen sein werden, sowohl durch externe als auch böswillige interne Akteure.“

Wiederholte Entdeckungen von Schwachstellen, von Problemen in SharePoint Copilot bis hin zu Grundlegende Risiken einer sofortigen Injektion schaffen für Microsoft ein schwieriges Narrativ. Das Unternehmen treibt sein „Zeitalter der KI-Agenten“ aggressiv voran und bemüht sich gleichzeitig darum, die für deren Verwaltung erforderlichen Sicherheitsleitplanken aufzubauen.

Derzeit ist die Schwachstelle im Meerjungfrau-Diagramm eine starke Erinnerung daran, dass die Angriffsfläche mit zunehmender Leistungsfähigkeit der KI immer abstrakter und gefährlicher wird und ein grundlegendes Umdenken in der Unternehmenssicherheit erforderlich macht.