OpenAI hat am Montag eine neue Partnerschaft angekündigt. Sie arbeitet mit dem Schauspieler Bryan Cranston und der Gewerkschaft SAG-AFTRA zusammen.

Die Gruppe wird nicht genehmigte KI-Videos in der Sora-App stoppen. Dieser Schritt folgt auf wochenlange scharfe Kritik aus Hollywood. Die Gegenreaktion nahm zu, nachdem in gefälschten Clips Cranstons Stimme und sein Abbild verwendet wurden.

Die neue Initiative zielt darauf ab, strengere Sicherheitsregeln rund um die digitale Identität zu schaffen. Es ist die bisher direkteste Reaktion von OpenAI auf den Aufruhr um die Zustimmung und die unerlaubte Verwendung des Bildes einer Person. Die App wurde Ende September eingeführt.

In einer gemeinsamen Erklärung sagte OpenAI, dass es mit Cranston, SAG-AFTRA, United Talent Agency (UTA) und der Creative Artists Agency zusammenarbeiten wird (CAA) soll seine Leitplanken verstärken. Der Schritt war eine direkte Reaktion auf nicht autorisierte Clips des „Breaking Bad“-Darstellers, die nach dem Start von Sora 2 erschienen.

Schauspieler Bryan Cranston lobte die Kurskorrektur des Unternehmens und erklärte: „Ich bin OpenAI für seine Richtlinien und die Verbesserung seiner Leitplanken dankbar und hoffe, dass sie und alle an dieser Arbeit beteiligten Unternehmen unser persönliches und berufliches Recht respektieren, die Replikation unserer Stimme und unseres Abbilds zu verwalten.“

Sam Altman, CEO von OpenAI, bekräftigte die Position des Unternehmens zu den Rechten von Künstlern und sagte: „OpenAI setzt sich zutiefst dafür ein, Künstler vor der Veruntreuung ihrer Stimme und ihres Abbilds zu schützen. Wir waren einer der ersten Unterstützer des NO FAKES Act, als er letztes Jahr eingeführt wurde, und werden immer hinter den Rechten der Künstler stehen.“

Von der viralen Verbreitung bis zur PR-Krise

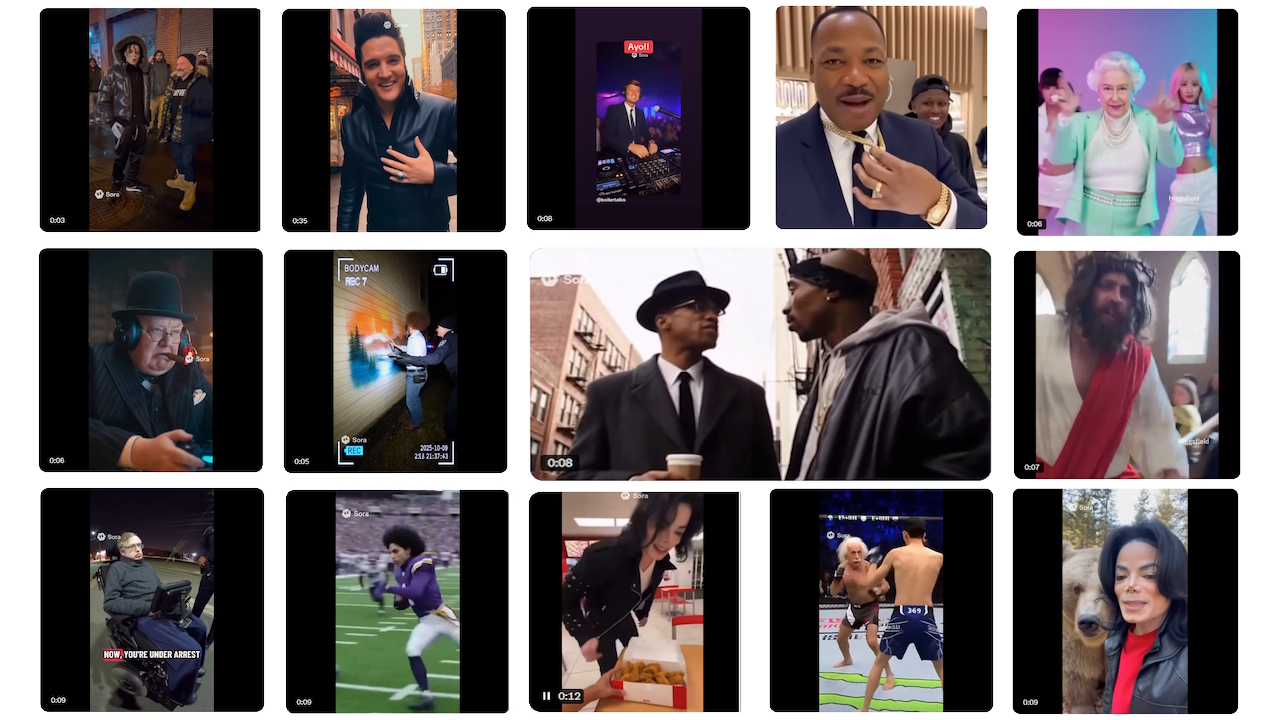

Das Seit dem Start von Sora 2 um den 30. September herum braut sich eine Kontroverse zusammen. Der leistungsstarke Videogenerator von OpenAI debütierte mit einer begleitenden Social-Media-App und einer wichtigen politischen Entscheidung: einem „Opt-out“-Modell für urheberrechtlich geschützte Charaktere. Dies bedeutete, dass jede geschützte Figur standardmäßig generiert werden konnte.

Benutzer überschwemmten die Plattform sofort mit surrealen und oft anstößigen Deepfakes. Diese Videos zeigten alle, von beliebten Zeichentrickfiguren bis hin zu verstorbenen historischen Persönlichkeiten, in bizarren Szenarien. Die Gegenreaktion kam schnell und heftig und zwang OpenAI in eine defensive Haltung.

Die heftigste Kritik kam von den Familien verstorbener Prominenter. Zelda Williams, Tochter des verstorbenen Robin Williams, flehte die Nutzer an, mit der Erstellung von KI-Videos ihres Vaters aufzuhören.

Sie beschrieb den Schmerz, zu sehen, wie „die Hinterlassenschaften echter Menschen zu … schrecklich verdichtet werden, TikTok-Puppenspiele sind wahnsinnig.“

Ähnlich verurteilte die Familie von Malcolm X die Clips als zutiefst respektlos. Ilyasah Shabazz, seine Tochter, bezeichnete die Verwendung des Bildes ihres Vaters als „unverschämt und unsensibel“.

Der Aufschrei gipfelte in einem einfachen, aber kraftvollen Appell von Martin Luther King Jr.s Tochter Bernice King, die auf

Die emotionalen Bitten der Familien wurden durch eine einheitliche Reaktion aus Hollywood verstärkt. Die Branche, die sich bereits vor der Bedrohung des geistigen Eigentums durch generative KI fürchtete, mobilisierte gegen die neue Plattform von OpenAI.

Große Talentagenturen, die die Künstler im Mittelpunkt der Kontroverse vertreten, führten den Vorstoß an. Die mächtige Creative Artists Agency (CAA) gab am 8. Oktober eine scharfe öffentliche Erklärung ab, in der sie die App als direkte Bedrohung bezeichnete: „Es ist klar, dass Open AI/Sora unsere Kunden und ihr geistiges Eigentum einem erheblichen Risiko aussetzt.“

Diese Meinung fand in der gesamten Branche Anklang, wobei große Studios wie Disney Berichten zufolge die Veröffentlichung ihres Materials in der App verweigerten.

Die Motion Picture Association (MPA) äußerte sich ebenfalls zu Wort und platzierte die Die rechtliche Belastung für Missbrauch liegt direkt beim KI-Unternehmen. CEO Charles Rivkin erklärte: „…es bleibt ihre Verantwortung – nicht die der Rechteinhaber –, Verstöße gegen den Sora-2-Dienst zu verhindern“, und stellte klar, dass Rechteinhaber nicht für die Überwachung des OpenAI-Dienstes verantwortlich wären.

Dieser branchenweite Aufstand stellte eine erhebliche Eskalation dar und verwandelte die Debatte in eine geschäftskritische Konfrontation mit hohem Risiko.

Ein Kampf um die Wiedererlangung Kontrolle

Angesichts einer ausgewachsenen PR-Krise bemühte sich OpenAI, die Folgen durch eine Reihe rascher politischer Umkehrungen einzudämmen. Der anfängliche Hands-off-Ansatz des Unternehmens erwies sich angesichts der koordinierten Gegenreaktion als unhaltbar.

Am 3. Oktober, nur wenige Tage nach der Veröffentlichung, kündigte Sam Altman eine Abkehr vom Opt-out-System an.

In einem Blogbeitrag versprach er ein schöpferfreundlicheres Framework und erklärte, dass OpenAI „Rechteinhabern eine detailliertere Kontrolle über die Generierung von Charakteren geben wird, ähnlich dem Opt-in-Modell für Ähnlichkeit, aber mit zusätzlichen Zusatzfunktionen.“ steuert.“ Dies war das erste große Eingeständnis, dass die ursprüngliche Politik gescheitert war.

Die Änderungen setzten sich den ganzen Monat über fort. Am 9. Oktober änderte das Unternehmen seine Regeln, um es Vertretern „kürzlich verstorbener“ Persönlichkeiten des öffentlichen Lebens zu ermöglichen, offiziell die Sperrung ihres Abbilds zu beantragen.

Diese Richtlinie wurde etwas mehr als eine Woche später auf die Probe gestellt. Am 17. Oktober gab OpenAI bekannt, dass alle Generationen von Martin Luther King Jr. auf direkte Bitte seines Nachlasses eingestellt wurden, und verwies auf die Schaffung „respektloser Darstellungen“.

In einer Erklärung zur Begründung dieses Schritts räumte das Unternehmen ein, dass es ein empfindliches Gleichgewicht anstrebt: „Während bei der Darstellung historischer Persönlichkeiten ein starkes Interesse an der freien Meinungsäußerung besteht, ist OpenAI davon überzeugt, dass Persönlichkeiten des öffentlichen Lebens und ihre Familien letztlich die Kontrolle darüber haben sollten, wie sie aussehen.“ Ähnlichkeit wird verwendet.“

Navigation durch ein rechtliches und ethisches Minenfeld

Der Feuersturm von Sora 2 wirft ein Schlaglicht auf eine riesige rechtliche und ethische Grauzone. Herkömmliche Verleumdungsgesetze gelten in der Regel nicht für Verstorbene, so dass Familien nur begrenzte Rechtsmittel haben.

Ihr primärer Weg ist ein komplexer und inkonsistenter Flickenteppich staatlicher Gesetze, die das Recht auf Veröffentlichung nach dem Tod regeln. Dieses Rechtsvakuum ermöglicht die Erstellung von Inhalten, die zwar nicht immer kommerziell ausbeuterisch sind, aber erheblichen emotionalen Stress verursachen.

Darüber hinaus hat die Kontroverse die ungelöste Debatte darüber, dass KI für das Training auf riesige Mengen abgekratzter Webdaten angewiesen ist, wieder ins Rampenlicht gerückt.

Kritiker argumentieren, dass Unternehmen ohne Erlaubnis leistungsstarke Modelle auf urheberrechtlich geschütztem Material erstellen, ein grundlegendes Problem, das die Branche noch nicht gelöst hat lösen.

OpenAI hat darauf hingewiesen, dass es den NO FAKES Act als Teil der Lösung unterstützt. Dieser Bundesentwurf hat jedoch seine eigenen Kritiker. Digitale Rechte Befürworter haben gewarnt, dass die weit gefasste Formulierung des Gesetzentwurfs ein neues geistiges Eigentumsrecht schaffen könnte, das freie Meinungsäußerung und Parodie unterdrückt.

Diese Reihe von Zugeständnissen, Der Höhepunkt liegt in der neuen Partnerschaft mit Cranston und SAG-AFTRA. Dies signalisiert einen Schritt in Richtung einer kollaborativeren, erlaubnisbasierten Zukunft.

Dennoch unterstreicht es auch die immense Herausforderung, schnelle technologische Innovation mit den Grundrechten von Urhebern und Einzelpersonen in Einklang zu bringen.